This is the multi-page printable view of this section. Click here to print.

数据库

- 数据库老司机:文章导航

- 七周七数据库(2025年)

- 自建Supabase:创业出海的首选数据库

- 面向未来数据库的现代硬件

- PZ:MySQL还有机会赶上PostgreSQL的势头吗?

- 开源“暴君”Linus清洗整风

- 先优化碳基BIO核,再优化硅基CPU核

- MongoDB没有未来:好营销救不了烂芒果

- MongoDB: 现在由PostgreSQL强力驱动?

- 瑞士强制政府软件开源

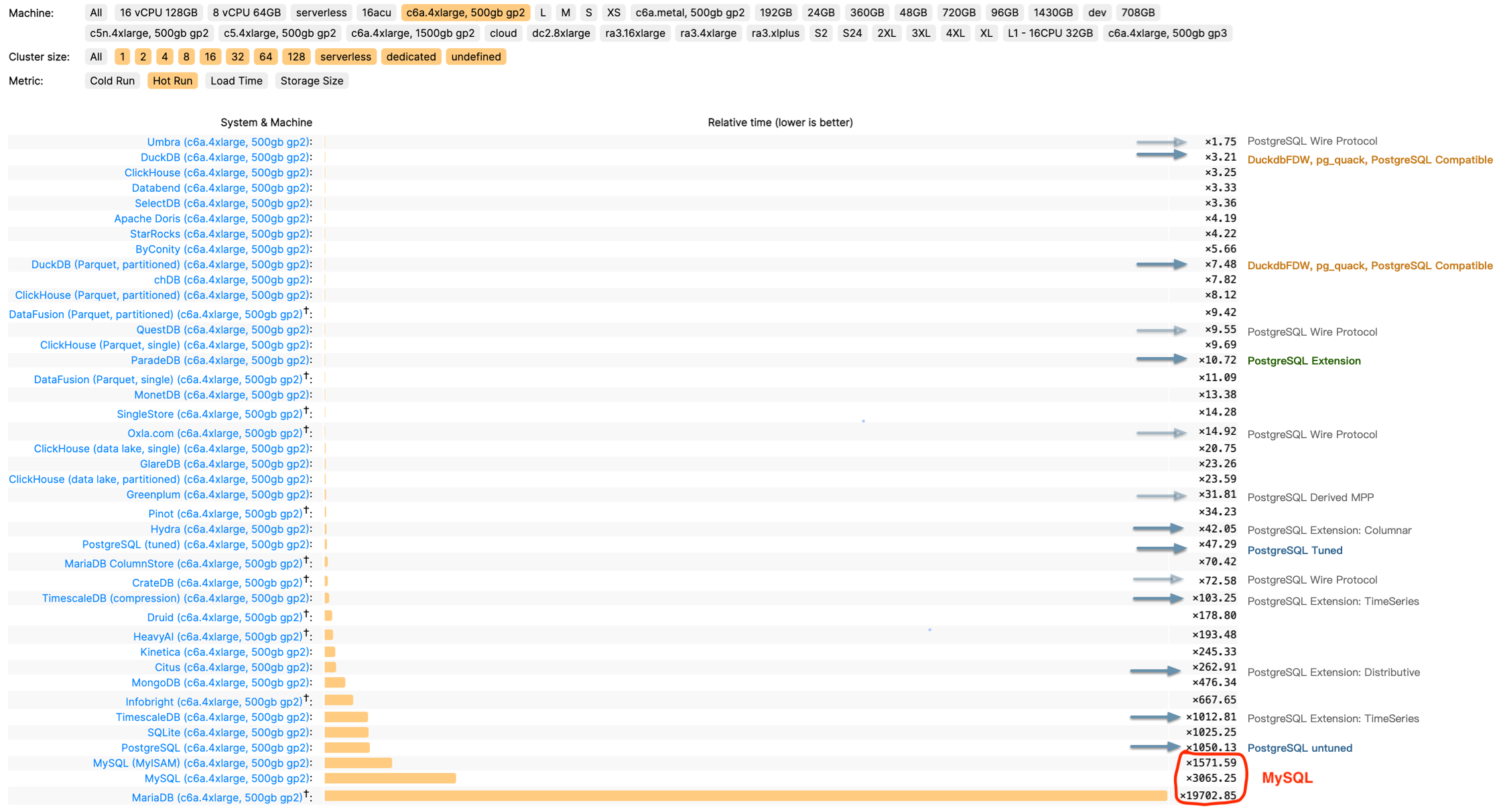

- MySQL 已死,PostgreSQL 当立

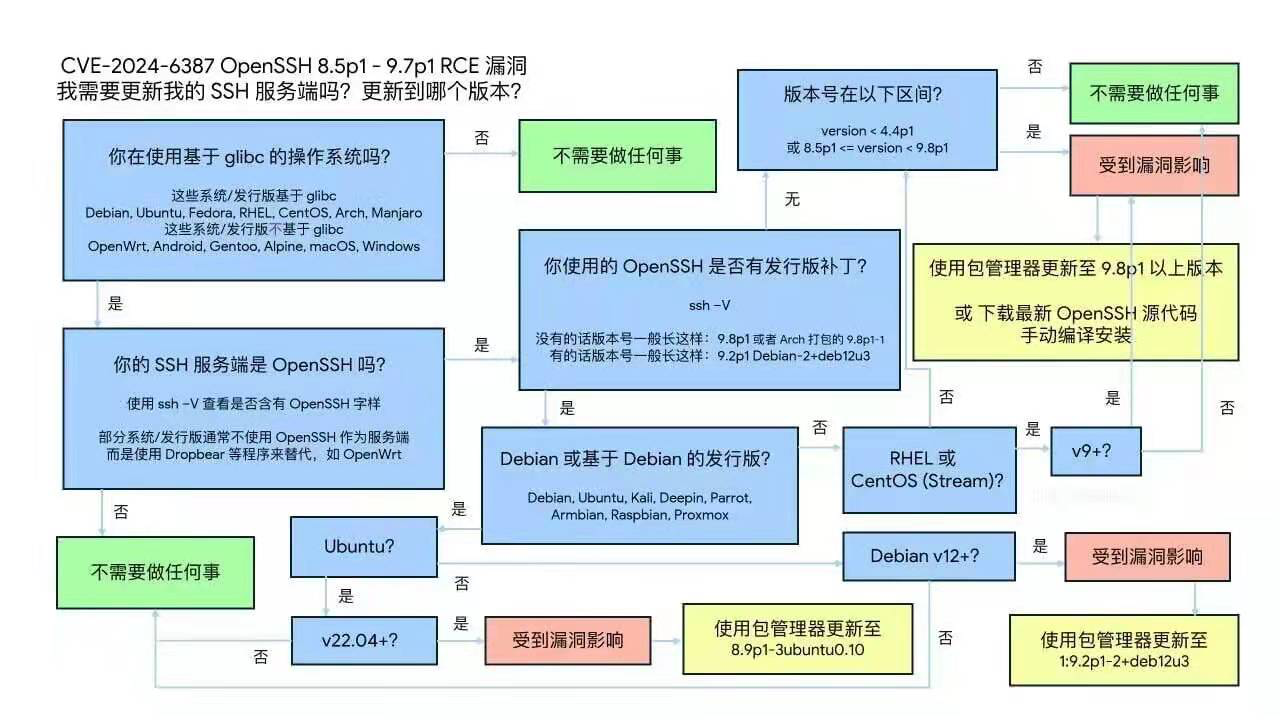

- CVE-2024-6387 SSH 漏洞修复

- Oracle 还能挽救 MySQL 吗?

- Oracle最终还是杀死了MySQL

- MySQL性能越来越差,Sakila将何去何从?

- 20刀好兄弟PolarDB:论数据库该卖什么价?

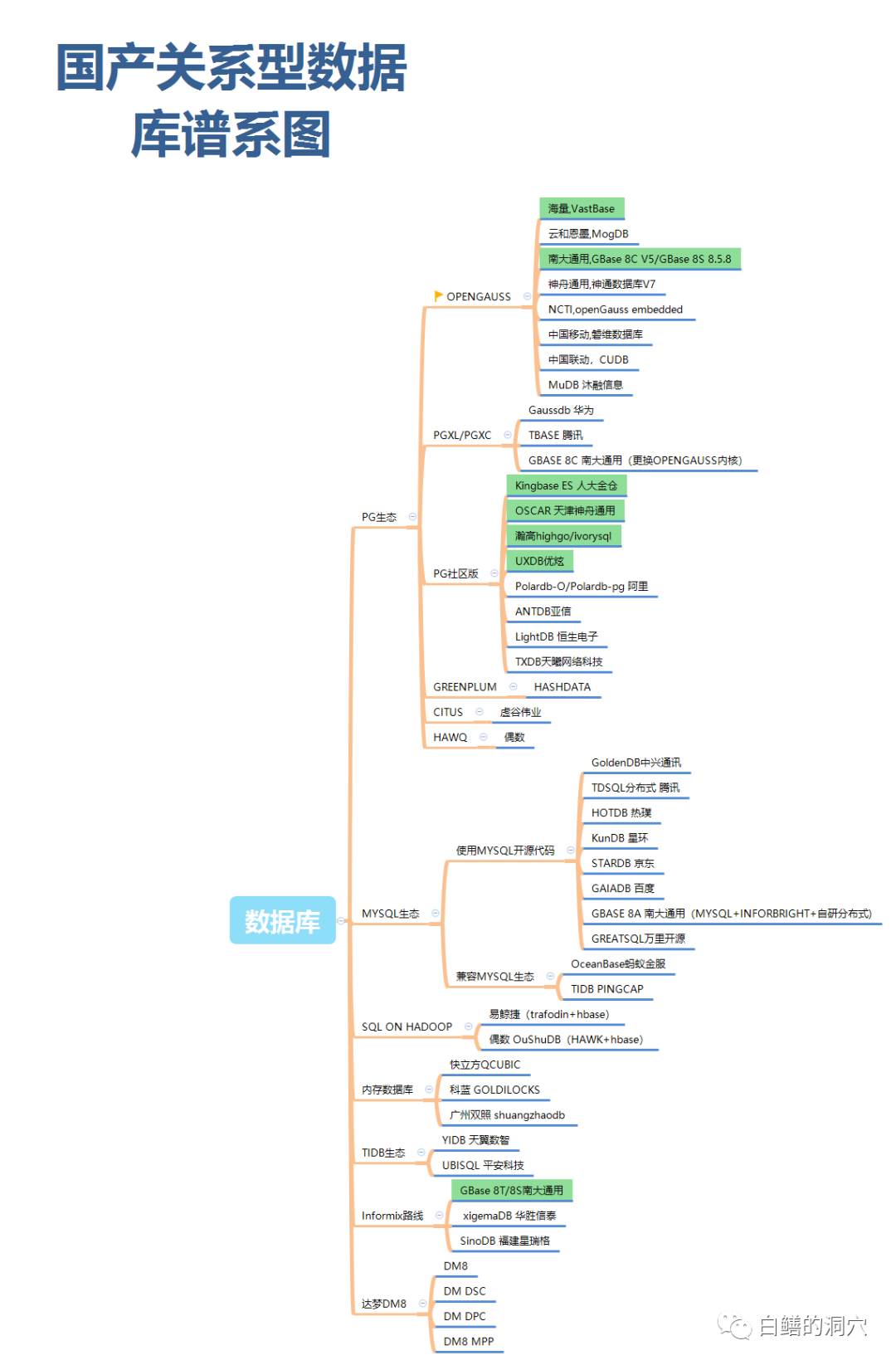

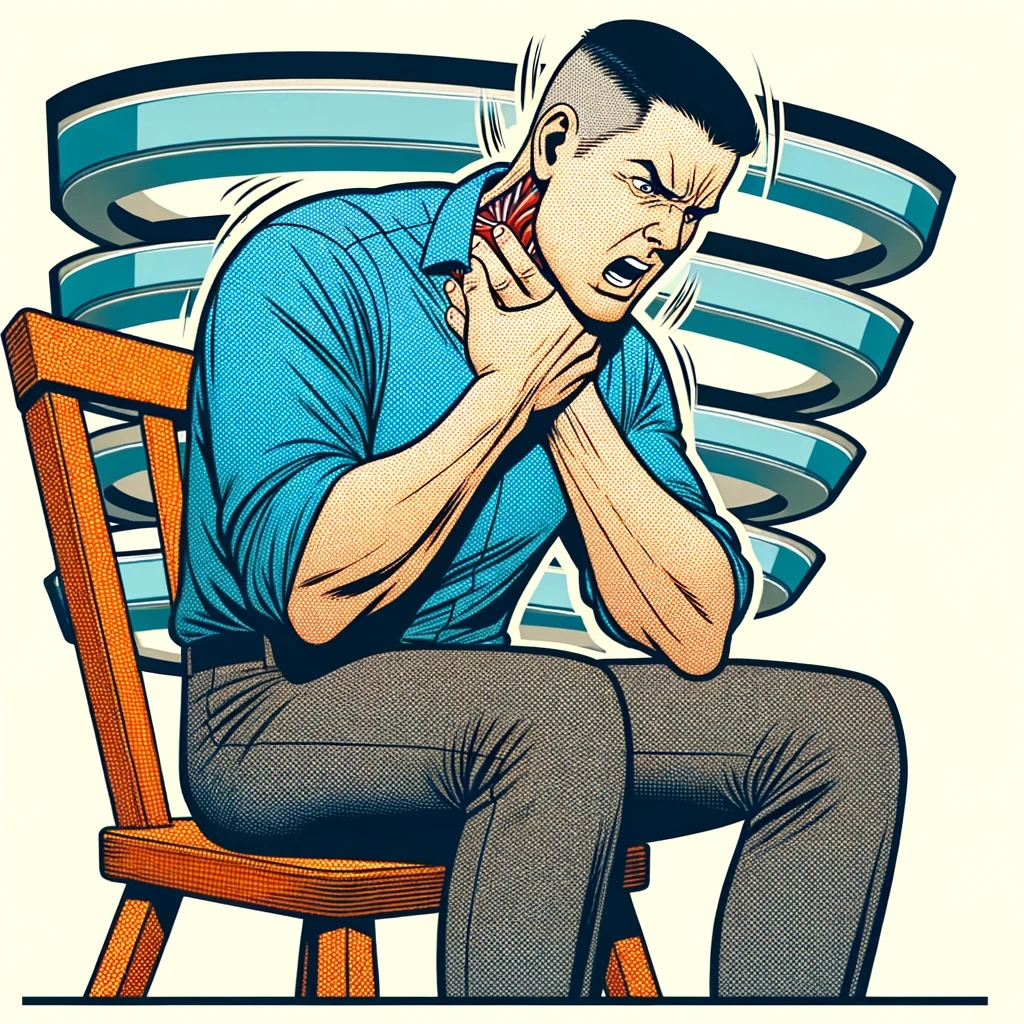

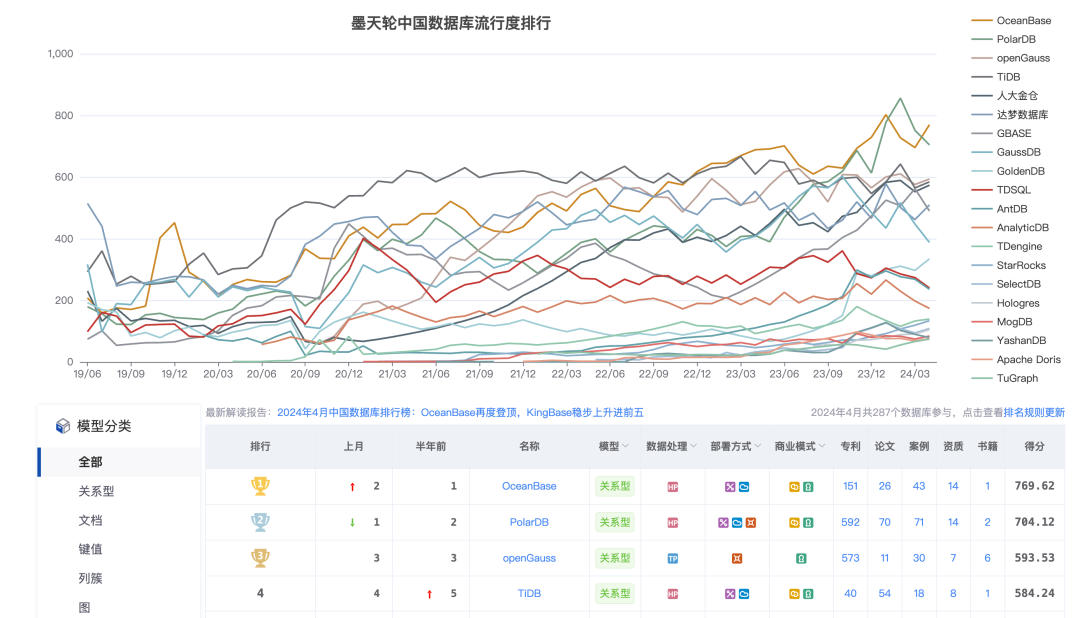

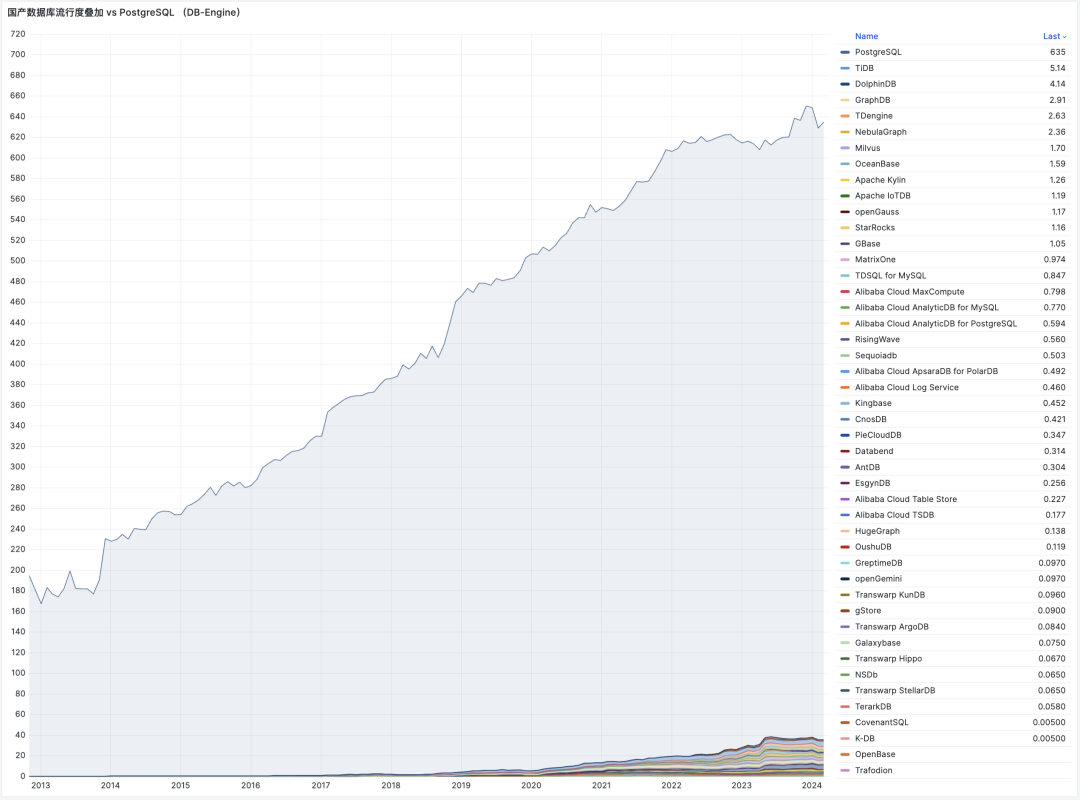

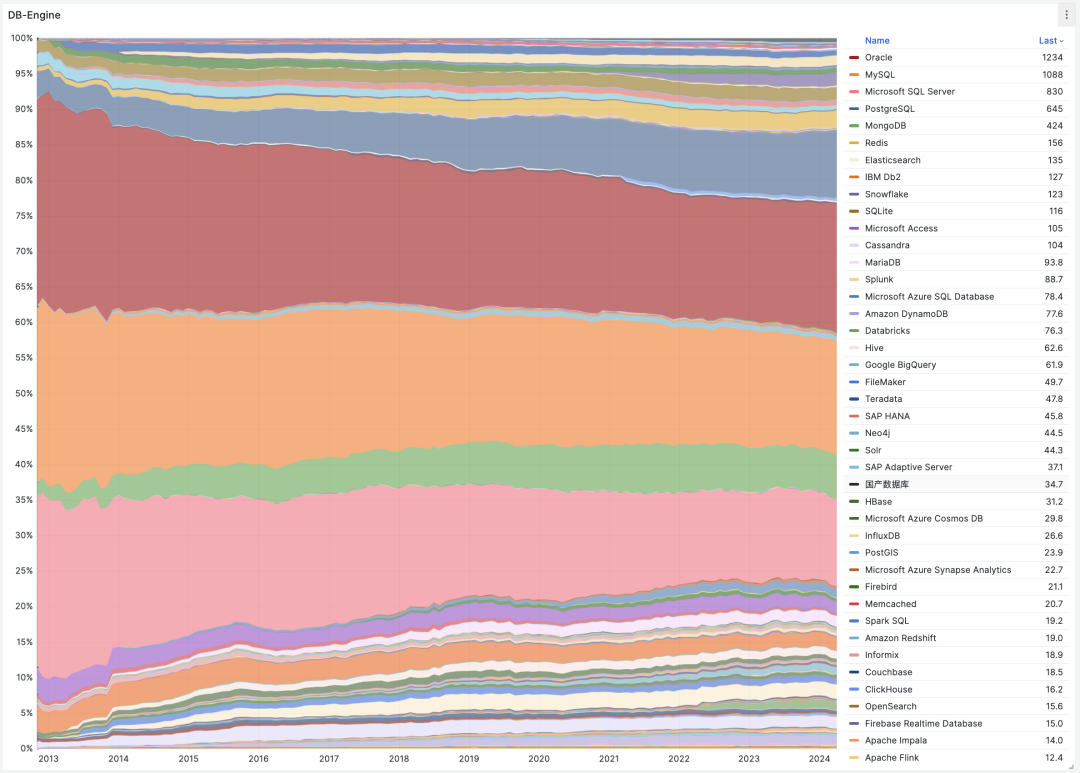

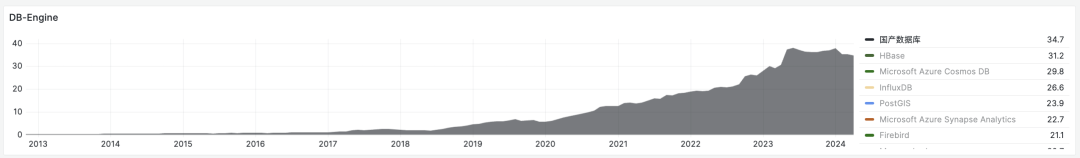

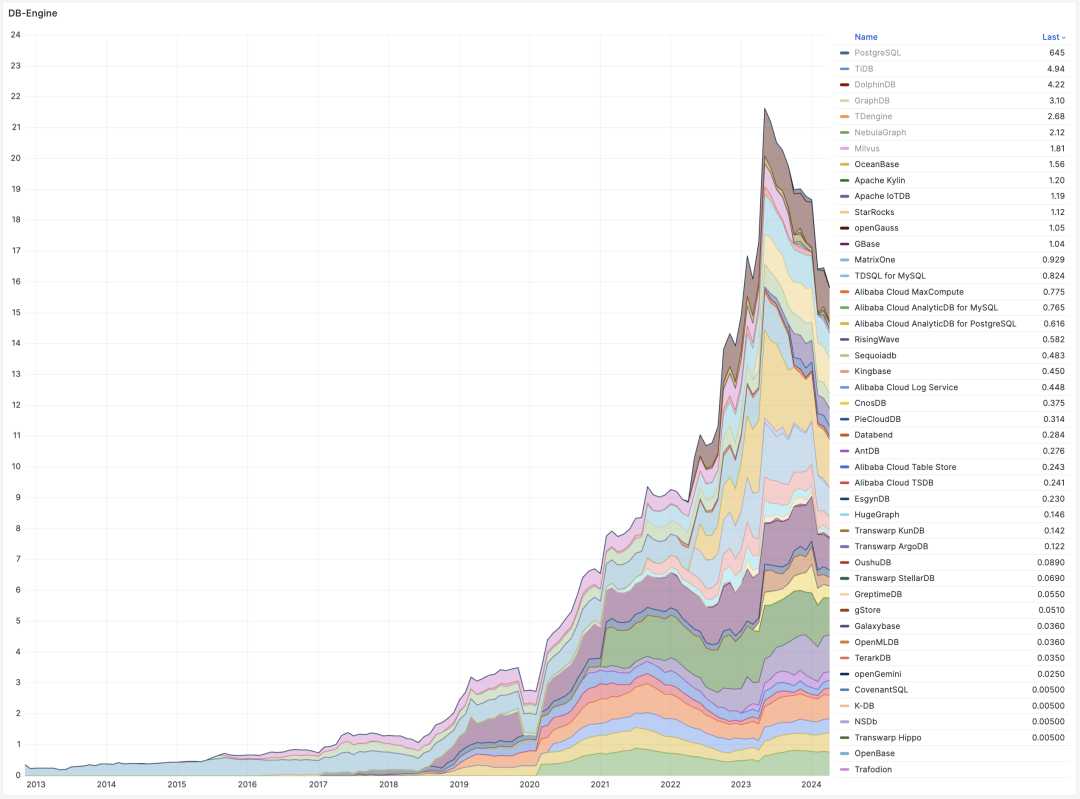

- 国产数据库到底能不能打?

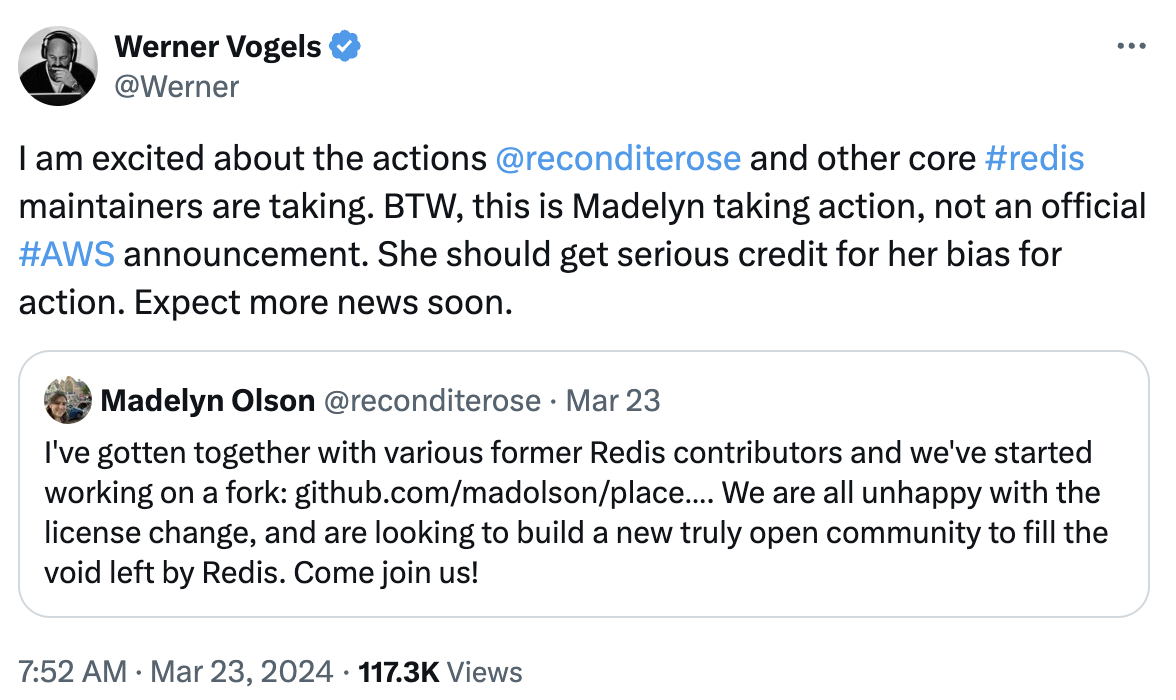

- Redis不开源是“开源”之耻,更是公有云之耻

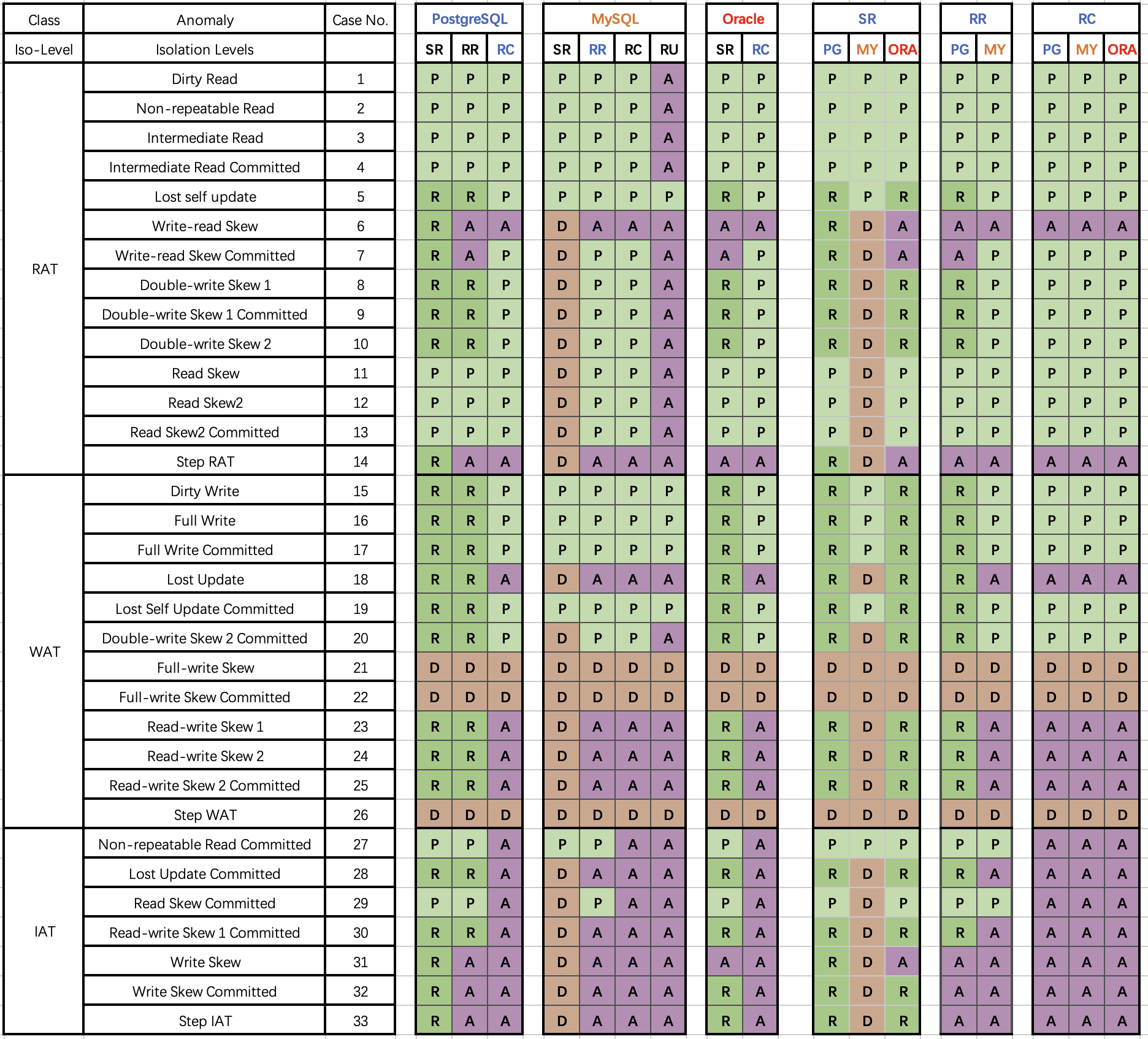

- MySQL正确性竟如此垃圾?

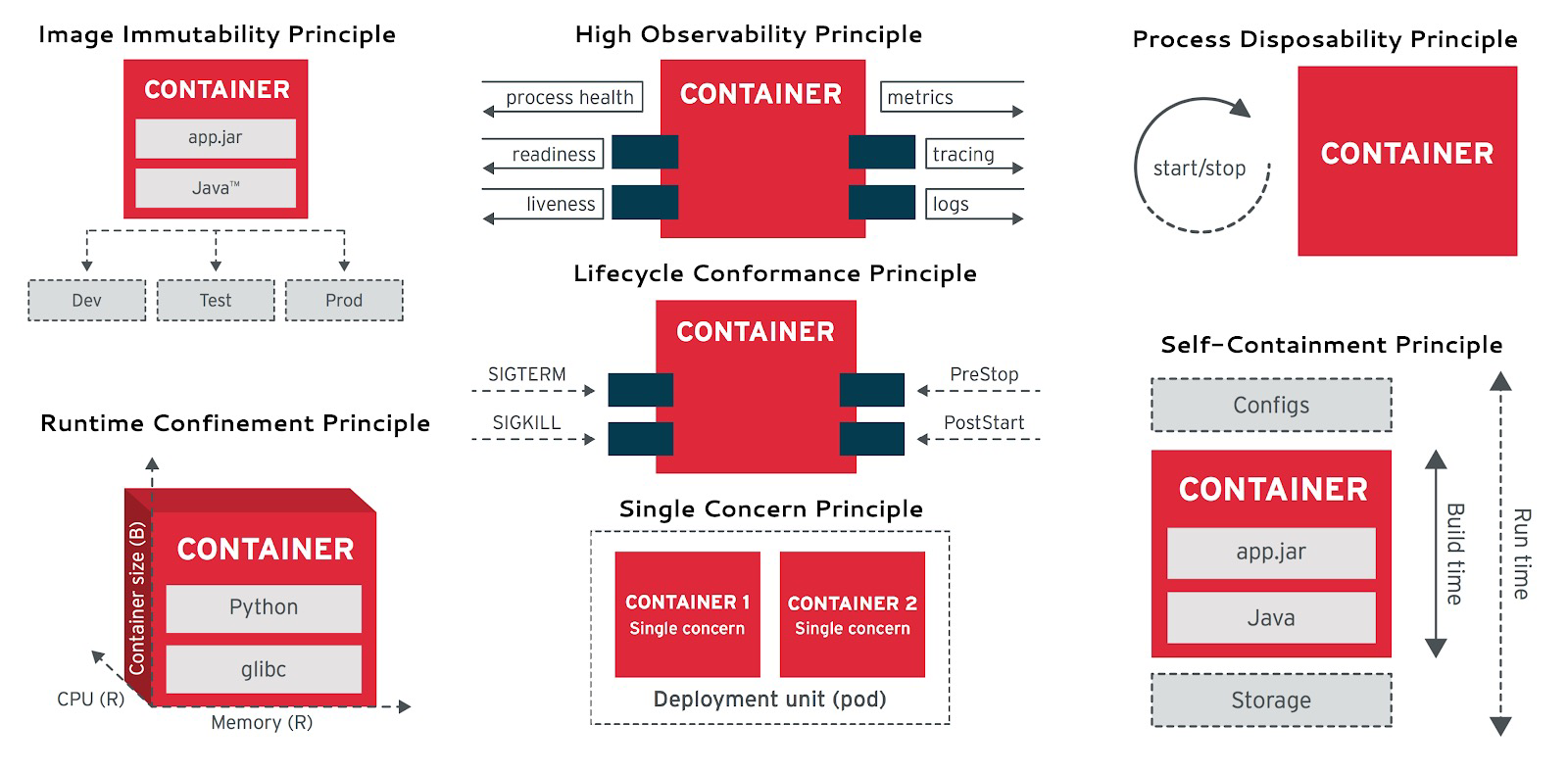

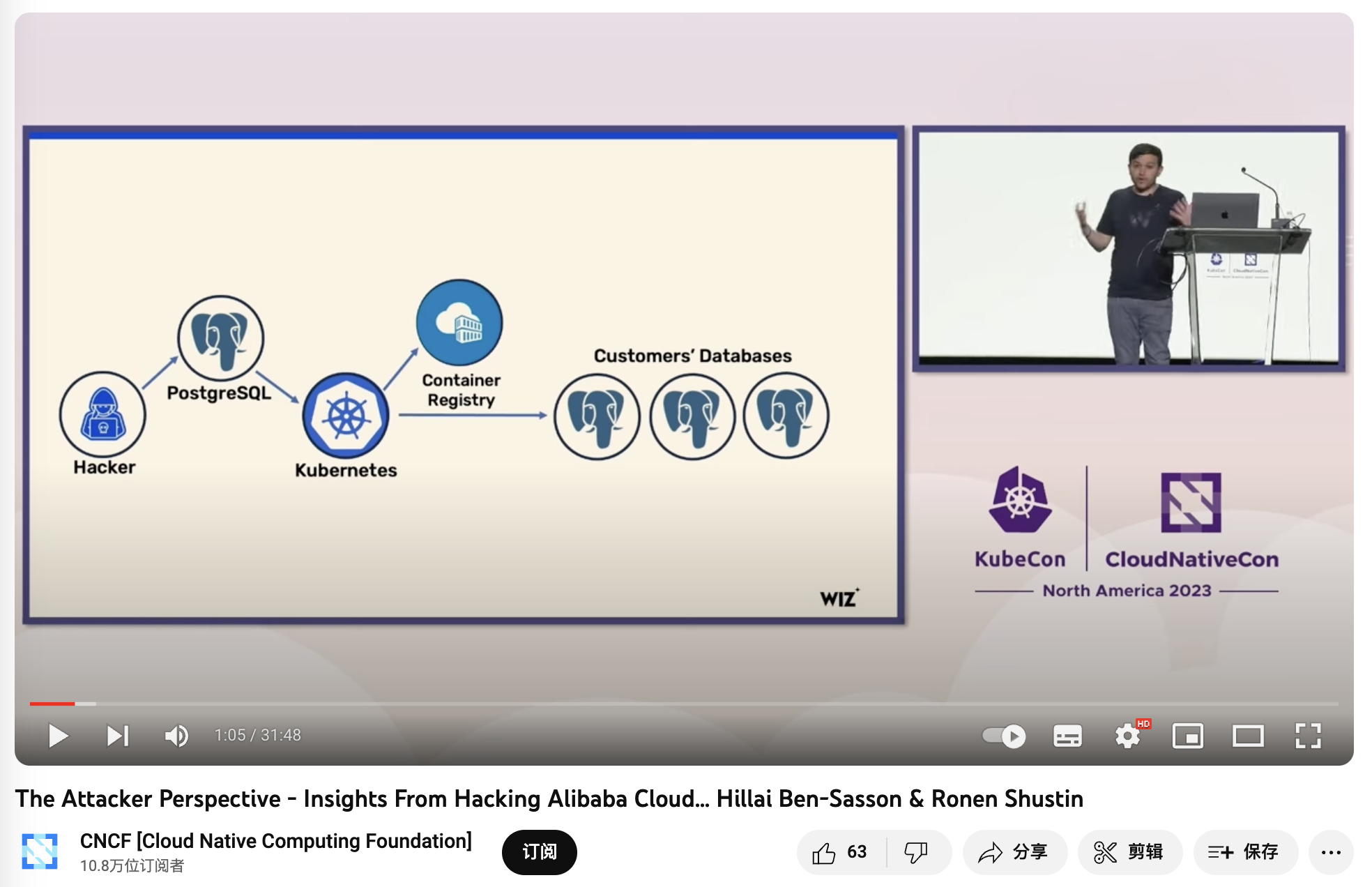

- 数据库应该放入K8S里吗?

- 专用向量数据库凉了吗?

- 数据库真被卡脖子了吗?

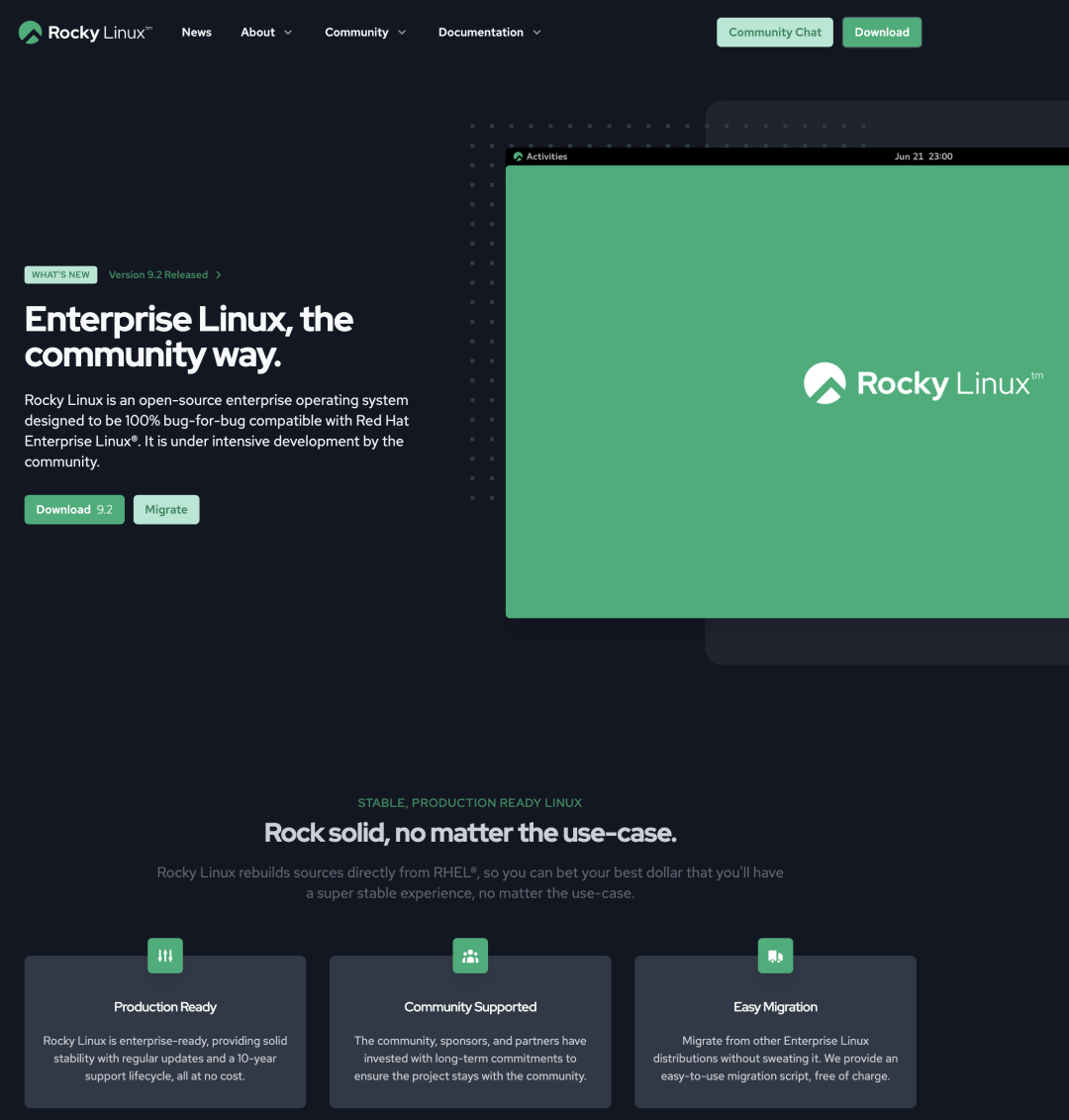

- EL系操作系统发行版哪家强?

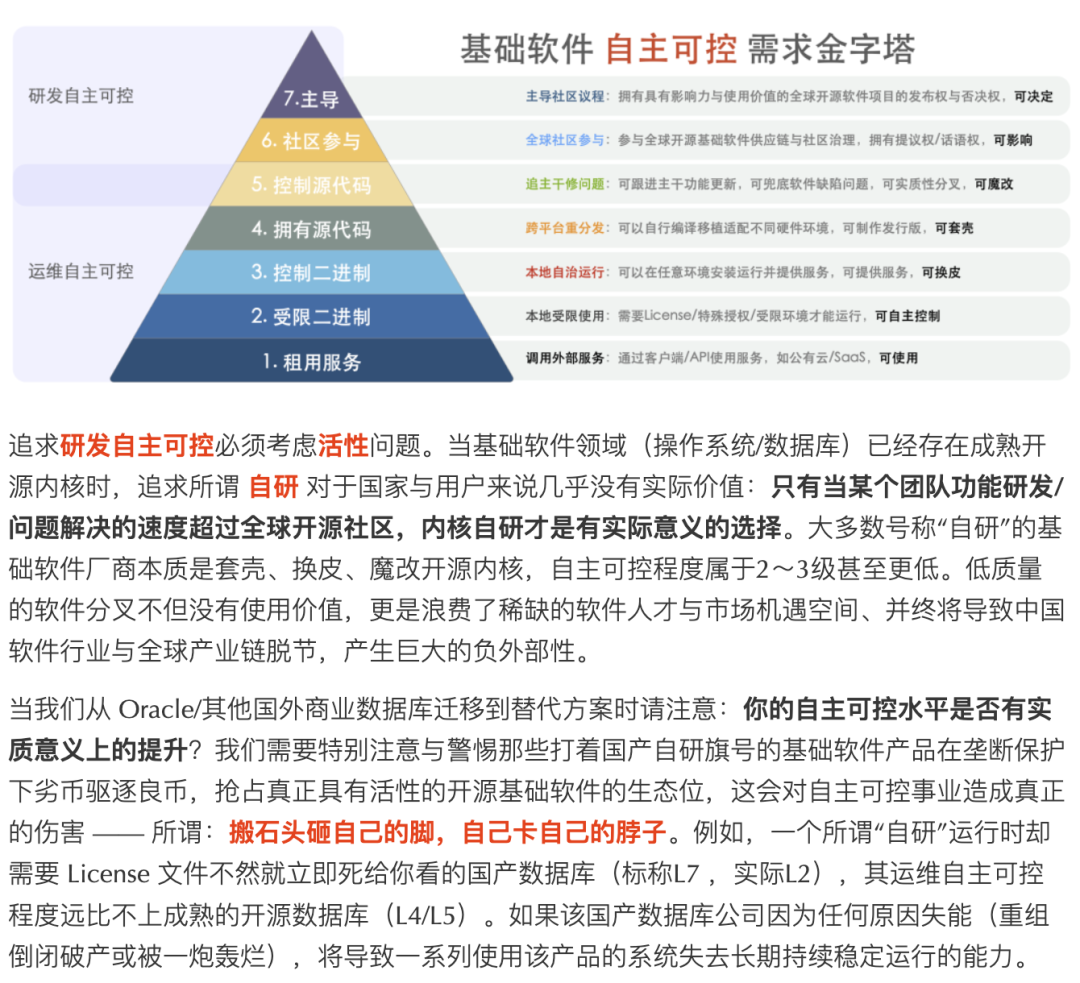

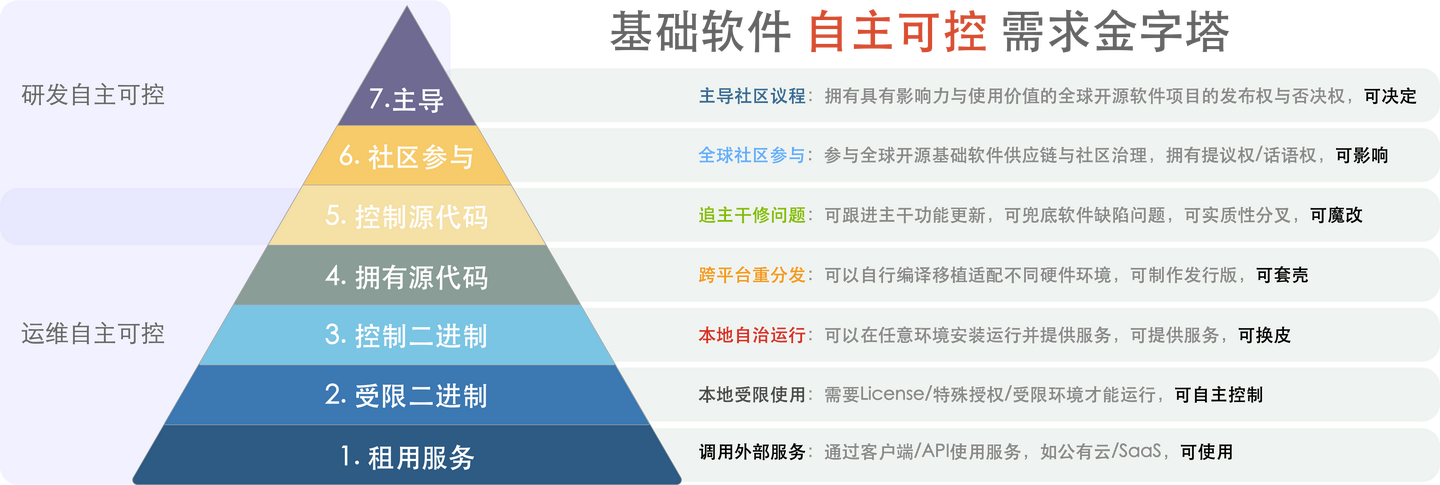

- 基础软件需要什么样的自主可控?

- 正本清源:技术反思录

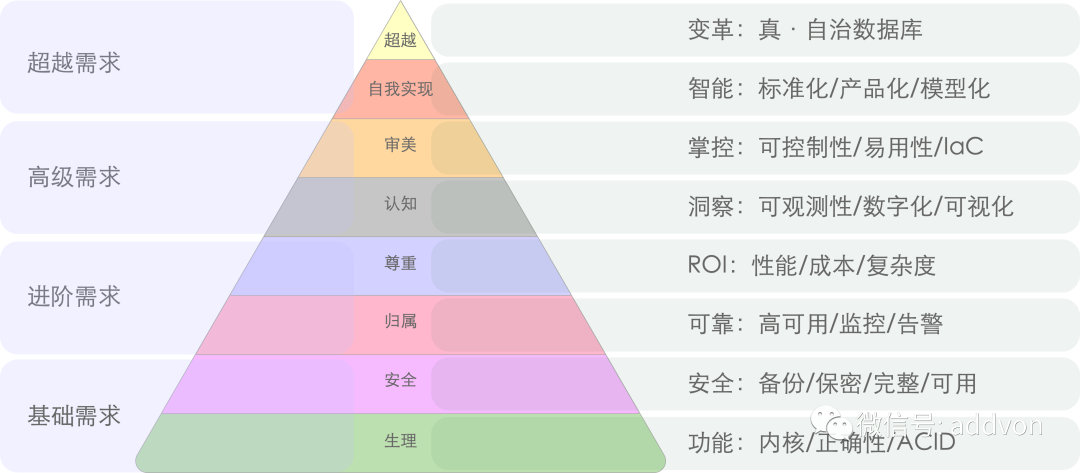

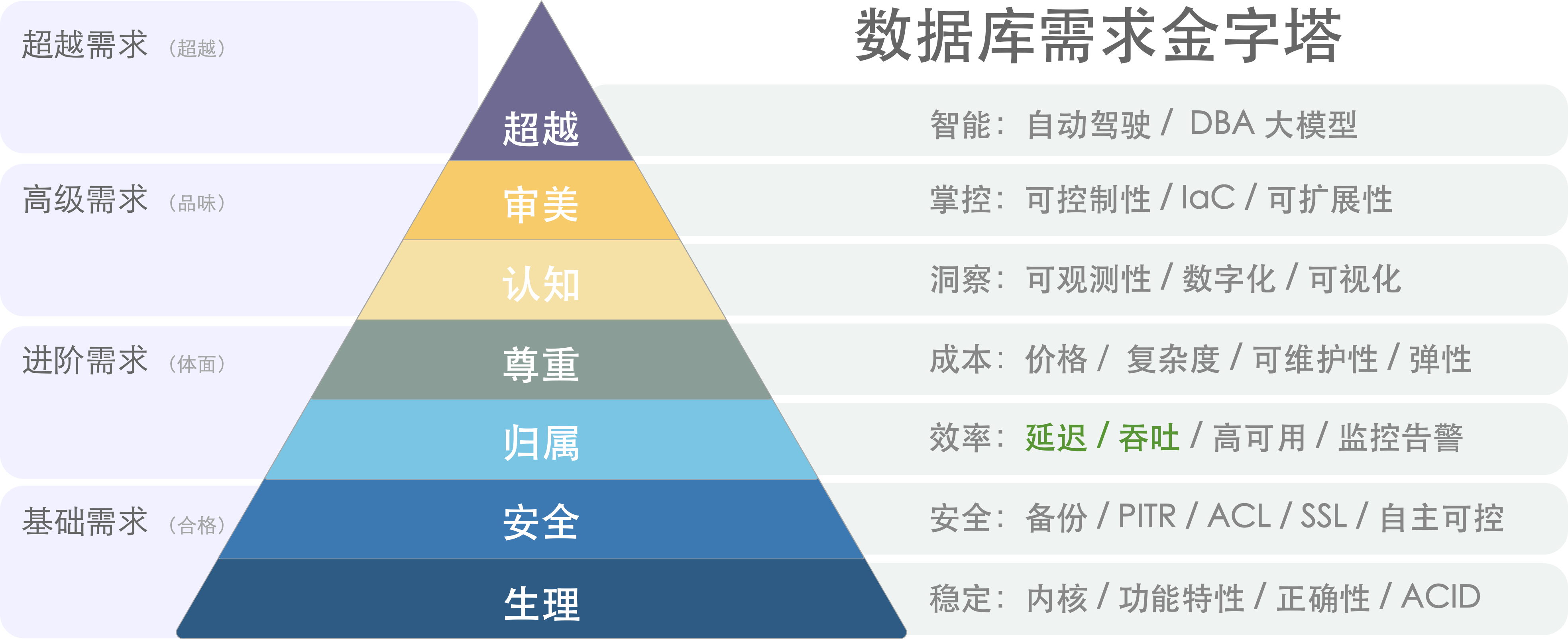

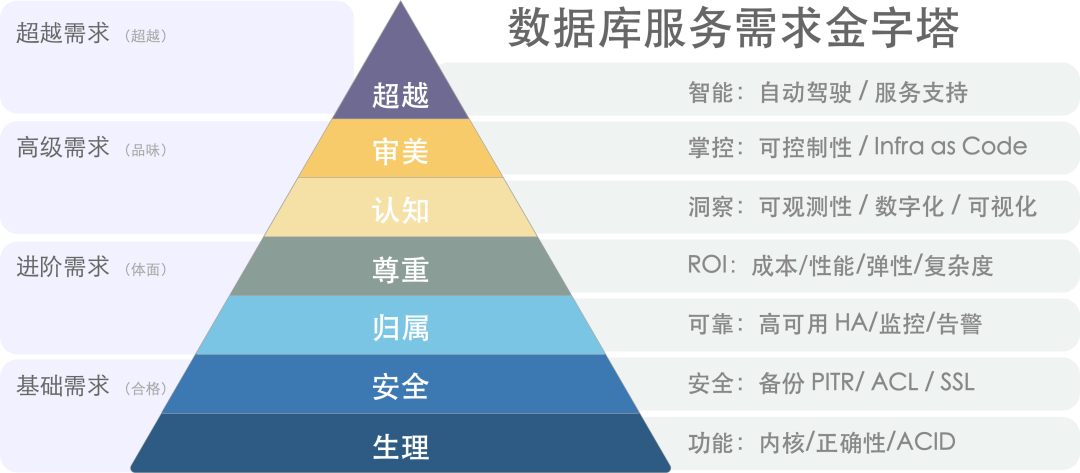

- 数据库需求层次金字塔

- 分布式数据库是不是伪需求?

- 微服务是不是个蠢主意?

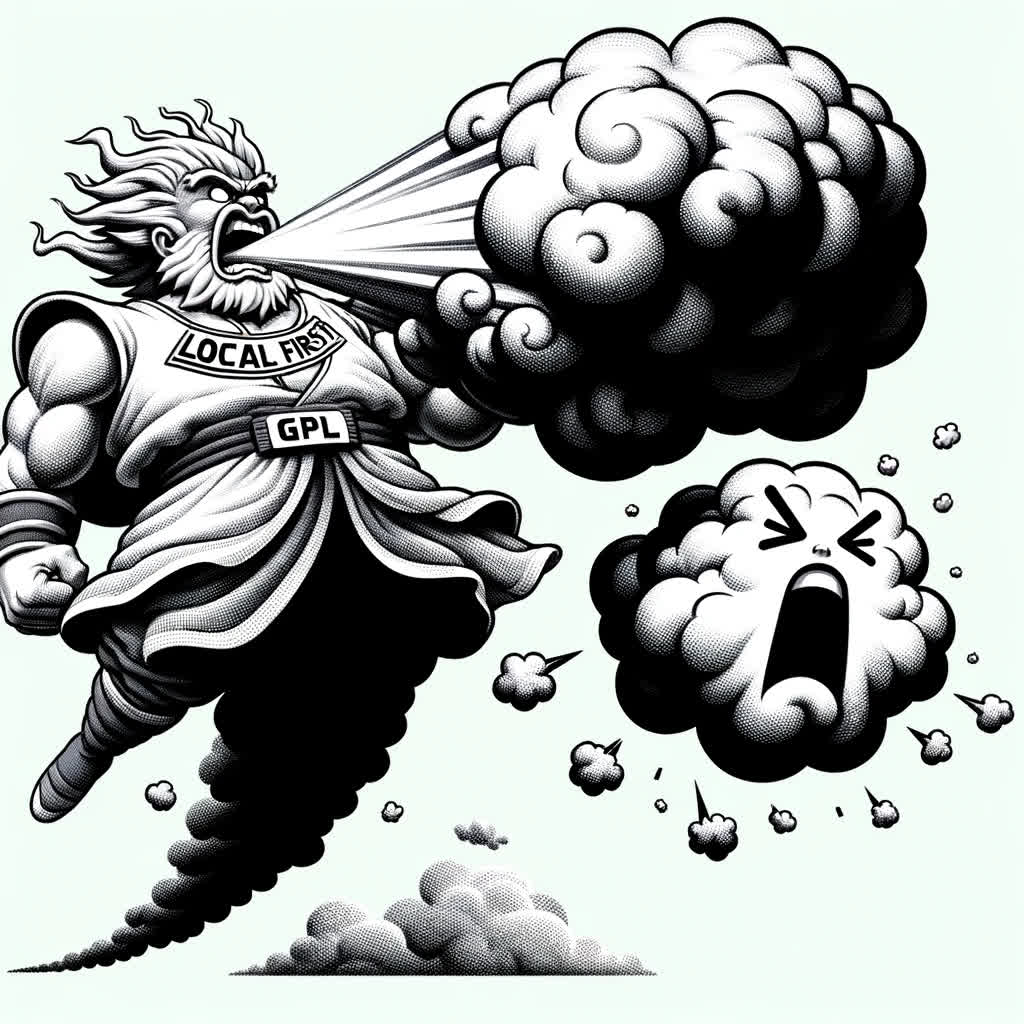

- 是时候和GPL说再见了

- 容器化数据库是个好主意吗?

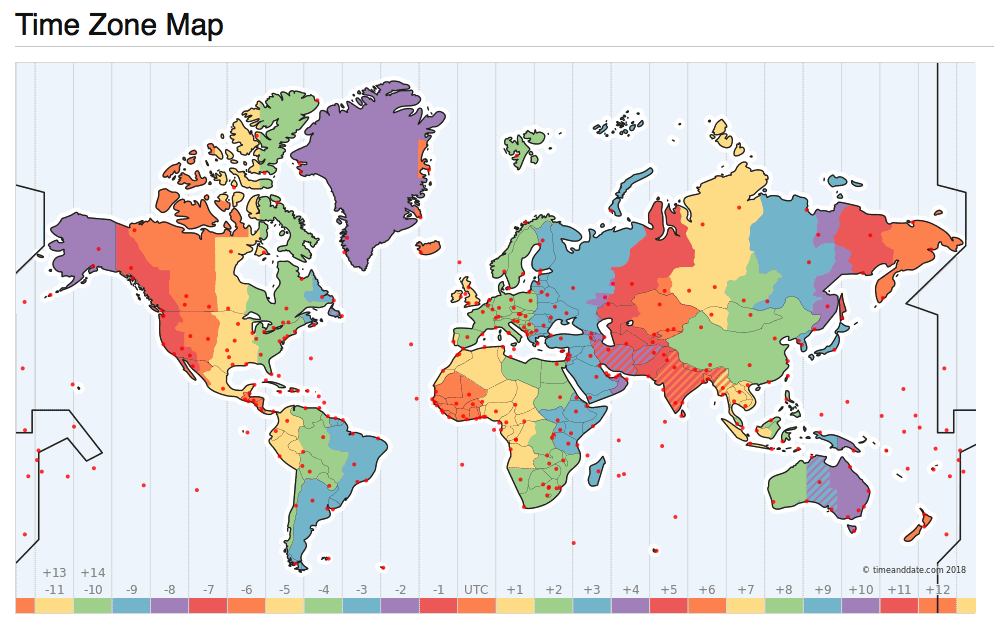

- 理解时间:闰年闰秒,时间与时区

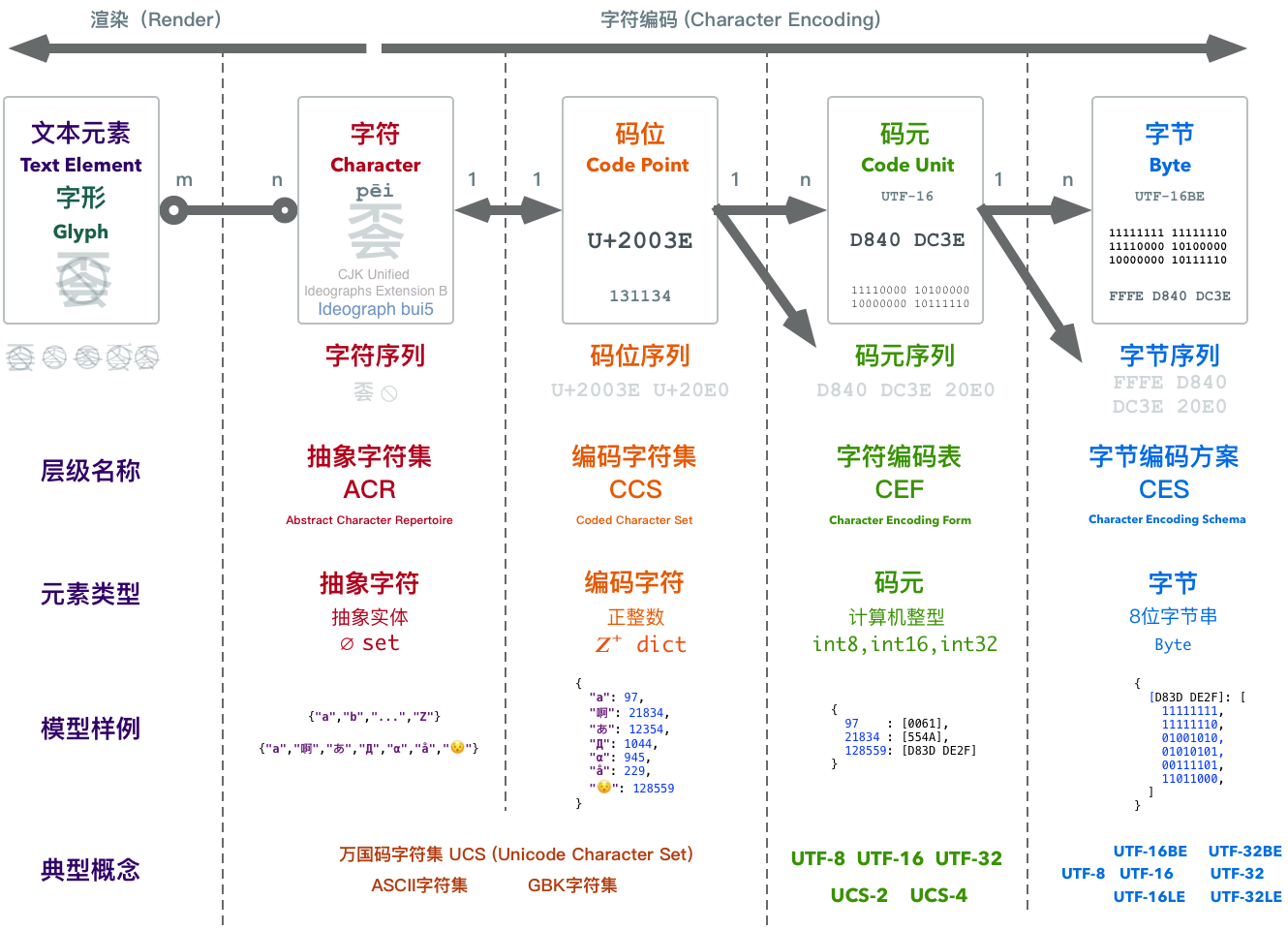

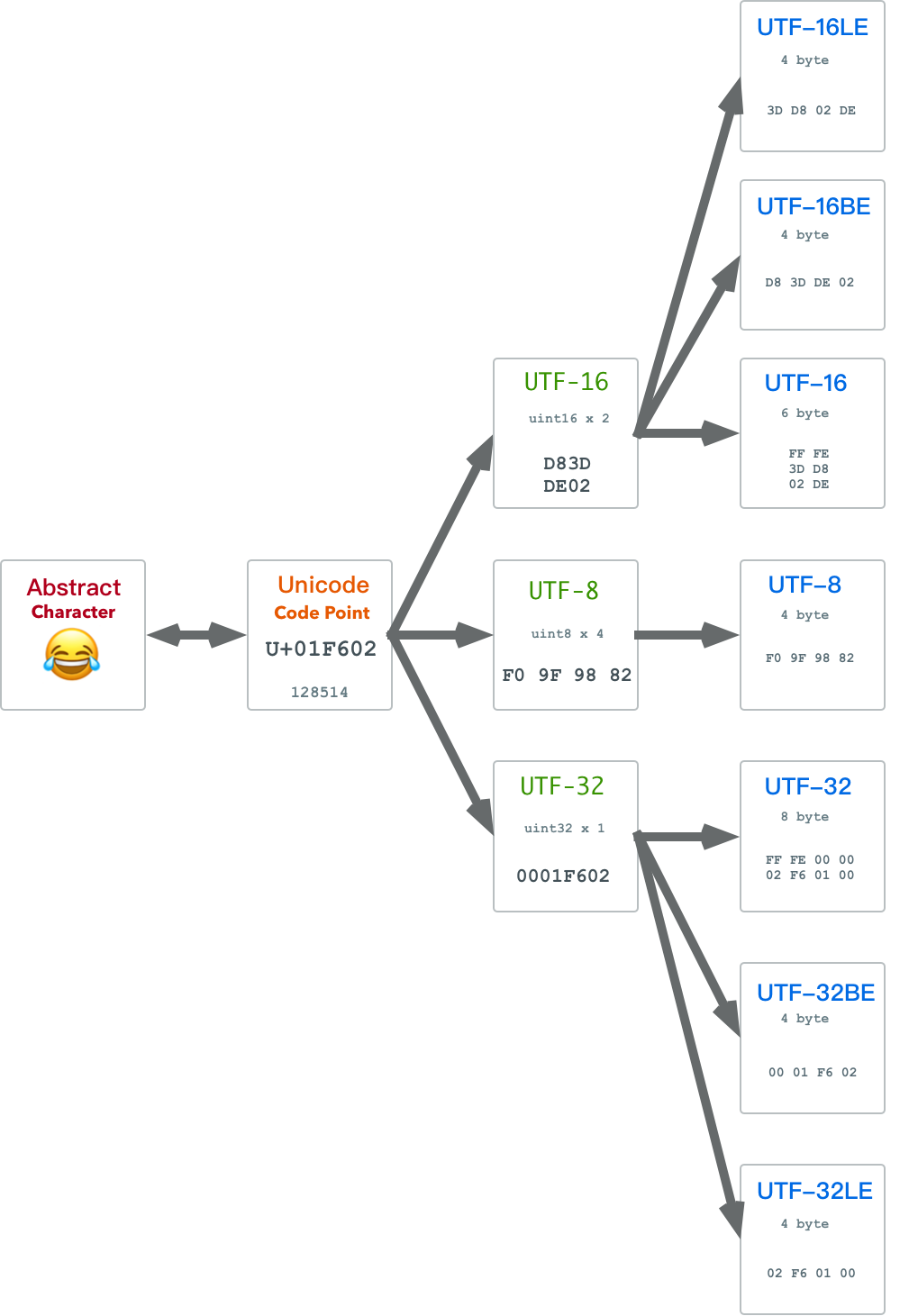

- 理解字符编码原理

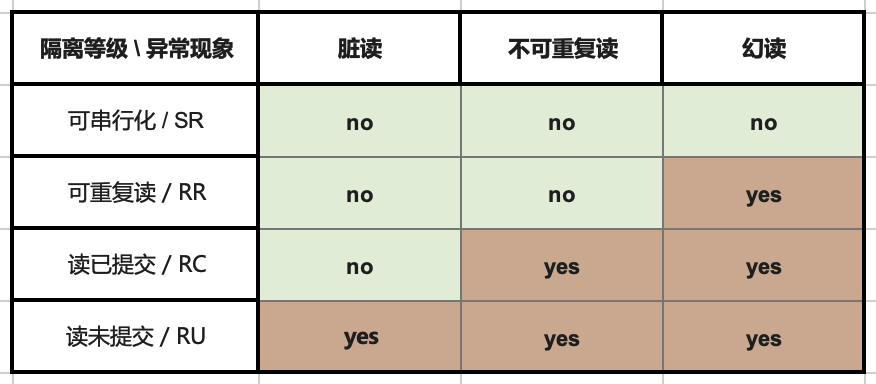

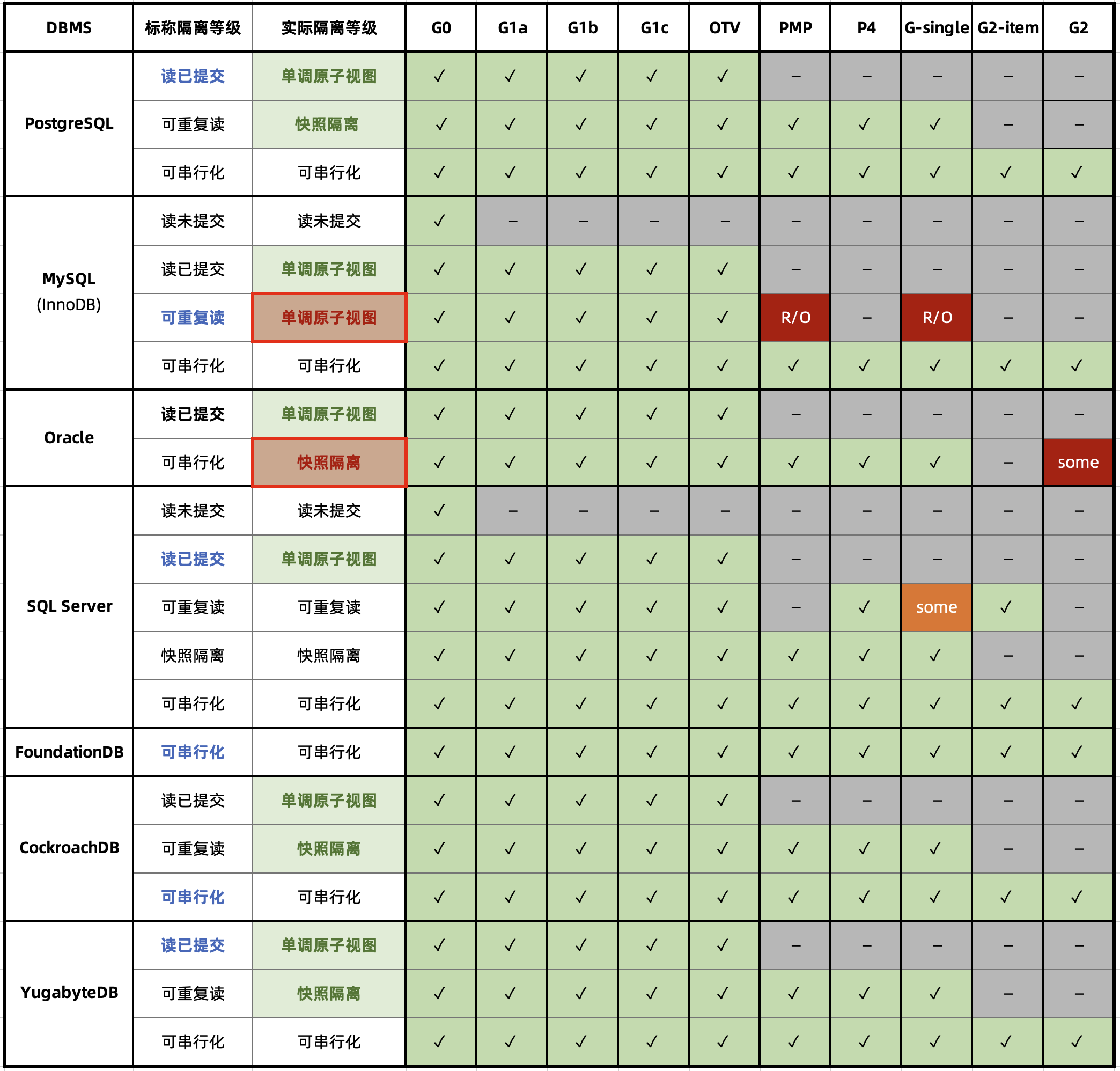

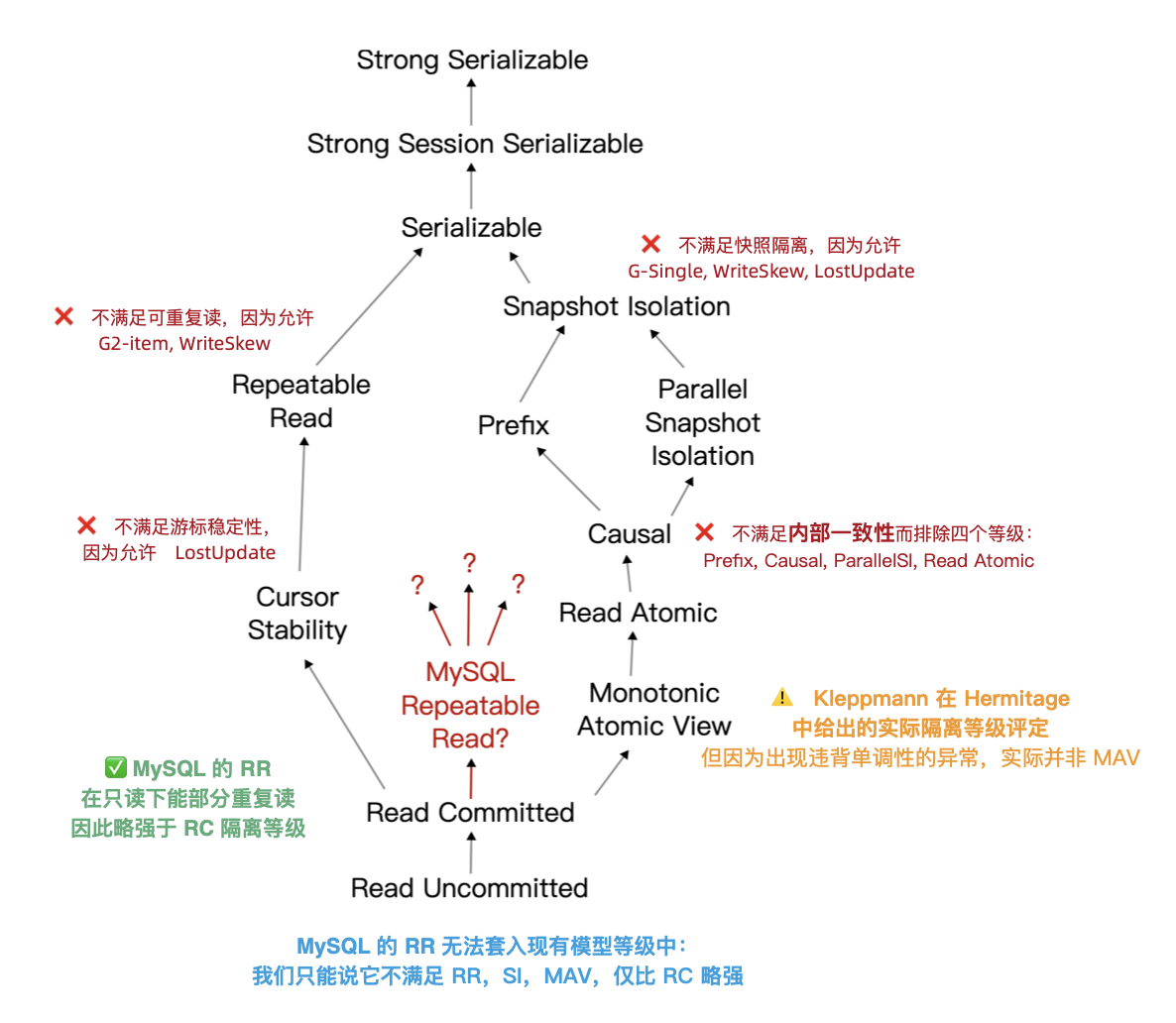

- 并发异常那些事

- 区块链与分布式数据库

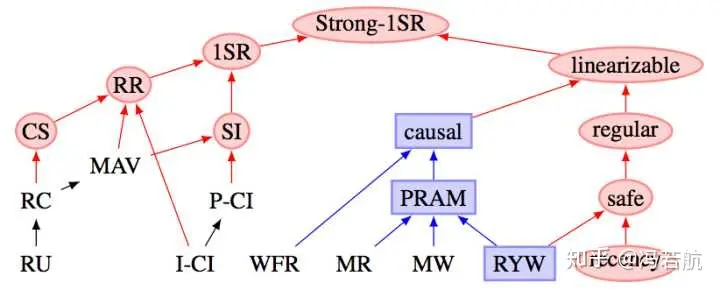

- 一致性:过载的术语

- 为什么要学习数据库原理

数据库老司机:文章导航

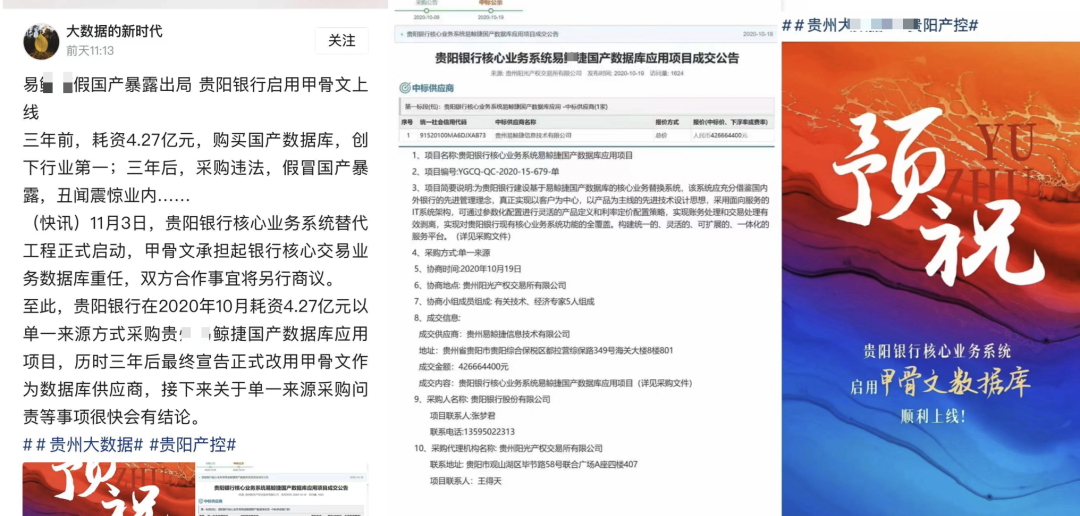

国产信创篇

- 2024-11-18 这么吹国产数据库,听的尴尬癌都要犯了

- 2024-10-25 开源皇帝Linus清洗整风

- 2024-10-01 第二批数据库国测名单:国产化来了怎么办?

- 2024-07-15 机场出租车恶性循环与国产数据库怪圈

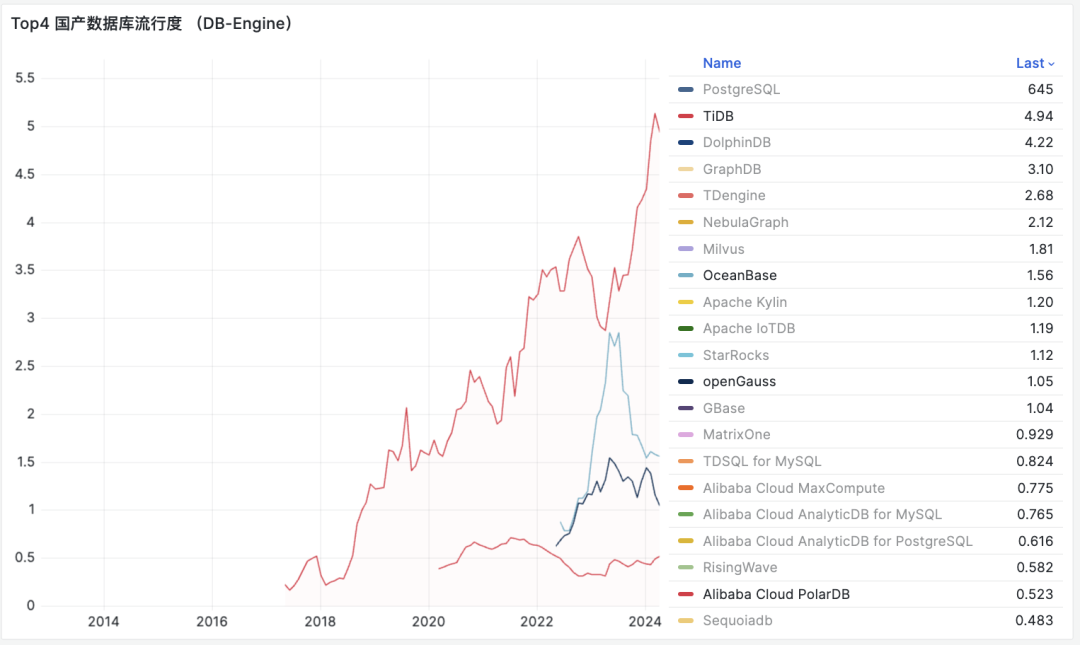

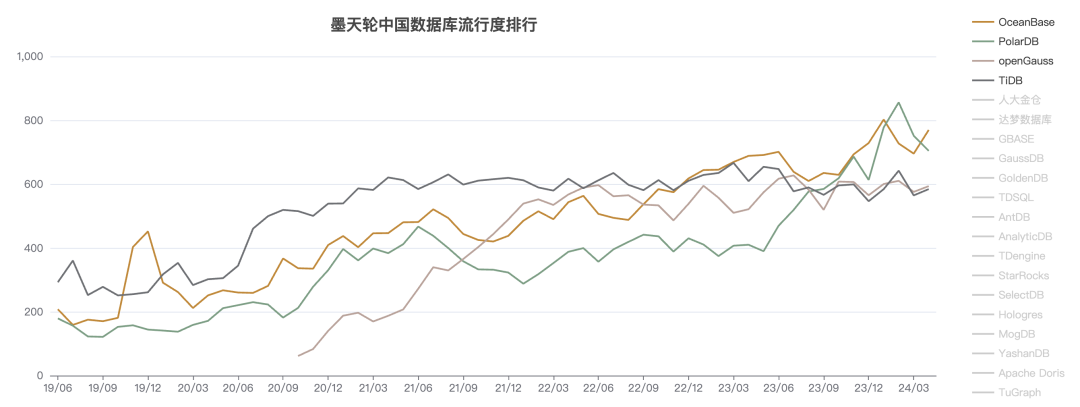

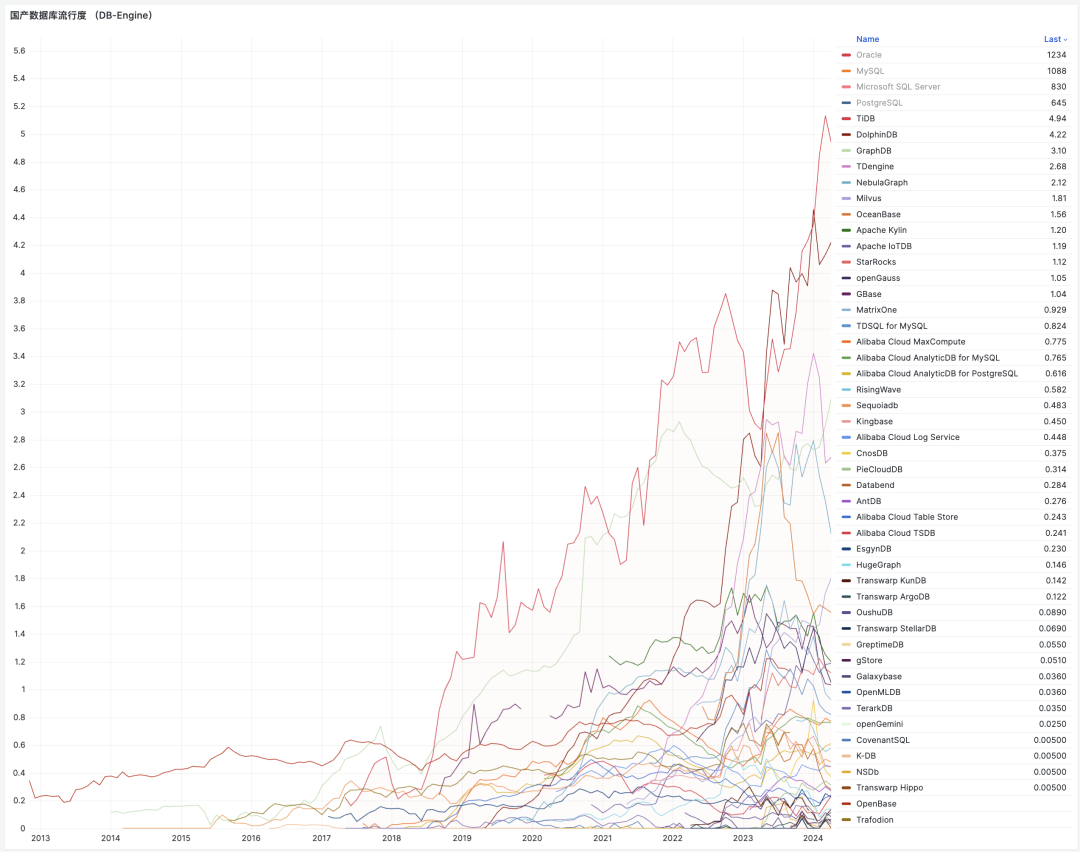

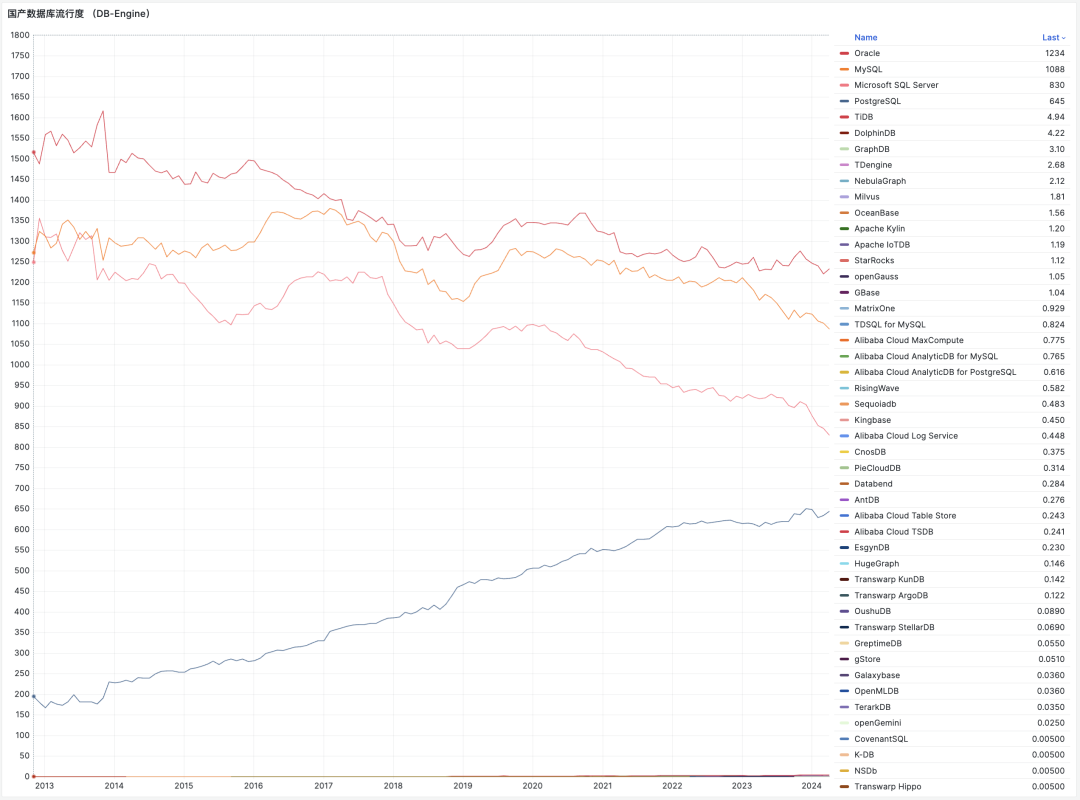

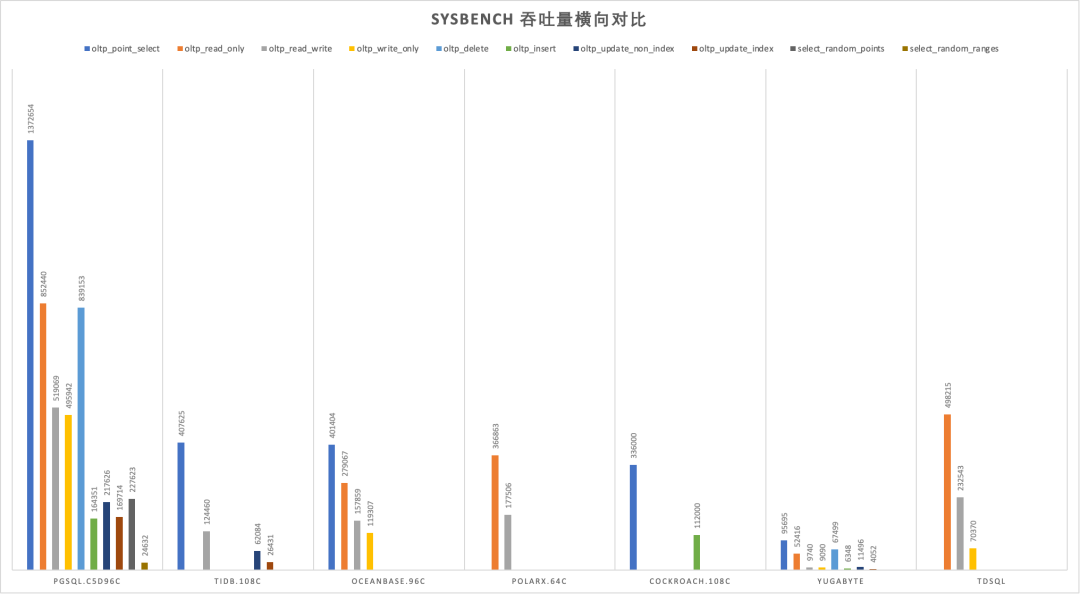

- 2024-04-25 国产数据库到底能不能打?

- 2024-01-11 国产数据库是大炼钢铁吗?

- 2024-01-08 中国对PostgreSQL的贡献约等于零吗?

- 2023-11-02 数据库真被卡脖子了吗?

- 2023-10-09 EL系操作系统发行版哪家强?

- 2023-08-31 基础软件到底需要什么样的自主可控?

行业洞察篇

- 2024-12-03 七周七数据库 @ 2025

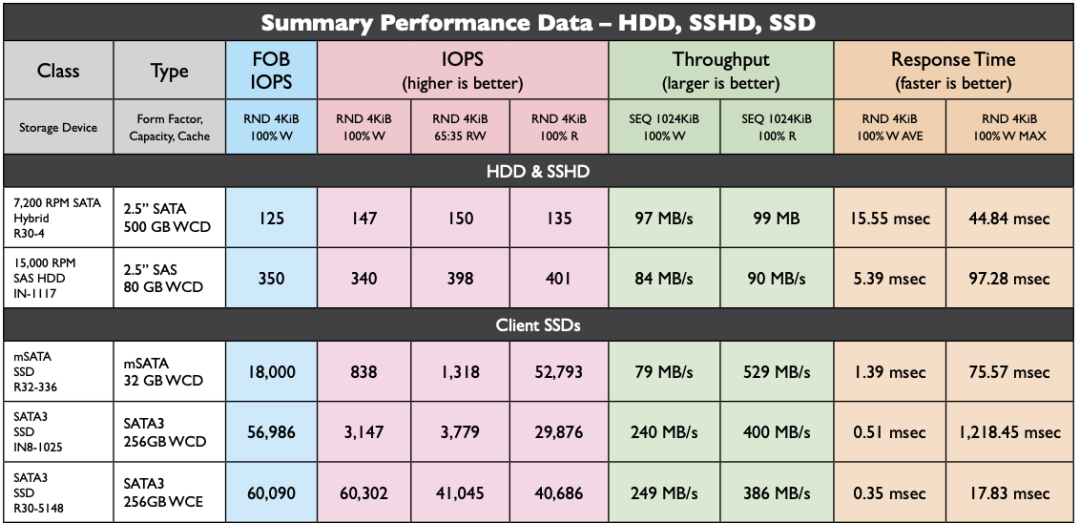

- 2024-11-21 面向未来数据库的现代硬件

- 2024-11-17 20刀好兄弟PolarDB:论数据库该卖什么价?

- 2024-08-13 谁整合好DuckDB,谁赢得OLAP数据库世界

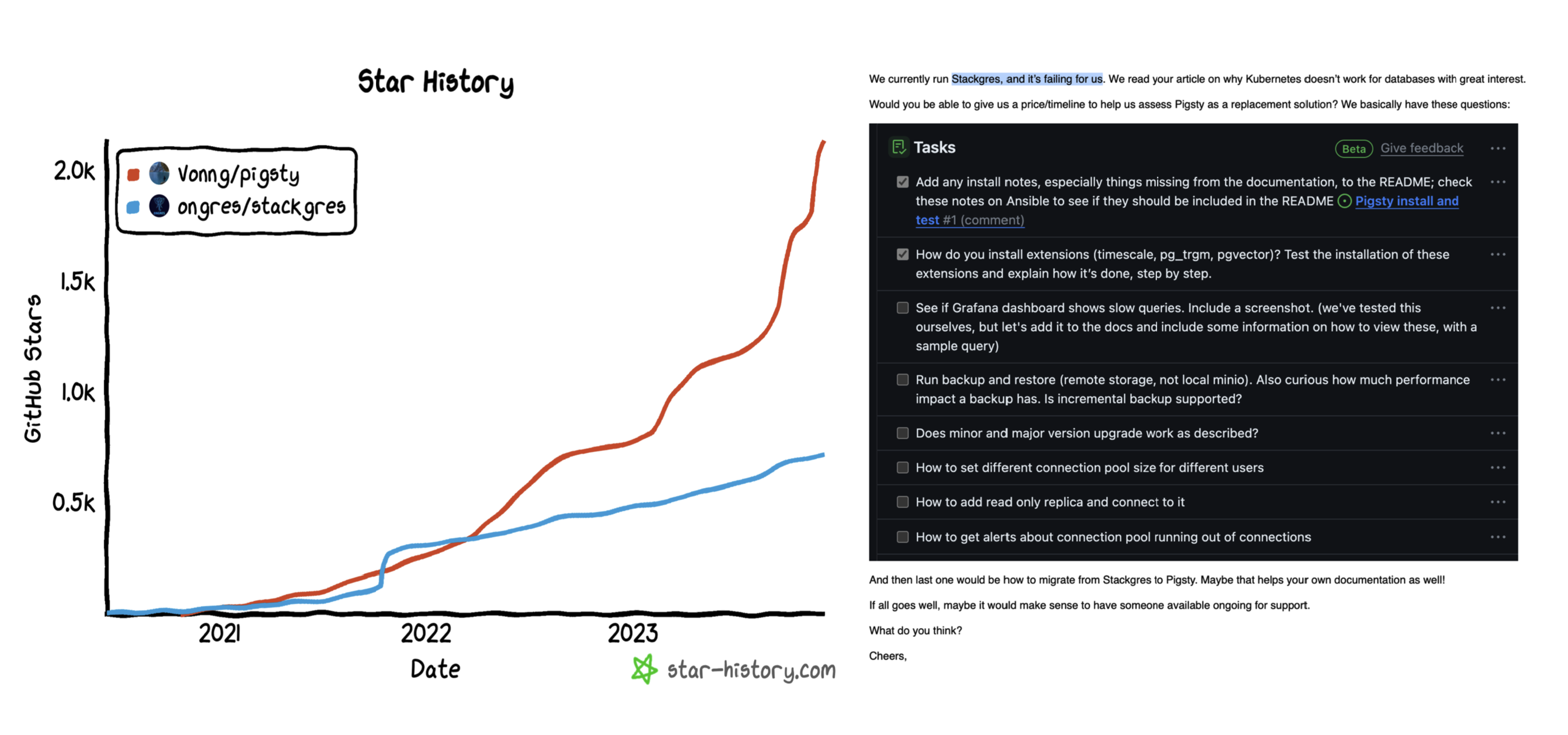

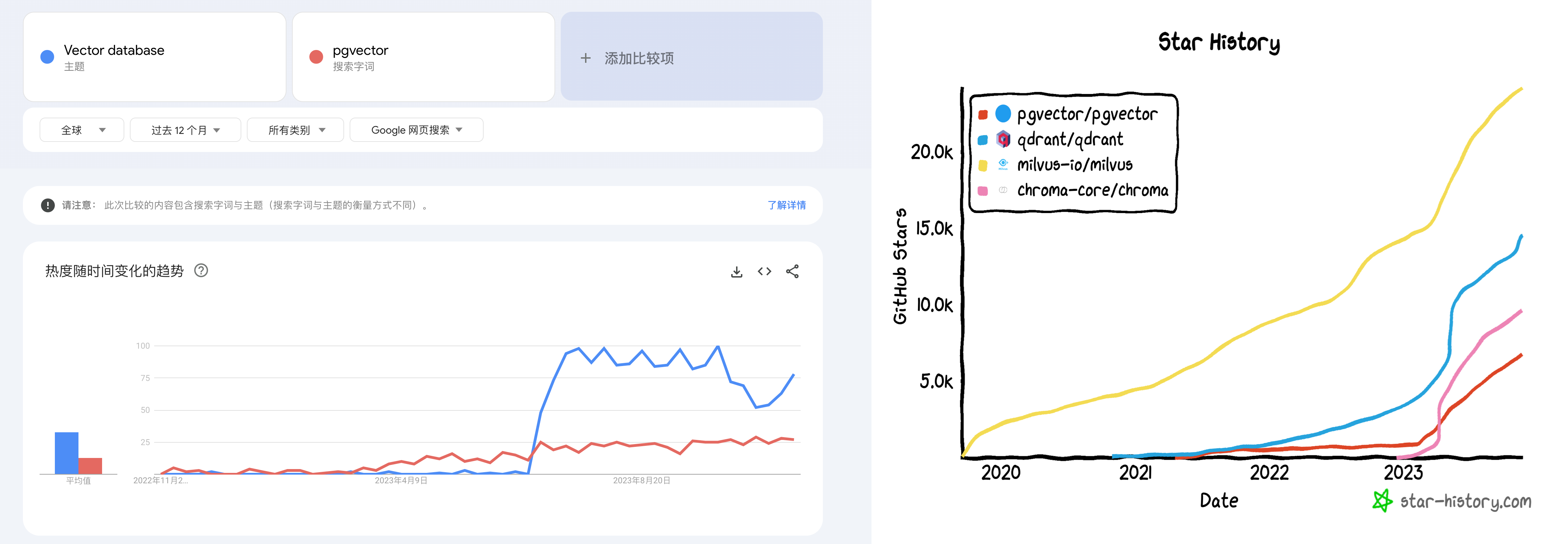

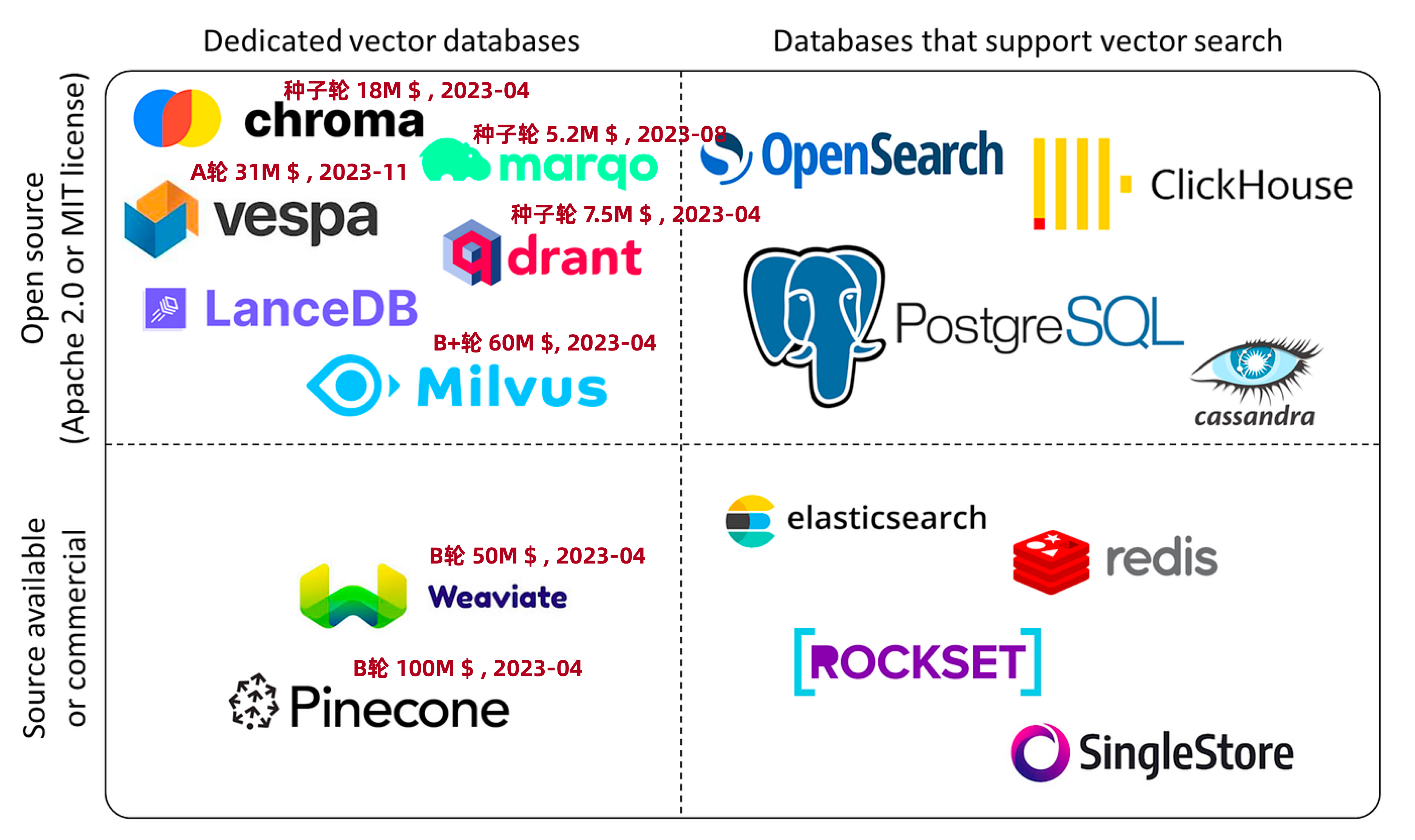

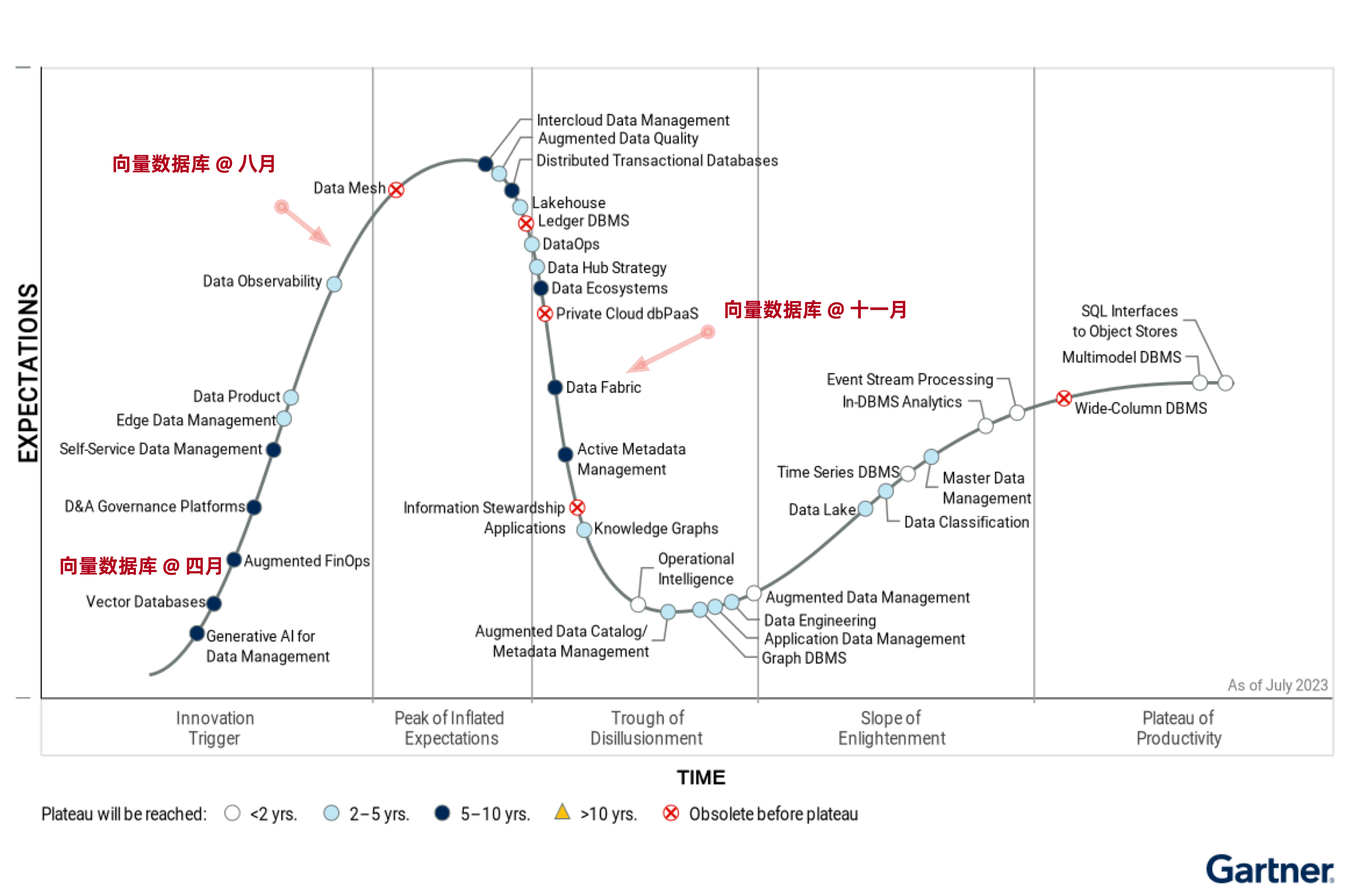

- 2023-11-22 向量数据库凉了吗?

- 2023-11-17 重新拿回计算机硬件的红利

- 2023-04-17 分布式数据库是伪需求吗?

- 2023-03-29 数据库需求层次金字塔

DBA/RDS篇

- 2024-09-07 先优化碳基BIO核,再优化硅基CPU核

- 2023-12-05 数据库应该放入K8S里吗?

- 2023-12-04 把数据库放入Docker是一个好主意吗?

- 2023-01-30 云数据库是不是智商税

- 2022-05-16 云RDS:从删库到跑路

- 2024-02-02 DBA会被云淘汰吗?

- 2023-03-01 驳《再论为什么你不应该招DBA》

- 2023-01-31 你怎么还在招聘DBA? 马工

- 2022-05-10 DBA还是一份好工作吗?

PG生态篇

- 2025-01-01 Andy Pavlo: 2024年度数据库回顾

- 2024-12-18 PostgreSQL 2024 社区现状调查报告

- 2024-11-30 你为什么不用连接池?

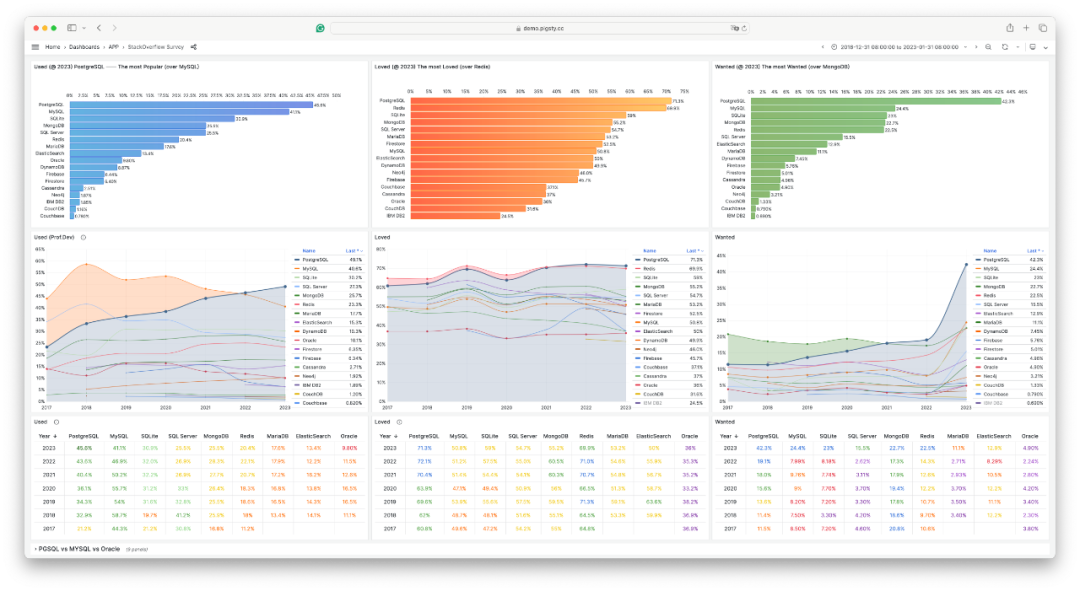

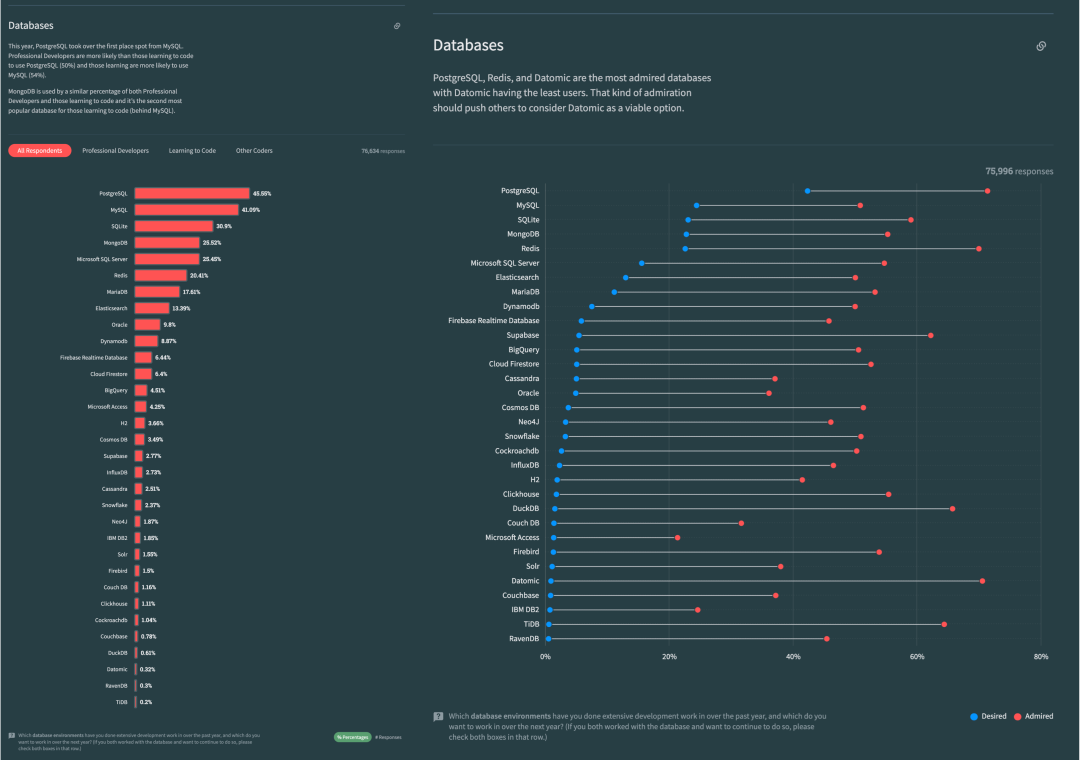

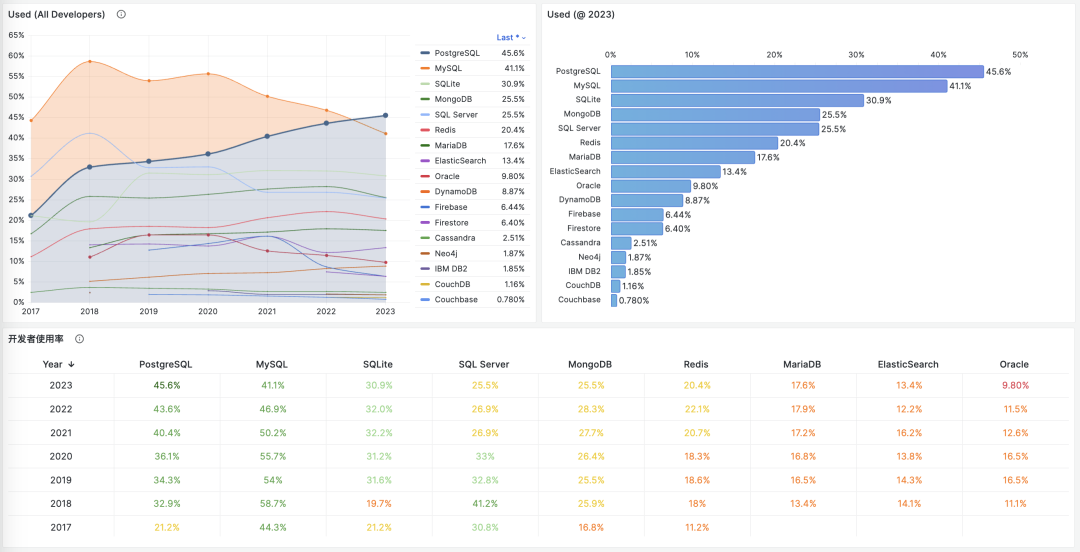

- 2024-07-25 StackOverflow 2024调研:PostgreSQL已经超神了

- 2024-03-24 PostgreSQL会修改开源许可证吗?

- 2024-05-16 为什么PostgreSQL是未来数据的基石?

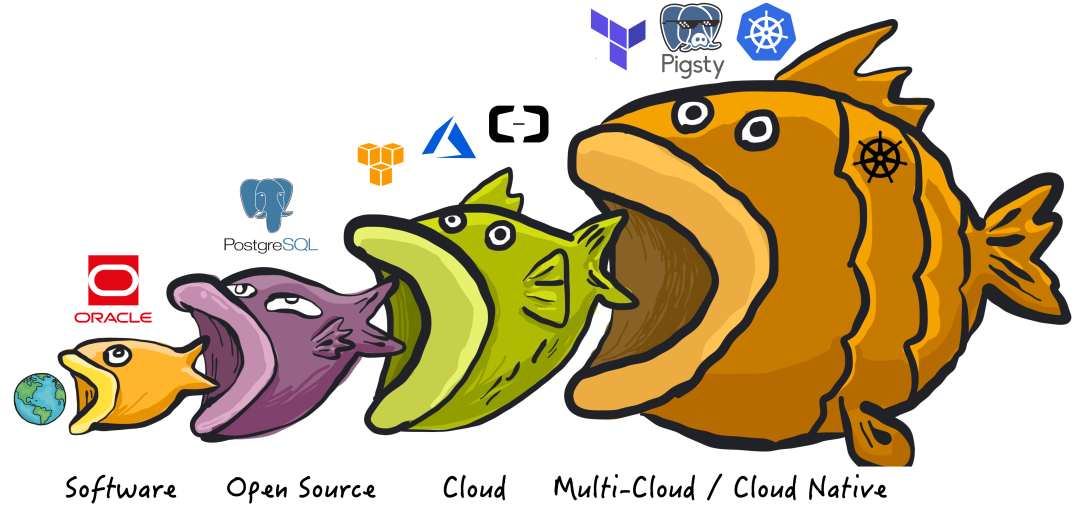

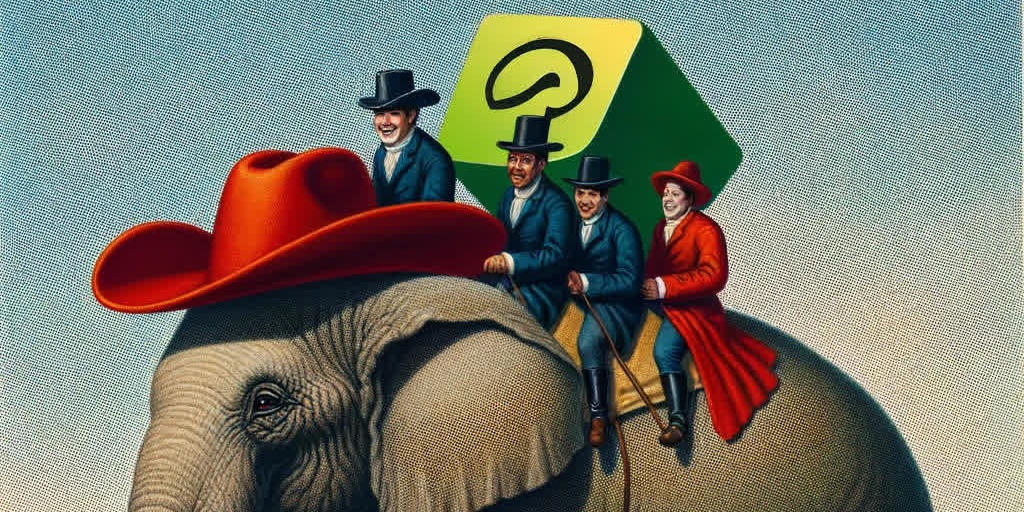

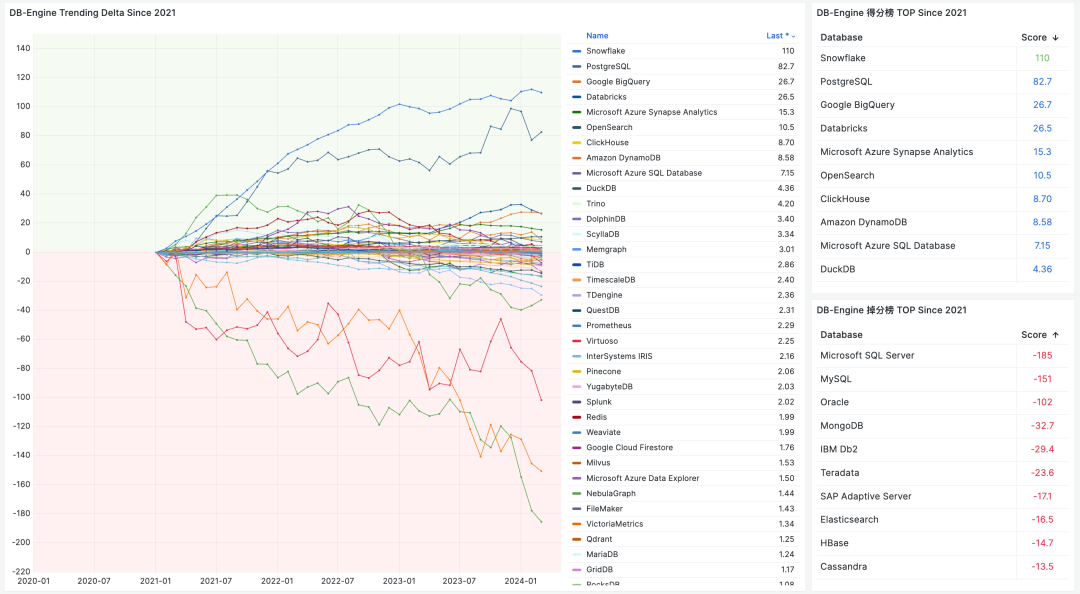

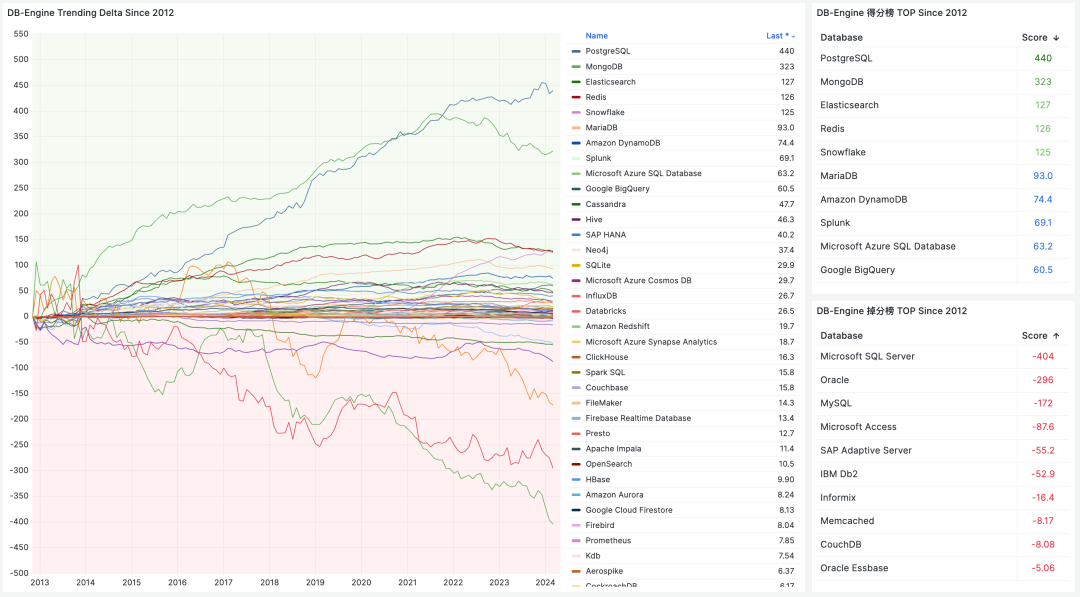

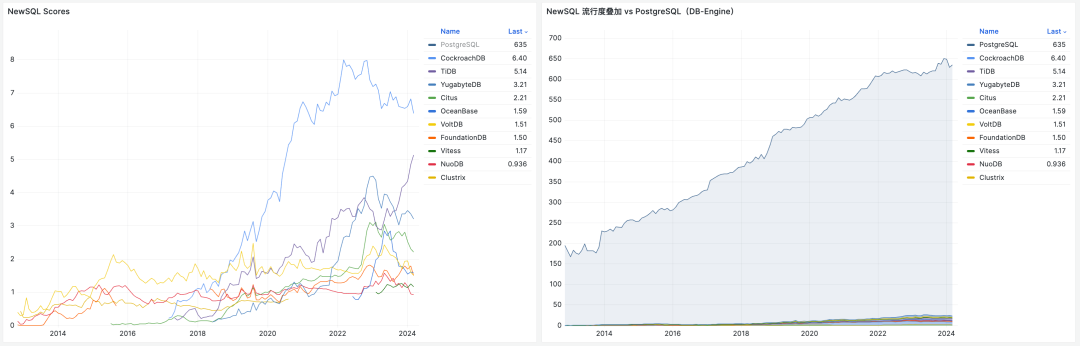

- 2024-03-16 PostgreSQL is eating the database world

- 2024-03-04 PostgreSQL正在吞噬数据库世界

- 2024-02-19 技术极简主义:一切皆用Postgres

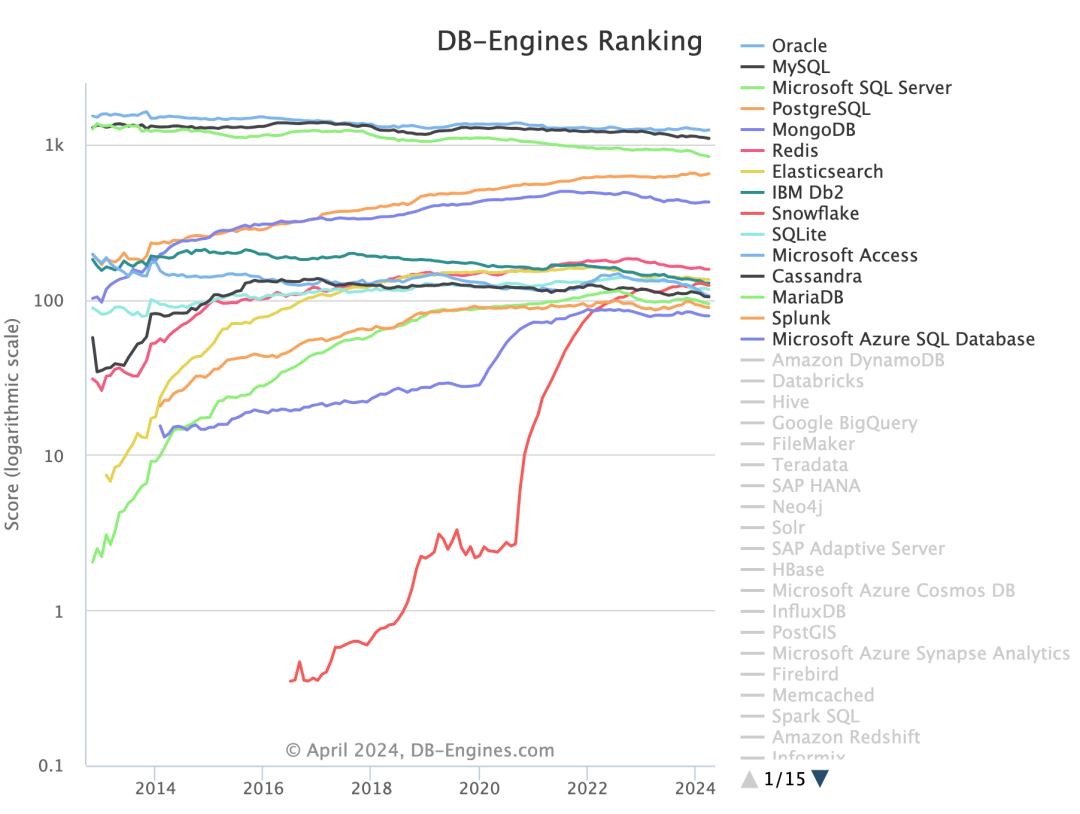

- 2024-01-03 2023年度数据库:PostgreSQL (DB-Engine)

- 2022-08-22 PostgreSQL 到底有多强?

- 2022-07-12 为什么PostgreSQL是最成功的数据库?

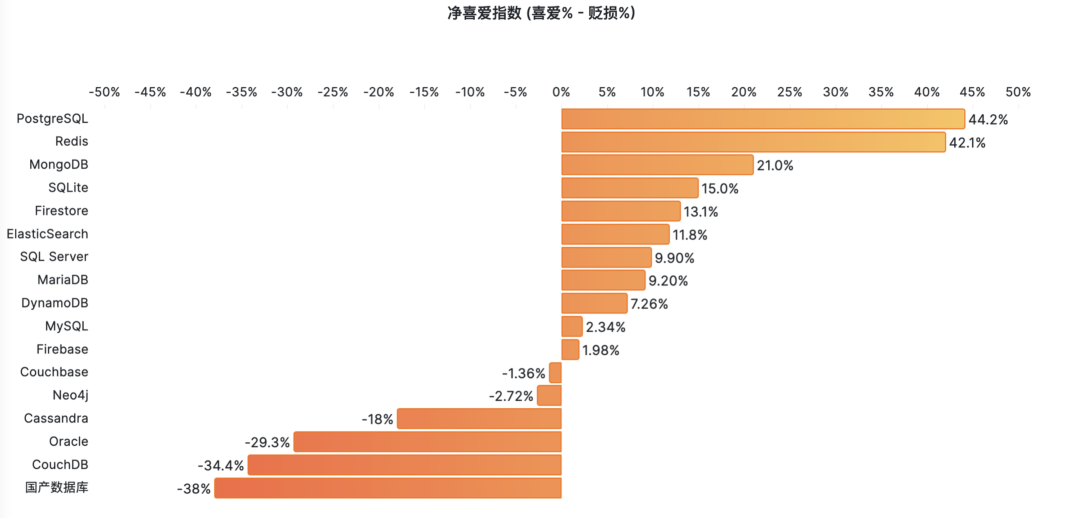

- 2022-06-24 StackOverflow 2022数据库年度调查

- 2021-05-08 为什么说PostgreSQL前途无量?

PG发布篇

- 2024-11-15 不要更新!发布当日叫停:PG也躲不过大翻车

- 2024-11-14 PostgreSQL 12 过保,PG 17 上位

- 2024-11-02 PostgreSQL神功大成!最全扩展仓库

- 2024-09-27 PostgreSQL 17 发布:摊牌了,我不装了!

- 2024-09-05 PostgreSQL 17 RC1 发布!与近期PG新闻

- 2024-08-09 PostgreSQL小版本更新,17beta3,12将EOL

- 2024-05-24 PostgreSQL 17 Beta1 发布!牙膏管挤爆了!

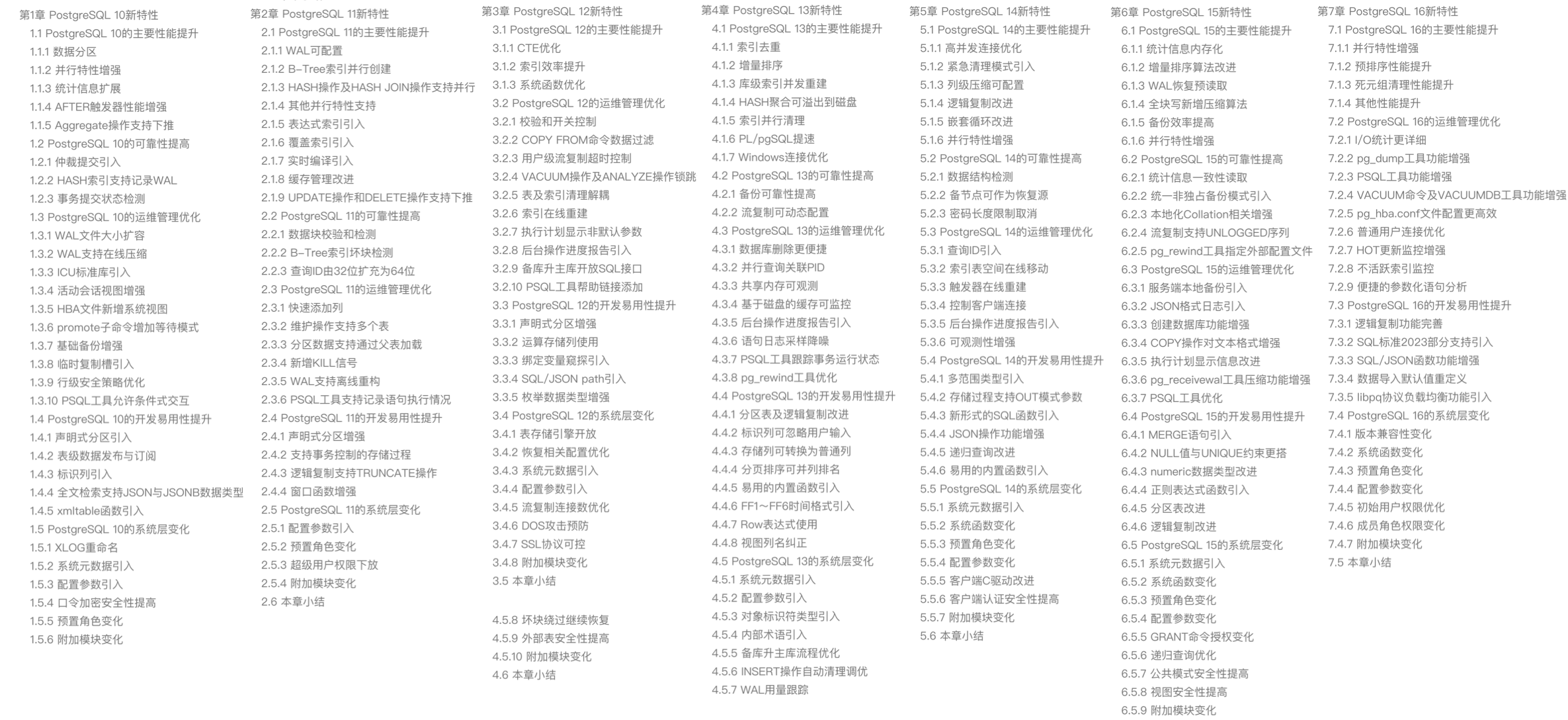

- 2024-01-14 快速掌握PostgreSQL版本新特性

- 2024-01-05 展望PostgreSQL的2024 (Jonathan Katz)

创业融资篇

- 2024-09-26 PG系创业公司Supabase:$80M C轮融资

- 2024-07-31 ClickHouse收购PeerDB:这浓眉大眼的也要来搞 PG 了?

- 2024-02-18 PG生态新玩家ParadeDB

- 2023-10-08 FerretDB:假扮成MongoDB的PostgreSQL?

MySQL杀手篇

- 2024-11-05 PZ:MySQL还有机会赶上PostgreSQL的势头吗?

- 2024-07-12 MySQL新版恶性Bug,表太多就崩给你看!

- 2024-07-09 MySQL安魂九霄,PostgreSQL驶向云外

- 2024-06-26 用PG的开发者,年薪比MySQL多赚四成?

- 2024-06-20 Oracle最终还是杀死了MySQL!

- 2024-06-19 MySQL性能越来越差,Sakila将何去何从?

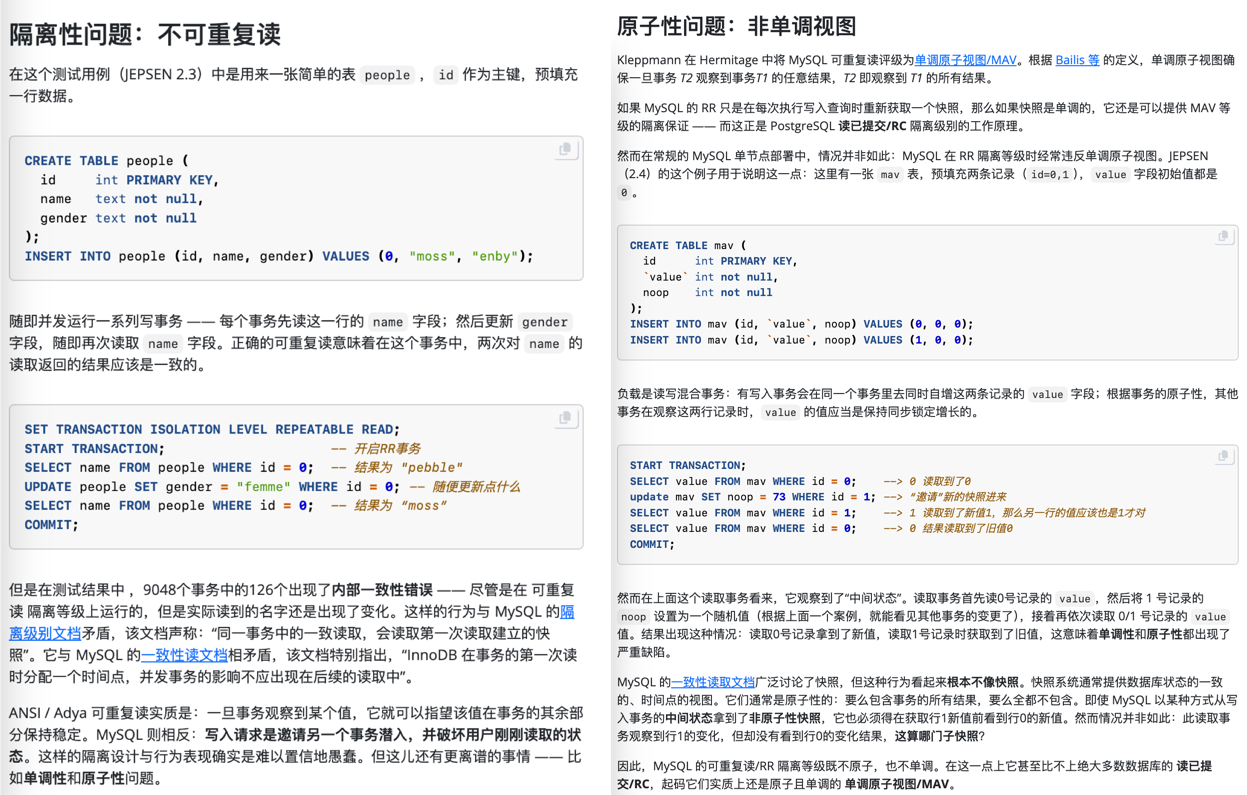

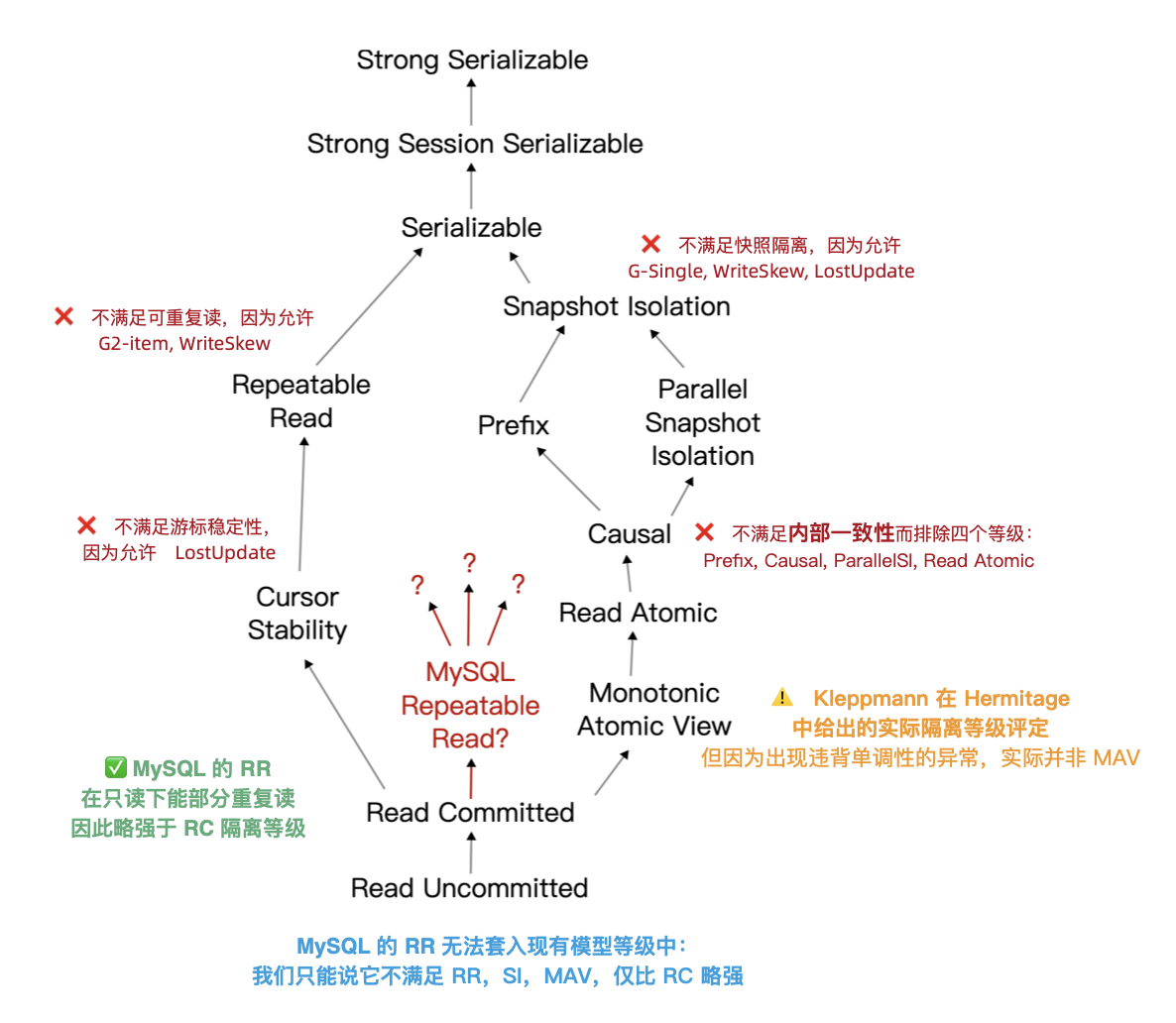

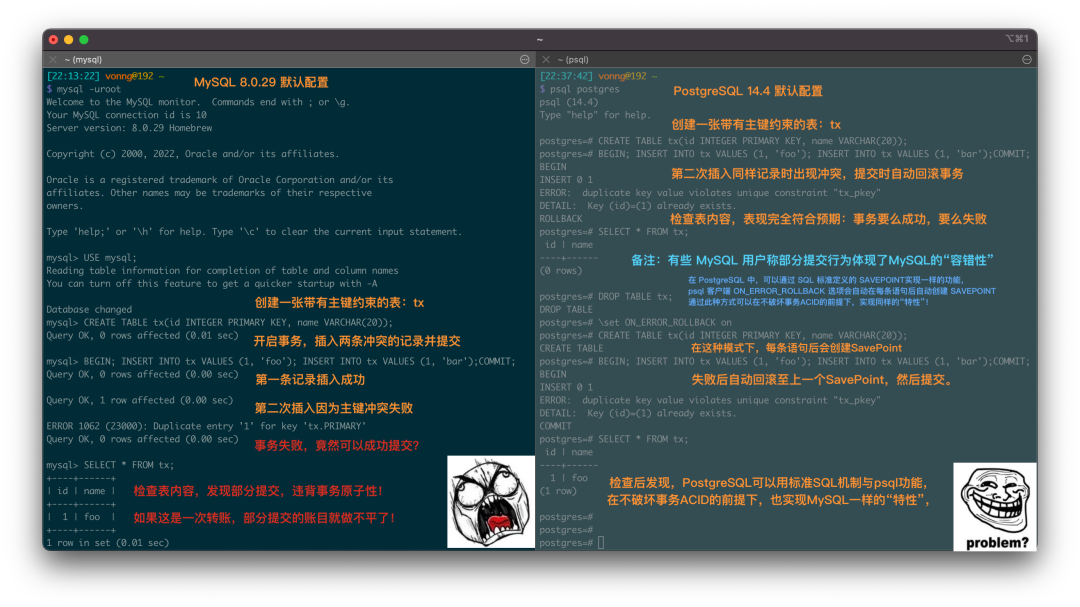

- 2023-12-30 MySQL的正确性为何如此拉垮?

- 2023-08-11 如何看待 MySQL vs PGSQL 直播闹剧

- 2023-08-09 驳《MySQL:这个星球最成功的数据库》

其他DB篇

- 2024-09-04 MongoDB没有未来:“好营销”救不了烂芒果

- 2024-09-03 《黑历史:Mongo》:现由PostgreSQL驱动

- 2024-09-02 PostgreSQL可以替换微软SQL Server吗?

- 2024-08-30 ElasticSearch又重新开源了???

- 2024-03-26 Redis不开源是“开源”之耻,更是公有云之耻

- 2023-10-08 FerretDB:假扮成MongoDB的PostgreSQL?

司机本人篇

- 2024-08-22 GOTC 2024 BTW采访冯若航:Pigsty作者,简化PG管理,推动PG开源社区的中国参与

- 2023-12-31 2023总结:三十而立

- 2023-09-08 冯若航:不想当段子手的技术狂,不是一位好的开源创始人

- 2022-07-07 90后,辞职创业,说要卷死云数据库

数据库老司机专栏

- 2025-01-14 PostgreSQL荣获2024年度数据库(5冠王)

- 2025-01-11 PII数据安全合规与PG Anonymizer最佳实践

- 2025-01-07 第七届PG生态大会:一些感想

- 2025-01-01 Andy Pavlo: 2024年度数据库回顾

- 2024-12-31 Pigsty@2024:今年没啥财运,但事儿整的还不赖

- 2024-12-23 小猪骑大象:PG内核与扩展包管理神器

- 2024-12-18 PostgreSQL 2024 社区现状调查报告

- 2024-12-03 七周七数据库 @ 2025

- 2024-11-30 你为什么不用连接池?

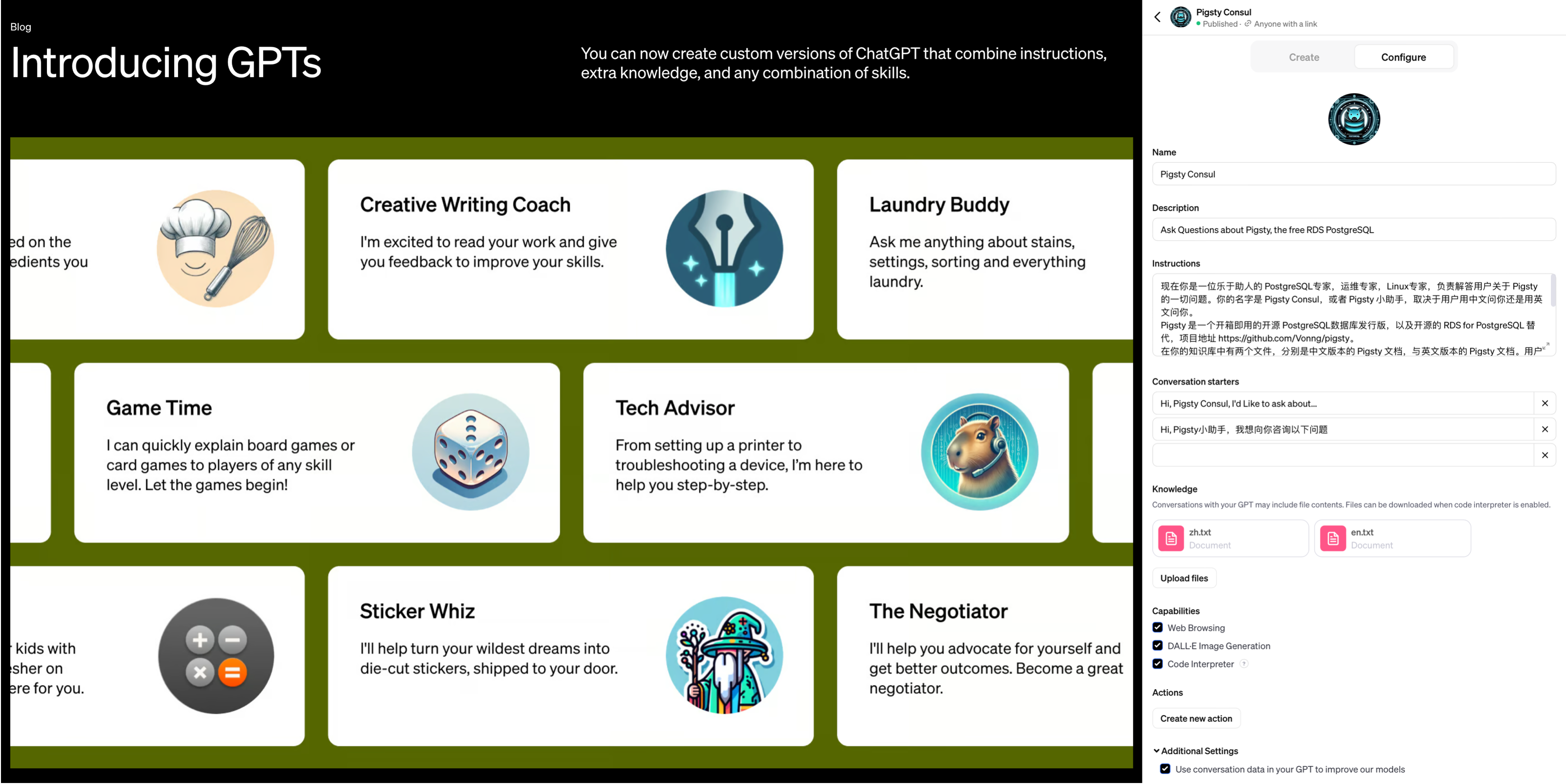

- 2024-11-26 创业出海神器 Supabase 自建指南

- 2024-11-21 面向未来数据库的现代硬件

- 2024-11-18 这么吹国产数据库,听的尴尬癌都要犯了

- 2024-11-17 20刀好兄弟PolarDB:论数据库该卖什么价?

- 2024-11-15 不要更新!发布当日叫停:PG也躲不过大翻车

- 2024-11-14 PostgreSQL 12 过保,PG 17 上位

- 2024-11-05 PZ:MySQL还有机会赶上PostgreSQL的势头吗?

- 2024-11-02 PostgreSQL神功大成!最全扩展仓库

- 2024-10-28 YC教父Paul Graham:写作者与非写作者

- 2024-10-25 开源皇帝Linus清洗整风

- 2024-10-01 第二批数据库国测名单:国产化来了怎么办?

- 2024-09-27 PostgreSQL 17 发布:摊牌了,我不装了!

- 2024-09-26 PG系创业公司Supabase:$80M C轮融资

- 2024-09-07 先优化碳基BIO核,再优化硅基CPU核

- 2024-09-05 PostgreSQL 17 RC1 发布!与近期PG新闻

- 2024-09-04 MongoDB没有未来:“好营销”救不了烂芒果

- 2024-09-03 《黑历史:Mongo》:现由PostgreSQL驱动

- 2024-09-02 PostgreSQL可以替换微软SQL Server吗?

- 2024-08-30 ElasticSearch又重新开源了???

- 2024-08-22 GOTC 2024 BTW采访冯若航:Pigsty作者,简化PG管理,推动PG开源社区的中国参与

- 2024-08-13 谁整合好DuckDB,谁赢得OLAP数据库世界

- 2024-08-09 PostgreSQL小版本更新,17beta3,12将EOL

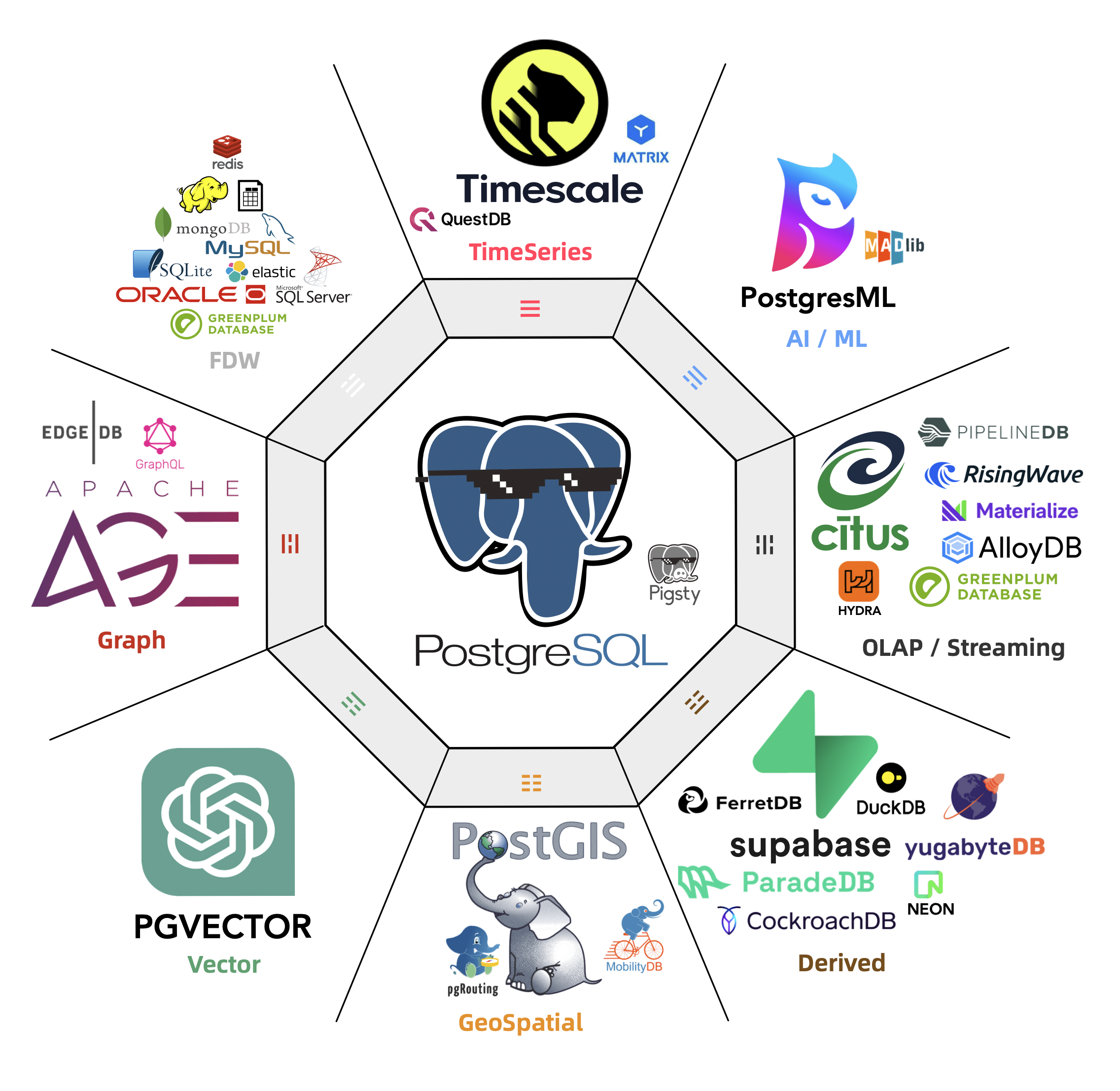

- 2024-08-06 PG隆中对,一个PG三个核,一个好汉三百个帮

- 2024-08-03 最近在憋大招,数据库全能王真的要来了

- 2024-07-31 ClickHouse收购PeerDB:这浓眉大眼的也要来搞 PG 了?

- 2024-07-25 StackOverflow 2024调研:PostgreSQL已经超神了

- 2024-07-15 机场出租车恶性循环与国产数据库怪圈

- 2024-07-12 MySQL新版恶性Bug,表太多就崩给你看!

- 2024-07-09 MySQL安魂九霄,PostgreSQL驶向云外

- 2024-06-28 CentOS 7过保了,换什么OS发行版更好?

- 2024-06-26 用PG的开发者,年薪比MySQL多赚四成?

- 2024-06-20 Oracle最终还是杀死了MySQL!

- 2024-06-19 MySQL性能越来越差,Sakila将何去何从?

- 2024-06-18 让PG停摆一周的大会:PGCon.Dev参会记

- 2024-05-29 PGCon.Dev 2024 温哥华扩展生态峰会小记

- 2024-05-24 PostgreSQL 17 Beta1 发布!牙膏管挤爆了!

- 2024-05-16 为什么PostgreSQL是未来数据的基石?

- 2024-04-25 国产数据库到底能不能打?

- 2024-03-28 PostgreSQL 主要贡献者 Simon Riggs 因坠机去世

- 2024-03-26 Redis不开源是“开源”之耻,更是公有云之耻

- 2024-03-24 PostgreSQL会修改开源许可证吗?

- 2024-03-16 PostgreSQL is eating the database world

- 2024-03-14 RDS阉掉了PostgreSQL的灵魂

- 2024-03-04 PostgreSQL正在吞噬数据库世界

- 2024-02-19 技术极简主义:一切皆用Postgres

- 2024-02-18 PG生态新玩家ParadeDB

- 2024-02-02 DBA会被云淘汰吗?

- 2024-01-14 快速掌握PostgreSQL版本新特性

- 2024-01-13 令人惊叹的PostgreSQL可伸缩性

- 2024-01-11 国产数据库是大炼钢铁吗?

- 2024-01-08 中国对PostgreSQL的贡献约等于零吗?

- 2024-01-05 展望PostgreSQL的2024 (Jonathan Katz)

- 2024-01-03 2023年度数据库:PostgreSQL (DB-Engine)

- 2023-12-31 2023总结:三十而立

- 2023-12-30 MySQL的正确性为何如此拉垮?

- 2023-12-05 数据库应该放入K8S里吗?

- 2023-12-04 把数据库放入Docker是一个好主意吗?

- 2023-11-22 向量数据库凉了吗?

- 2023-11-17 重新拿回计算机硬件的红利

- 2023-11-02 数据库真被卡脖子了吗?

- 2023-10-26 PG查询优化:观宏之道

- 2023-10-09 EL系操作系统发行版哪家强?

- 2023-10-08 FerretDB:假扮成MongoDB的PostgreSQL?

- 2023-09-27 如何用 pg_filedump 抢救数据?

- 2023-09-26 PGSQL x Pigsty: 数据库全能王来了

- 2023-09-10 PG先写脏页还是先写WAL?

- 2023-09-08 冯若航:不想当段子手的技术狂,不是一位好的开源创始人

- 2023-08-31 基础软件到底需要什么样的自主可控?

- 2023-08-11 如何看待 MySQL vs PGSQL 直播闹剧

- 2023-08-09 驳《MySQL:这个星球最成功的数据库》

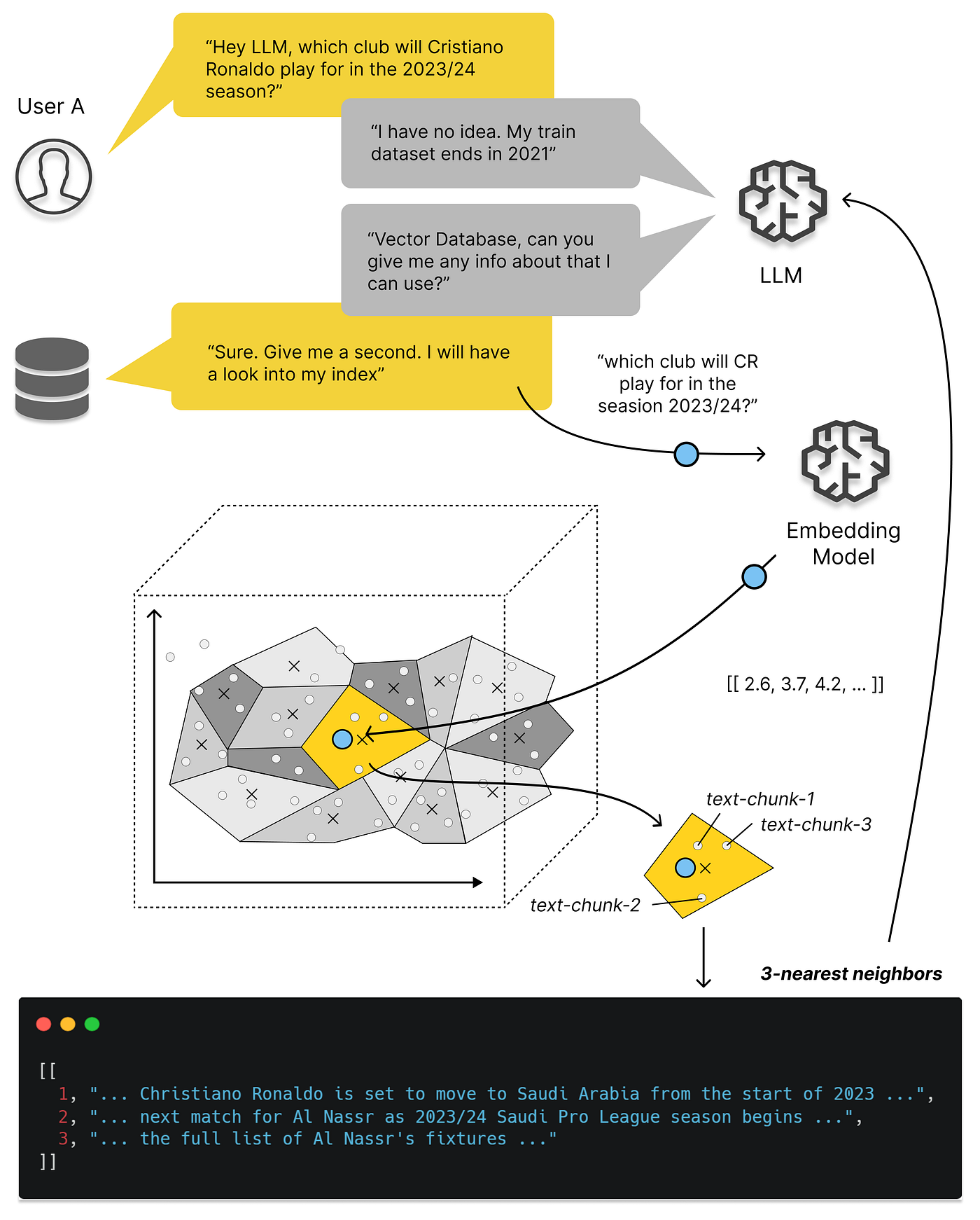

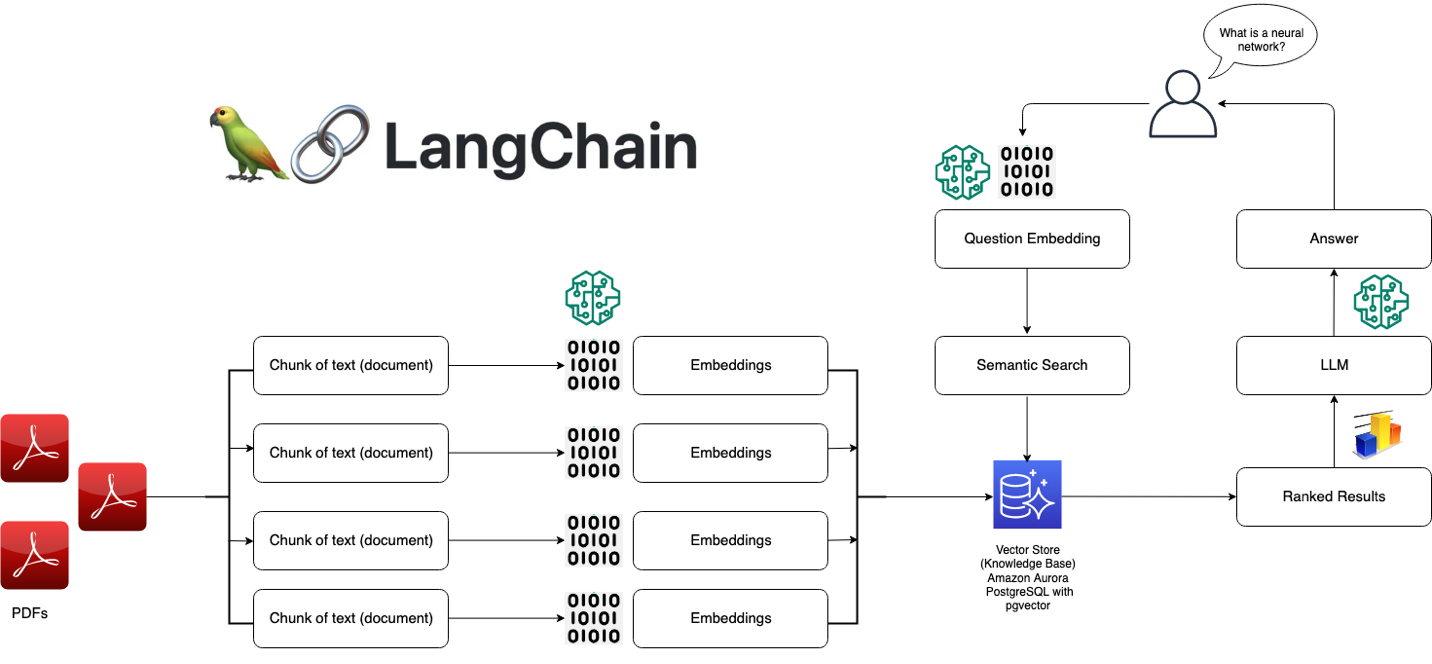

- 2023-08-06 向量是新的JSON

- 2023-06-27 ISD数据集:分析全球120年气候变化

- 2023-05-10 AI大模型与向量数据库 PGVECTOR

- 2023-05-09 技术反思录:正本清源 之 序章

- 2023-05-07 微服务是不是个蠢主意?

- 2023-04-17 分布式数据库是伪需求吗?

- 2023-04-10 AI 会有自我意识吗?

- 2023-03-29 数据库需求层次金字塔

- 2023-03-01 驳《再论为什么你不应该招DBA》

- 2023-01-31 云数据库是不是杀猪盘

- 2023-01-31 你怎么还在招聘DBA? 马工

- 2023-01-30 云数据库是不是智商税

- 2022-08-22 PostgreSQL 到底有多强?

- 2022-07-12 为什么PostgreSQL是最成功的数据库?

- 2022-07-07 90后,辞职创业,说要卷死云数据库

- 2022-06-24 StackOverflow 2022数据库年度调查

- 2022-05-16 云RDS:从删库到跑路

- 2022-05-10 DBA还是一份好工作吗?

- 2021-05-08 为什么说PostgreSQL前途无量?

七周七数据库(2025年)

作者:Matt Blewitt,原文:七周七数据库(2025年)

译者:冯若航,数据库老司机,云计算泥石流

https://matt.blwt.io/post/7-databases-in-7-weeks-for-2025/

长期以来,我一直在运营数据库即服务(Databases-as-a-Service),这个领域总有新鲜事物需要跟进 —— 新技术、解决问题的不同方法,更别提大学里不断涌现的研究成果了。展望2025年,考虑花一周时间深入了解以下每项数据库技术吧。

前言

这不是 “七大最佳数据库” 之类的文章,更不是给报菜单念书名式的列表做铺垫——这里只是我认为值得你花一周左右时间认真研究的七个数据库。你可能会问,“为什么不选Neo4j、MongoDB、MySQL / Vitess 或者其他数据库呢?”答案大多是:我觉得它们没啥意思。同时,我也不会涉及 Kafka 或其他类似的流数据服务——它们确实值得你花时间学习,但不在本文讨论范围内。

目录

1. PostgreSQL

默认数据库

“一切皆用 Postgres” 几乎成了一个梗,原因很简单。PostgreSQL 是 枯燥技术 的巅峰之作,当你需要 客户端-服务器 模型的数据库时,它应该是你的首选。PG 遵循ACID原则,拥有丰富的复制方法 —— 包括物理和逻辑复制—— 并且在所有主要供应商中都有极好的支持。

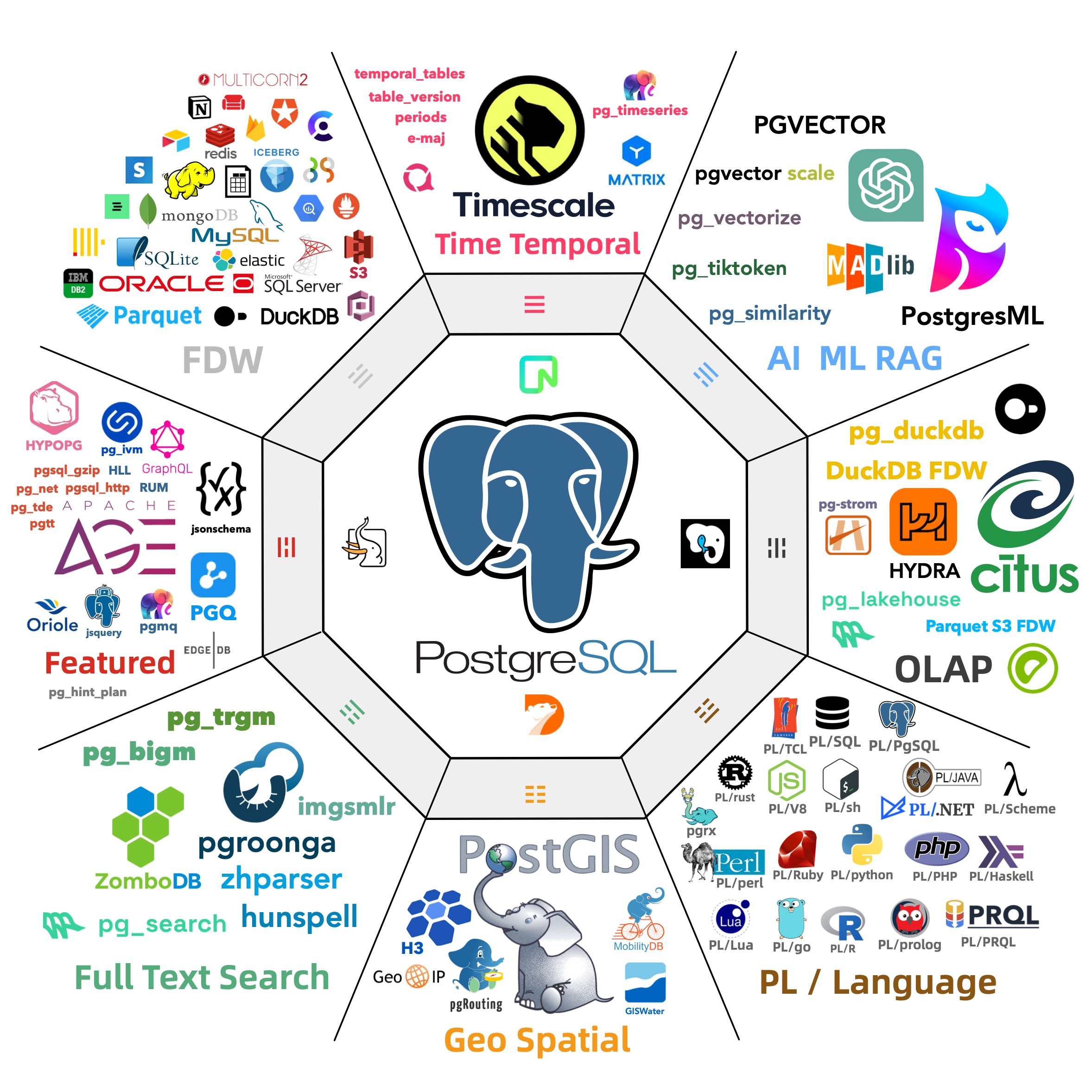

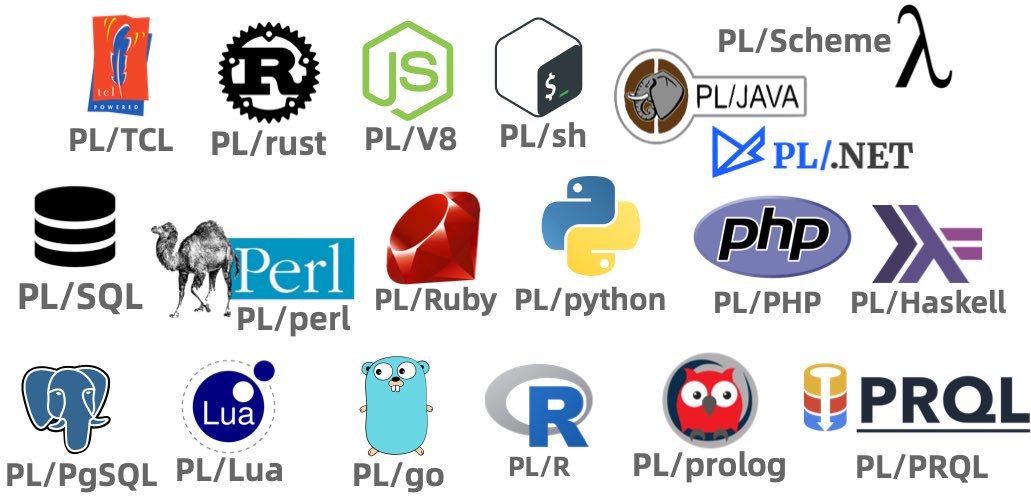

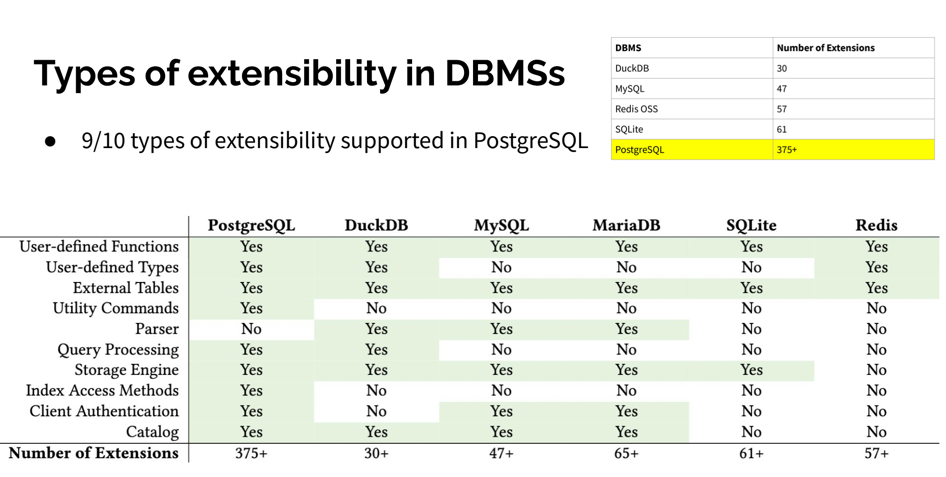

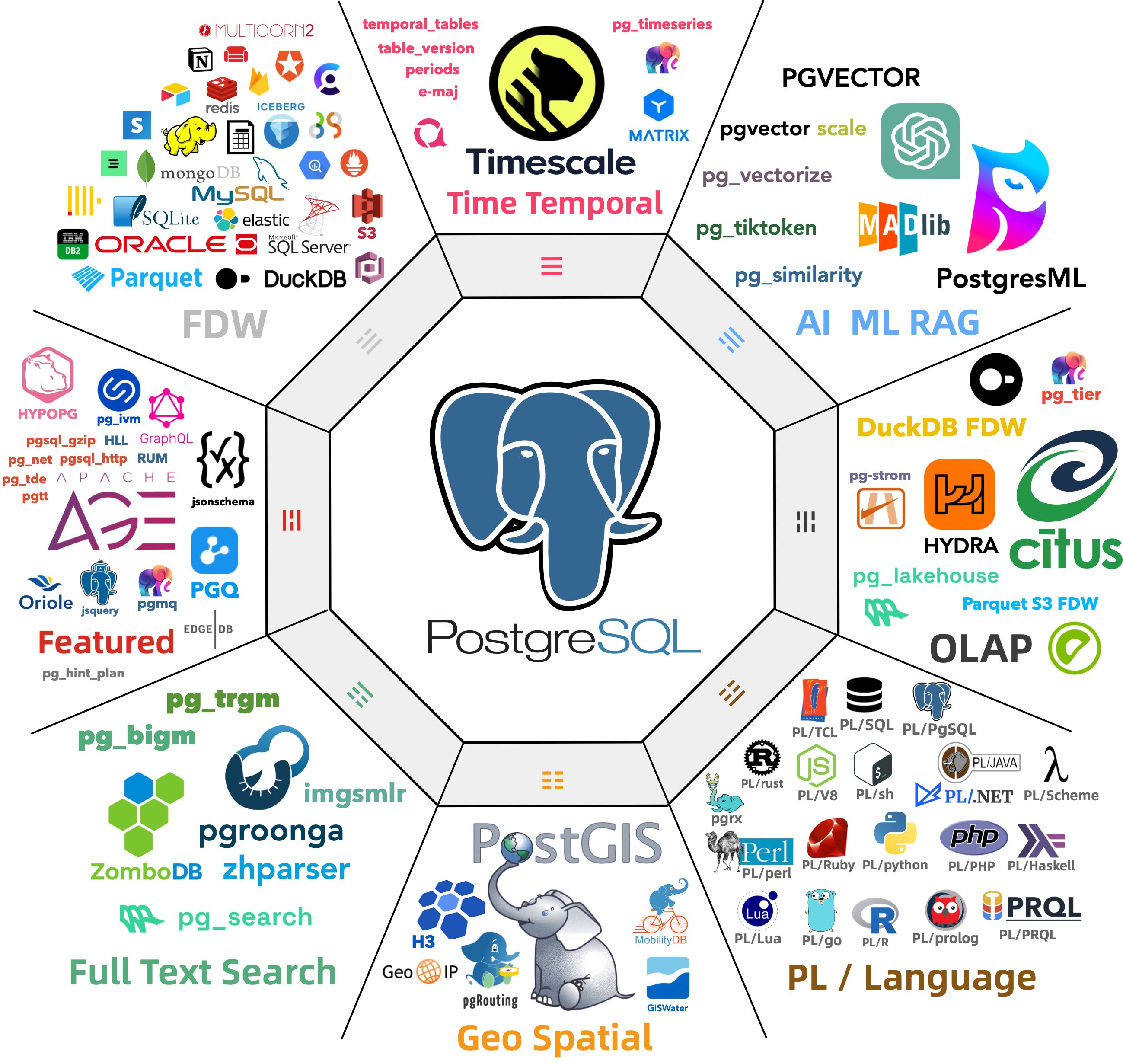

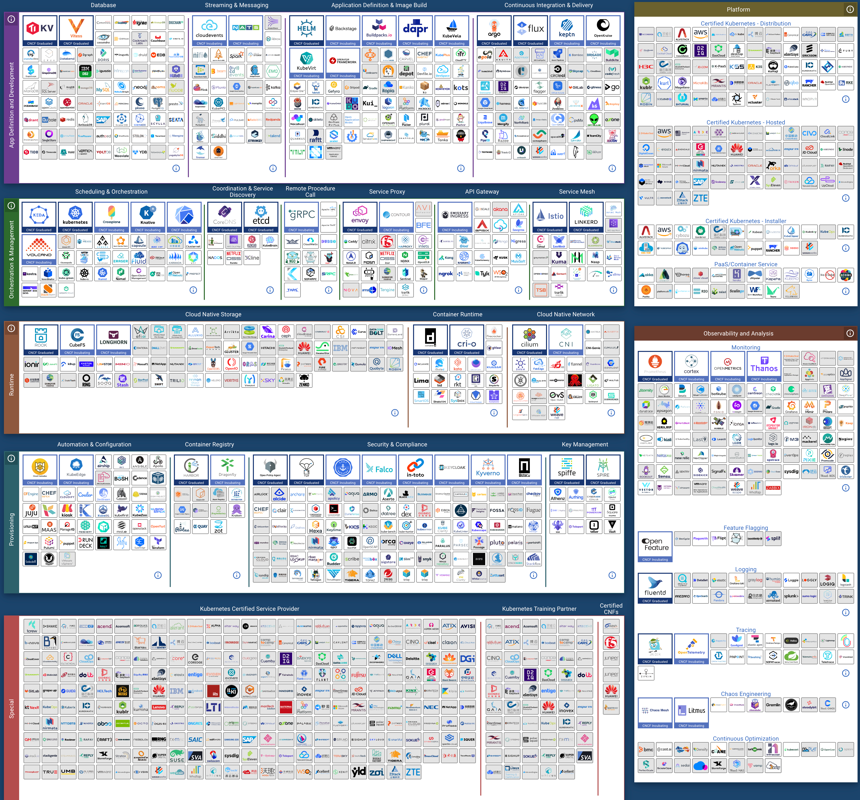

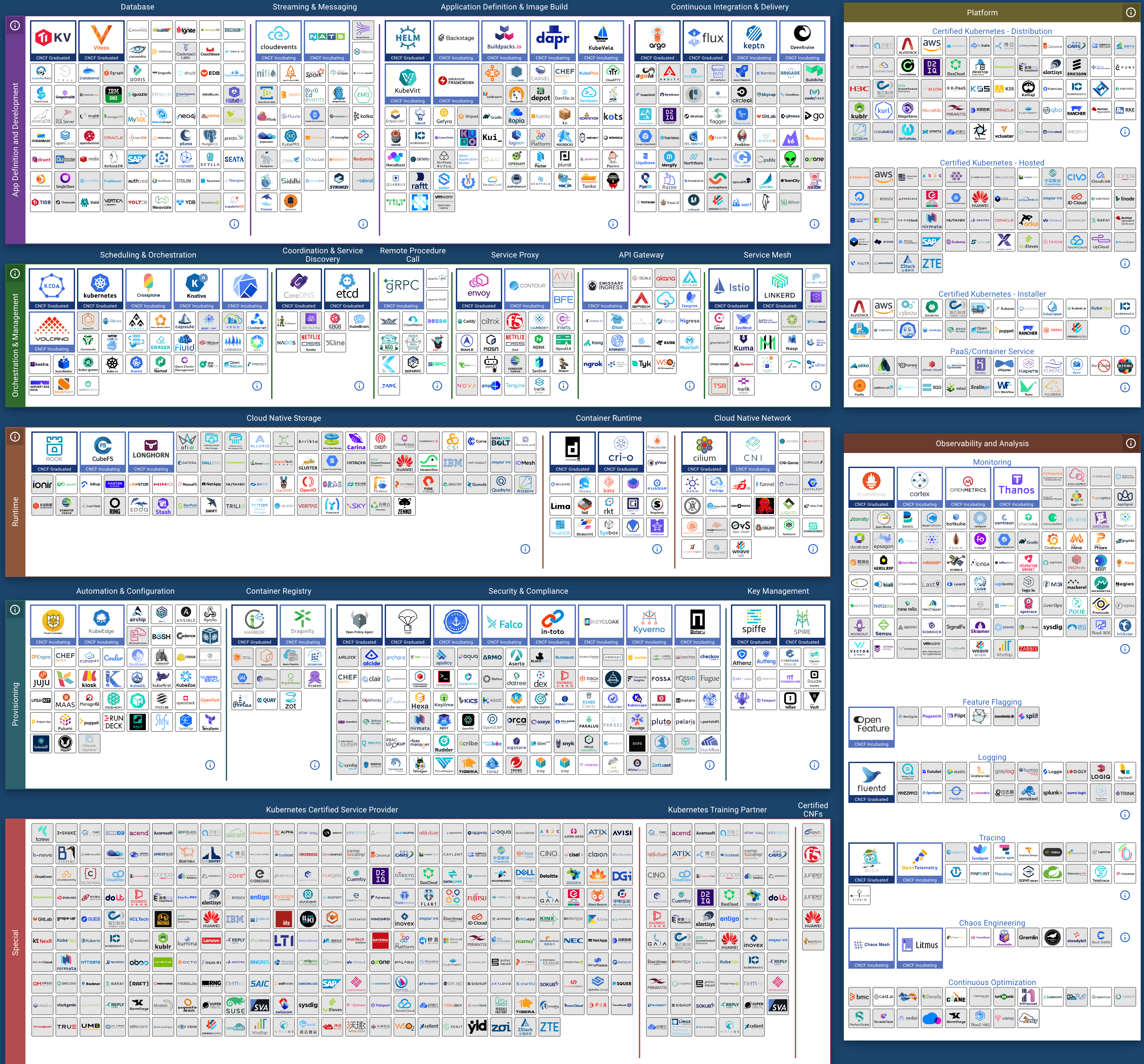

然而,我最喜欢 Postgres 功能是 扩展。在这一点上,Postgres 展现出了其他数据库难以企及的生命力。几乎你想要的功能都有相应的扩展——AGE支持图数据结构和Cypher查询语言,TimescaleDB支持时间序列工作负载,Hydra Columnar提供了另一种列式存储引擎,等等。如果你有兴趣亲自尝试,我最近写了一篇关于编写扩展的文章。

正因为如此,Postgres 作为一个优秀的 “默认” 数据库熠熠生辉,我们还看到越来越多的非 Postgres 服务使用 Postgres 线缆协议 作为通用的七层协议,以提供客户端兼容性。拥有丰富的生态系统、合理的默认行为,甚至可以用 Wasm 跑在浏览器中,这使得它成为一个值得深入理解的数据库。

花一周时间了解 Postgres 的各种可能性,同时也了解它的一些限制 ——MVCC 可能有些任性。用你最喜欢的编程语言实现一个简单的CRUD应用程序,甚至可以尝试构建一个 Postgres 扩展。

2. SQLite

本地优先数据库

离开客户端-服务器模型,我们绕道进入 “嵌入式” 数据库,首先介绍 SQLite。我将其称为“本地优先”数据库,因为SQLite数据库与应用程序直接共存。一个更著名的例子是WhatsApp,它将聊天记录存储为设备上的本地 SQLite 数据库。Signal 也是如此。

除此之外,我们开始看到更多 SQLite 的创新玩法,而不仅仅是将其当成一个本地ACID数据库。像 Litestream 这样的工具提供了流式备份的能力, LiteFS 提供了分布式访问的能力,这让我们可以设计出更有趣的拓扑架构。像CR-SQLite 这样的扩展允许使用 CRDTs,以避免在合并变更集时需要冲突解决,正如 Corrosion 的例子一样。

得益于Ruby on Rails 8.0,SQLite也迎来了一个小型复兴 ——37signals 全面投入 SQLite,构建了一系列 Rails 模块,如 Solid Queue,并通过database.yml配置 Rails 以操作多个 SQLite 数据库。Bluesky 使用SQLite作为个人数据服务器 —— 每个用户都有自己的 SQLite 数据库。

花一周时间使用 SQLite ,探索一下本地优先架构,你甚至可以研究下是否能将使用 Postgres 的客户端-服务器模型迁移到只使用 SQLite 的模式上。

3. DuckDB

万能查询数据库

接下来是另一个嵌入式数据库,DuckDB。与SQLite类似,DuckDB旨在成为一个内嵌于进程的数据库系统,但更侧重于在线分析处理(OLAP)而非在线事务处理(OLTP)。

DuckDB 的亮点在于它作为一个“万能查询”数据库,使用 SQL 作为首选方言。它可以原生地从 CSV、TSV、JSON ,甚至像 Parquet 这样的格式中导入数据 —— 看看 DuckDB的数据源列表 支持的数据源列表吧!这赋予了它极大的灵活性 —— 不妨看看 查询Bluesky火焰管道的这个示例。

与 Postgres 类似,DuckDB 也有 扩展,尽管生态系统没有那么丰富 —— 毕竟DuckDB还相对年轻。许多社区贡献的扩展可以在社区扩展列表中找到,我特别喜欢gsheets。

花一周时间使用DuckDB进行一些数据分析和处理——无论是通过 Python Notebook,还是像Evidence这样的工具,甚至看看它如何与SQLite的“本地优先”方法结合,将SQLite数据库的分析查询卸载到DuckDB,毕竟 DuckDB 也可以读取SQLite数据。

4. ClickHouse

列式数据库

离开嵌入式数据库领域,但继续看看分析领域,我们会遇上 ClickHouse。如果我只能选择两种数据库,我会非常乐意只用 Postgres 和 ClickHouse——前者用于OLTP,后者用于OLAP。

ClickHouse 专注于分析工作负载,并且通过横向扩展和分片存储,支持非常高的摄取率。它还支持分层存储,允许你将“热”数据和“冷”数据分开—— GitLab对此有相当详尽的文档。

当你需要在一个 DuckDB 吃不下的大数据集上运行分析查询,或者需要 “实时” 分析时,ClickHouse 会有优势。关于这些数据集已经有很多 “Benchmarketing”(打榜营销)了,所以我就不再赘述了。

我建议你了解 ClickHouse 的另一个原因是它的操作体验极佳 —— 部署、扩展、备份等都有详尽的文档——甚至包括设置 合适的 CPU Governor。

花一周时间探索一些更大的分析数据集,或者将上面 DuckDB 分析转换为 ClickHouse 部署。ClickHouse 还有一个嵌入式版本 —— chDB—— 可以提供更直接的对比。

5. FoundationDB

分层数据库

现在我们进入了这个列表中的 “脑洞大开” 部分,FoundationDB 登场。可以说,FoundationDB 不是一个数据库,而是数据库的基础组件。被 Apple、Snowflake 和 Tigris Data 等公司用于生产环境,FoundationDB 值得你花点时间,因为它在键值存储世界中相当独特。

是的,它是一个有序的键值存储,但这并不是它有趣的点。乍看它有一些奇特的限制——例如事务不能影响超过10MB 以上的数据,事务首次读取后必须在五秒内结束。但正如他们所说,限制让我们自由。通过施加这些限制,它可以在非常大的规模上实现完整的 ACID 事务—— 我知道有超过 100 TiB 的集群在运行。

FoundationDB 针对特定的工作负载而设计,并使用仿真方法试进行了广泛地测试,这种测试方法被其他技术采纳,包括本列表中的另一个数据库和由一些前 FoundationDB 成员创立的 Antithesis。关于这一部分请参阅 Tyler Neely 和 PhilEaton 的相关笔记。

如前所述,FoundationDB 具有一些非常特定的语义,需要一些时间来适应——他们的 特性 文档和 反特性 (不打算在数据库中提供的功能)文档值得去了解,以理解他们试图解决的问题。

但为什么它是“分层”数据库?因为它提出了分层的概念,而不是选择将存储引擎与数据模型耦合在一起,而是设计了一个足够灵活的存储引擎,可以将其功能重新映射到不同的层面上。Tigris Data有一篇关于构建此类层的优秀文章,FoundationDB 组织还有一些示例,如 记录层 和 文档层。

花一周时间浏览 教程,思考如何使用FoundationDB替代像 RocksDB 这样的数据库。也许可以看看一些 设计方案 并阅读 论文。

6. TigerBeetle

极致正确数据库

继确定性仿真测试之后,TigerBeetle 打破了先前数据库的模式,因为它明确表示自己 不是一个通用数据库 —— 它完全专注于金融事务场景。

为什么值得一看?单一用途的数据库很少见,而像 TigerBeetle 这样痴迷于正确性的数据库更是稀有,尤其是考虑到它是开源的。它们包含了从 NASA的十律 和 协议感知恢复 到严格的串行化和 Direct I/O 以避免内核页面缓存问题,这一切的一切真是 非常 令人印象深刻——看看他们的 安全文档 和他们称之为 Tiger Style 的编程方法 吧!

另一个有趣的点是,TigerBeetle是用 Zig 编写的——这是一门相对新兴的系统编程语言,但显然与 TigerBeetle 团队的目标非常契合。

花一周时间在本地部署的 TigerBeetle 中建模你的金融账户——按照 快速入门 操作,并看看系统架构文档,了解如何将其与上述更通用的数据库结合使用。

7. CockroachDB

全球分布数据库

最后,我们回到了起点。在最后一个位置上,我有点纠结。我最初的想法是 Valkey,但 FoundationDB 已经满足了键值存储的需求。我还考虑过图数据库,或者像 ScyllaDB 或 Cassandra 这样的数据库。我还考虑过 DynamoDB,但无法本地/免费运行让我打消了这个想法。

最终,我决定以一个全球分布式数据库结束 —— CockroachDB。它兼容 Postgres 线缆协议,并继承了前面讨论的一些有趣特性——大规模横向扩展、强一致性——还拥有自己的一些有趣功能。

CockroachDB 实现了跨多个地理区域的数据库伸缩能力,生态位与 Google Spanner 系统重叠,但 Spanner 依赖原子钟和GPS时钟进行极其精确的时间同步,然而普通硬件没有这样的奢侈配置,因此 CockroachDB 有一些巧妙的解决方案,通过重试或延迟读取以应对 NTP 时钟同步延迟,节点之间还会比较时钟漂移,如果超过最大偏移量则会终止成员。

CockroachDB 的另一个有趣特性是如何使用多区域配置,包括表的本地性,根据你想要的读写利弊权衡提供不同的选项。花一周时间在你选择的语言和框架中重新实现 movr 示例吧。

总结

我们探索了许多不同的数据库,这些数据库都被地球上一些最大的公司在生产环境中使用,希望这能让你接触到一些之前不熟悉的技术。带着这些知识,去解决有趣的问题吧!

老冯评论

在 2013 年有一本书叫《七周七数据库》。那本书介绍了当时的 7 种 “新生(或者重生)” 的数据库技术,给我留下了印象。12 年后,这个系列又开始有更新了。

回头看看当年的七数据库,除了原本的 “锤子” PostgreSQL 还在,其他的数据库都已经物是人非了。而 PostgreSQL 已经从 “锤子” 成为了 “枯燥数据库之王” —— 成为了不会翻车的 “默认数据库”。

在这个列表中的数据库,基本都是我已经实践过或者感兴趣/有好感的对象。当然 ClickHouse 除外,CK 不错,但我觉得 DuckDB 以及其与 PostgreSQL 的组合有潜力把 CK 给拱翻,再加上是 MySQL 协议兼容生态,所以对它确实没有什么兴趣。如果让我来设计这份名单,我大概会把 CK 换成 Supabase 或 Neon 中的一个。

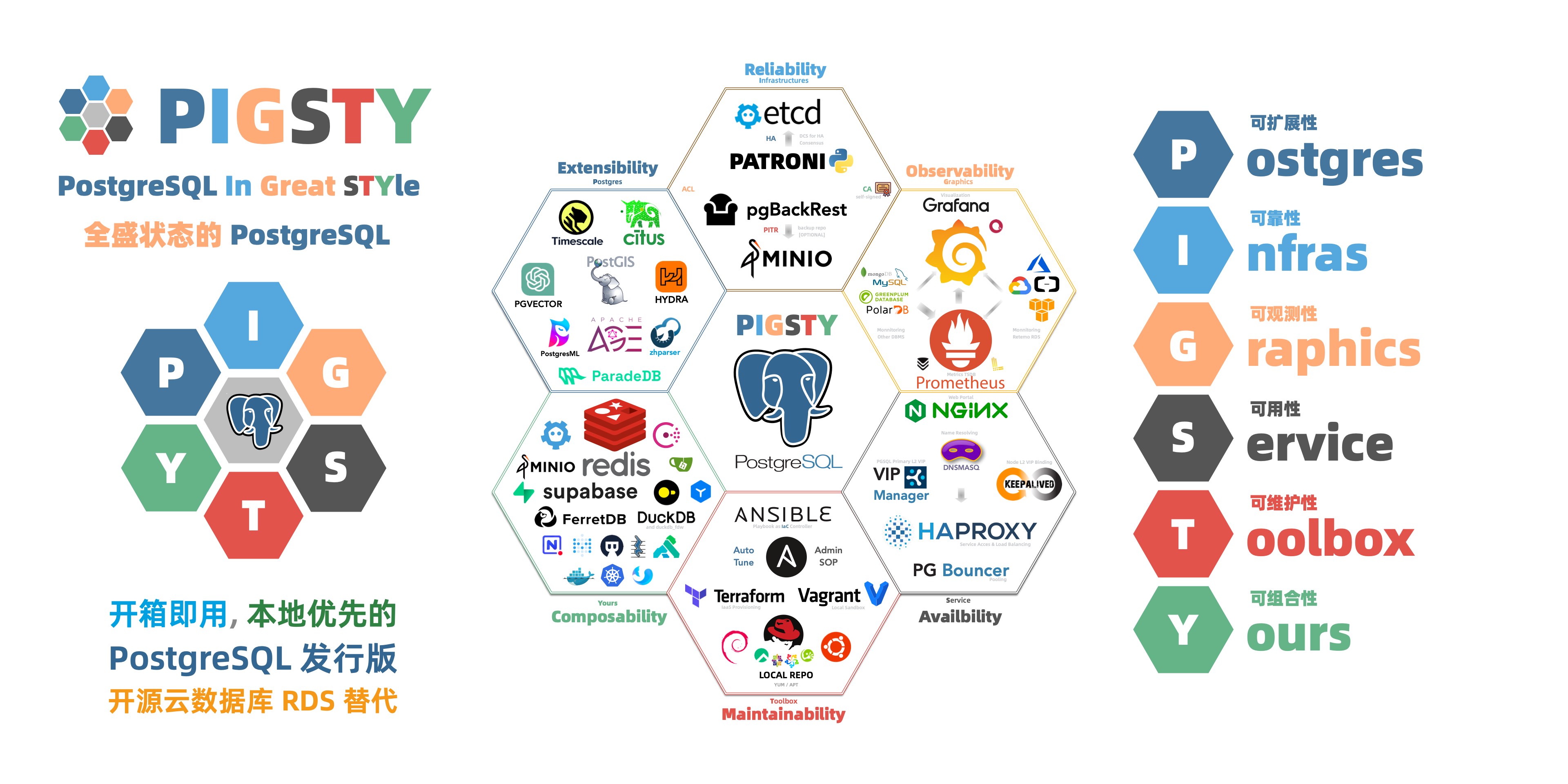

我认为作者非常精准的把握了数据库技术发展的趋势,我高度赞同他对数据库技术的选择。实际上在这七个数据库中,我已经深入涉猎了其中三个。Pigsty 本身是一个高可用的 PostgreSQL 发行版,里面也整合了 DuckDB,以及 DuckDB 缝合的PG扩展。Tigerbettle 我也做好了 RPM/DEB 包,作为专业版中默认下载的金融事务专用数据库。

另外两个数据库,正在我的整合 TODOLIST 中,SQLite 除了 FDW,下一步就是把 ElectricSQL 给弄进来;提供本地 PG 与远端 SQLite / PGLite 的同步能力;CockroachDB 则一直在我的 TODOLIST 中,准备一有空闲就做个部署支持。FoundationDB 是我感兴趣的对象,下一个我愿意花时间深入研究的数据库不出意料会是这个。

总的来说,我认为这些技术代表着领域前沿的发展趋势。如果让我设想一下十年后的格局,那么大概会是这样的: FoundationDB,TigerBeetle,CockRoachDB 能有自己的小众基本盘生态位。DuckDB 大概会在分析领域大放异彩,SQLite 会在本地优先的端侧继续攻城略地,而 PostgreSQL 会从 “默认数据库” 变成无处不在的的 “Linux 内核”,数据库领域的主旋律变成 Neon,Supabase,Vercel,RDS,Pigsty 这样 PostgreSQL 发行版竞争的战场。

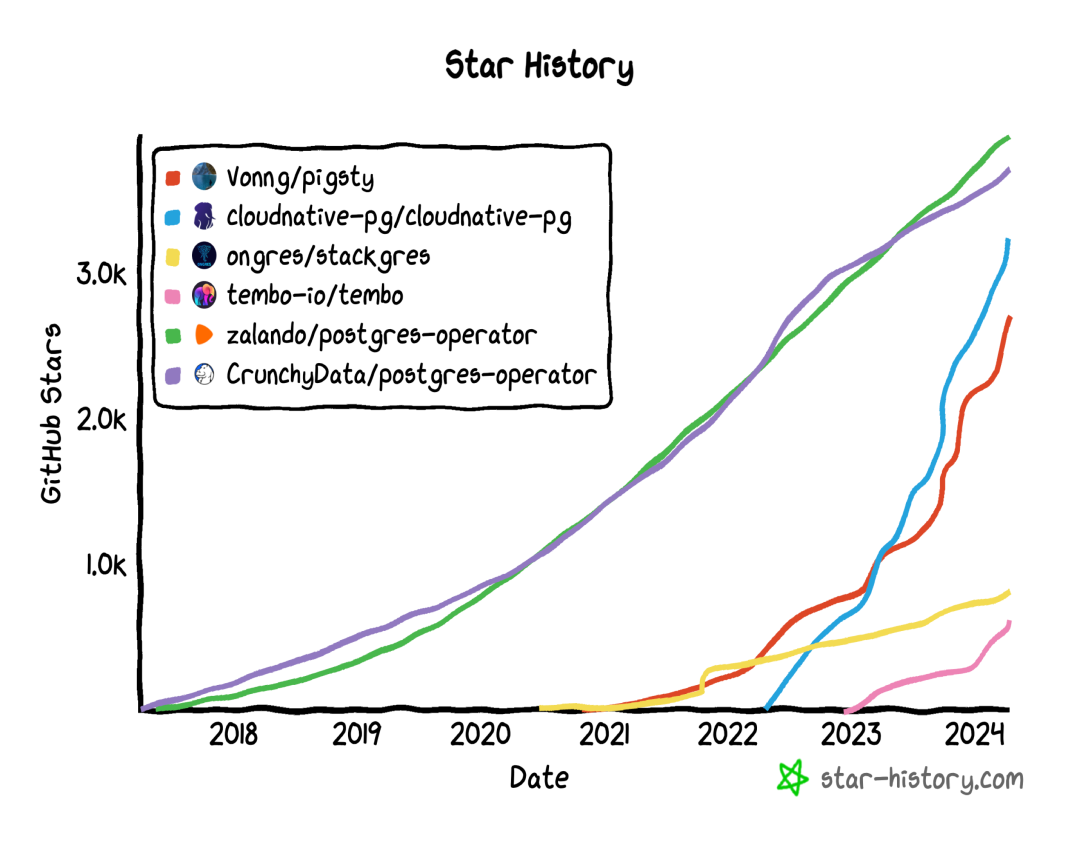

毕竟,PostgreSQL 吞噬数据库世界可不只是说说而已,PostgreSQL生态的公司几乎拿光了这两年资本市场数据库领域的钱,早就有无数真金白银用脚投票押注上去了。当然,未来到底如何,还是让我们拭目以待吧。

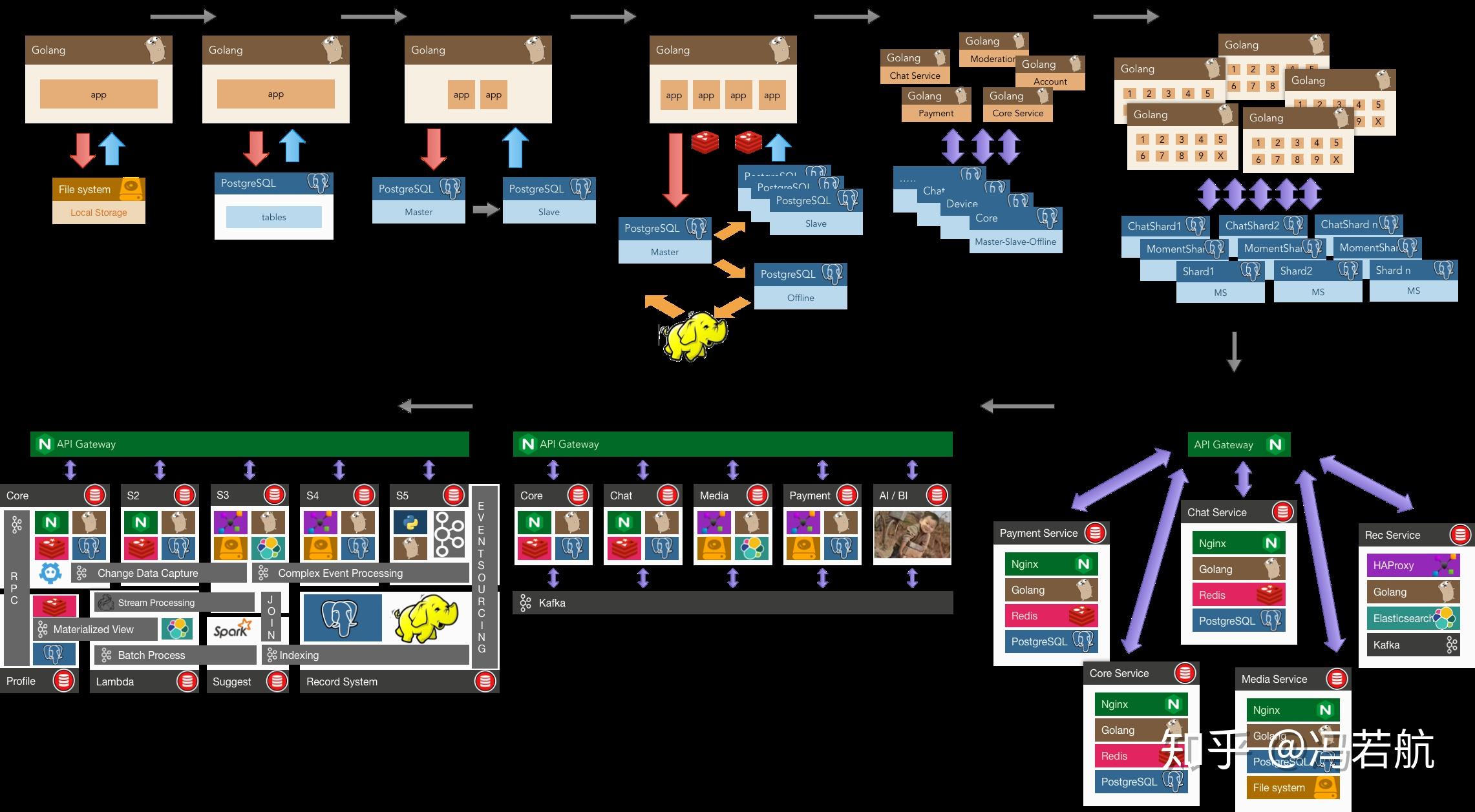

自建Supabase:创业出海的首选数据库

Supabase 非常棒,拥有你自己的 Supabase 那就是棒上加棒! 本文介绍了如何在本地/云端物理机/裸金属/虚拟机上自建企业级 Supabase。

目录

Supabase是什么?

Supabase 是一个开源的 Firebase,是一个 BaaS (Backend as Service)。 Supabase 对 PostgreSQL 进行了封装,并提供了身份认证,消息传递,边缘函数,对象存储,以及基于 PG 数据库模式自动生成的 REST API 与 GraphQL API。

Supabase 旨在为开发者提供一站式的后端解决方案,减少开发和维护后端基础设施的复杂性,使开发者专注于前端开发和用户体验。 用大白话来说就是:让开发者告别绝大部分后端开发的工作,只需要懂数据库设计与前端即可快速出活!

目前,Supabase 是 PostgreSQL 生态人气最高的开源项目,在 GitHub 上已经有高达7万4千的Star数。 并且和 Neon,Cloudflare 一起并称为赛博菩萨 —— 因为他们都提供了非常不错的云服务免费计划。 目前,Supabase 和 Neon 已经成为许多初创企业的首选数据库 —— 用起来非常方便,起步还是免费的。

为什么要自建Supabase?

小微规模(4c8g)内的 Supabase 云服务极富性价比,人称赛博菩萨。那么 Supabase 云服务这么香,为什么要自建呢?

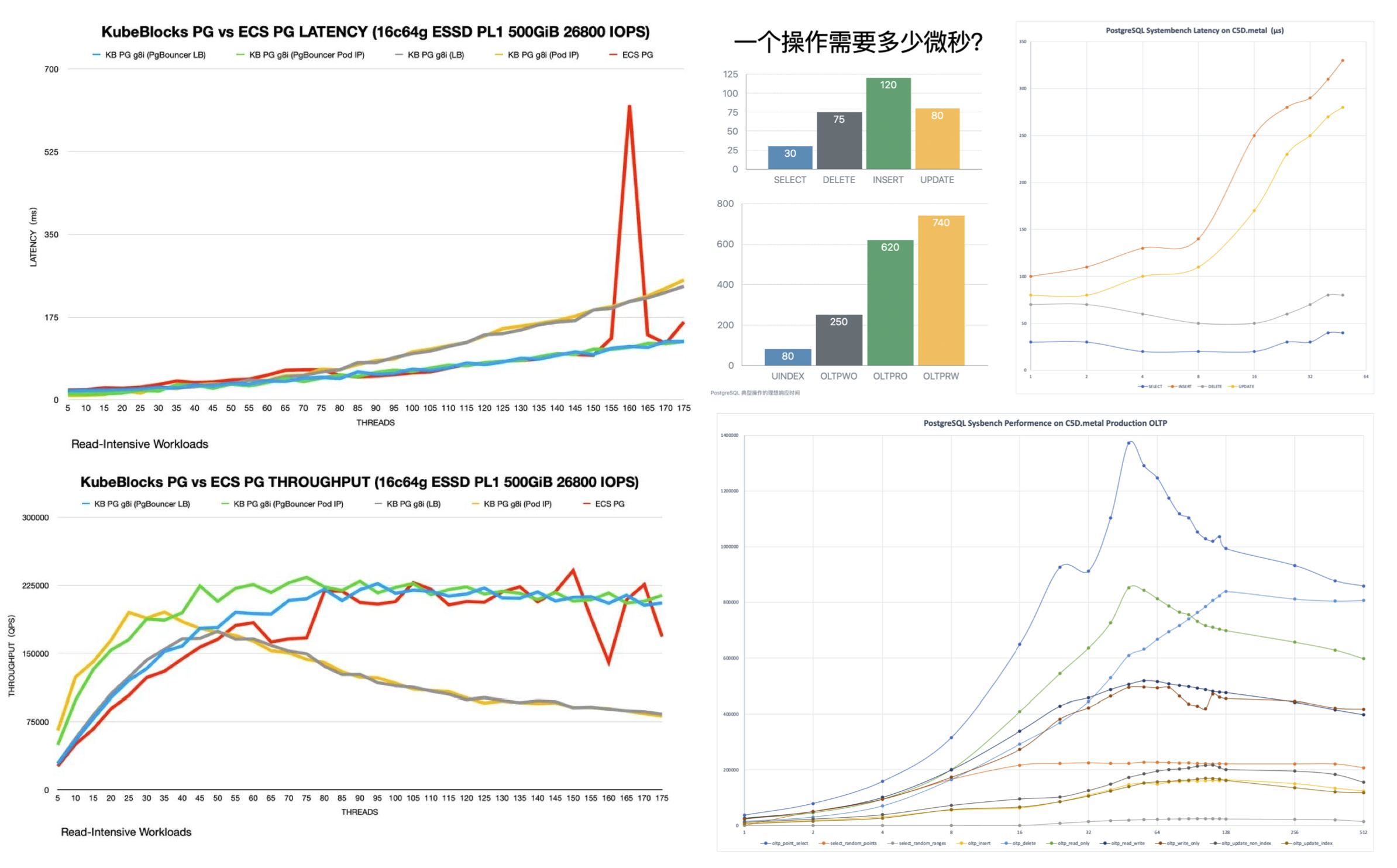

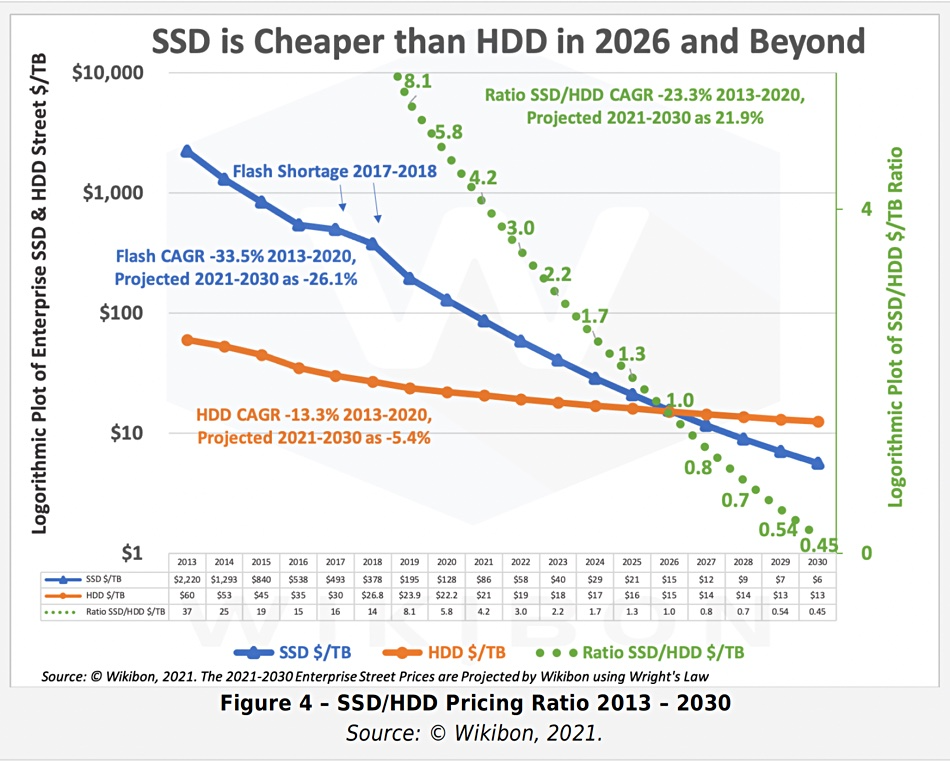

最直观的原因是是我们在《云数据库是智商税吗?》中提到过的:当你的规模超出云计算适用光谱,成本很容易出现爆炸式增长。 而且在当下,足够可靠的本地企业级 NVMe SSD在性价比上与云端存储有着三到四个数量级的优势,而自建能更好地利用这一点。

另一个重要的原因是功能, Supabase 云服务的功能受限 —— 出于与RDS相同的逻辑, 很多 强力PG扩展 因为多租户安全挑战与许可证的原因无法作为云服务提供。 故而尽管PG扩展是 Supabase 的一个核心特色,在云服务上也依然只有 64 个可用扩展,而 Pigsty 提供了多达 340 个开箱即用的 PG 扩展。

此外,尽管 Supabase 虽然旨在提供一个无供应商锁定的 Google Firebase 开源替代,但实际上自建高标准企业级的 Supabase 门槛并不低: Supabase 内置了一系列由他们自己开发维护的 PG 扩展插件,而这些扩展在 PGDG 官方仓库中并没有提供。 这实际上是某种隐性的供应商锁定,阻止了用户使用除了 supabase/postgres Docker 镜像之外的方式自建。

Pigsty 解决了这些问题,我们将所有 Supabase 自研与用到的 10 个缺失的扩展打成开箱即用的 RPM/DEB 包,确保它们在所有主流Linux操作系统发行版上都可用:

- pg_graphql:提供PG内的GraphQL支持 (RUST),Rust扩展,由PIGSTY提供

- pg_jsonschema:提供JSON Schema校验能力,Rust扩展,由PIGSTY提供

- wrappers:Supabase提供的外部数据源包装器捆绑包,,Rust扩展,由PIGSTY提供

- index_advisor:查询索引建议器,SQL扩展,由PIGSTY提供

- pg_net:用 SQL 进行异步非阻塞HTTP/HTTPS 请求的扩展 (supabase),C扩展,由PIGSTY提供

- vault:在 Vault 中存储加密凭证的扩展 (supabase),C扩展,由PIGSTY提供

- pgjwt:JSON Web Token API 的PG实现 (supabase),SQL扩展,由PIGSTY提供

- pgsodium:表数据加密存储 TDE,扩展,由PIGSTY提供

- supautils:用于在云环境中确保数据库集群的安全,C扩展,由PIGSTY提供

- pg_plan_filter:使用执行计划代价过滤阻止特定查询语句,C扩展,由PIGSTY提供

我们还在 Supabase 中默认安装了以下扩展,您可以参考可用扩展列表启用更多。

- timescaledb postgis pg_graphql pg_jsonschema wrappers pg_search pg_analytics pg_parquet plv8 duckdb_fdw pg_cron pg_timetable pgqr

- supautils pg_plan_filter passwordcheck plpgsql_check pgaudit pgsodium pg_vault pgjwt pg_ecdsa pg_session_jwt index_advisor

- pgvector pgvectorscale pg_summarize pg_tiktoken pg_tle pg_stat_monitor hypopg pg_hint_plan pg_http pg_net pg_smtp_client pg_idkit

同时,Pigsty 还会负责好底层高可用 PostgreSQL 数据库集群,高可用 MinIO 对象存储集群的自动搭建,甚至是 Docker 容器底座的部署。 最终,您可以使用 Docker Compose 拉起任意数量的无状态 Supabase 容器集群,并使用外部由 Pigsty 托管的企业级 PostgreSQL 数据库与 MinIO 对象存储,甚至连反向代理的 Nginx 等都已经为您配置准备完毕!

在这一自建部署架构中,您获得了使用不同内核的自由(PG 12-17),加装340个扩展的自由,扩容与伸缩Supabase/Postgres/MinIO的自由,免于数据库运维的自由,以及告别供应商锁定的自由。 而相比于使用 Supabase 云服务需要付出的代价,不过是准备一(几)台物理机/虚拟机 + 敲几行命令,等候十几分钟的区别。

单节点自建快速上手

让我们先从单节点 Supabase 部署开始,我们会在后面进一步介绍多节点高可用部署的方法。

首先,使用 Pigsty 标准安装流程 安装 Supabase 所需的 MinIO 与 PostgreSQL 实例;

然后额外运行 supabase.yml 完成剩余的工作,

拉起无状态部分的 Supabase 容器,Supabase 就可以使用了(默认端口 8000/8433)。

curl -fsSL https://repo.pigsty.io/get | bash

./bootstrap # 环境检查,自动安装依赖:Ansible

./configure -c supa # 重要:请在配置文件中修改密码等关键信息!

./install.yml # 安装 Pigsty,拉起 PGSQL 与 MINIO!

./supabase.yml # 安装 Docker 并拉起 Supabase 无状态部分!

请在部署 Supabase 前,根据您的实际情况,修改自动生成的 pigsty.yml 配置文件中的参数(主要是密码!)

如果您只是将其用于本地开发测试,可以先不管这些,我们将在后面介绍如何通过修改配置文件来定制您的 Supabase。

如果您的配置没有问题,那么大约在 10 分钟后,您就可以在本地网络通过 http://<your_ip_address>:8000 访问到 Supabase Studio 管理界面了。

检查清单

- 硬件/软件:准备所需的机器资源:Linux x86_64 服务器一台,全新安装主流 Linux 操作系统

- 网络/权限:有 ssh 免密登陆权限,所用用户有免密 sudo 权限

- 确保机器有内网静态IPv4网络地址,并可以访问互联网。中国地区 DockerHub 需要翻墙,需要有可用的代理或镜像站点

- 在

configure过程中,请输入节点的内网首要 IP 地址,或直接通过-i <primary_ip>命令行参数指定 - 如果您的网络环境无法访问 DockerHub,请指定

docker_registry_mirrors使用镜像站 或proxy_env参数翻墙。

- 在

- 确保使用了

supa配置模板,并按需修改了参数- 您是否修改了所有与密码有关的配置参数?【可选】

- 您是否需要使用外部 SMTP 服务器?是否配置了

supa_config中的 SMTP 参数?【可选】

中国地区的用户请注意,如果您没有配置好 Docker 镜像站点或代理服务器,那么会有极大概率会翻车在 ./supabase 最后一步的镜像拉取上。我们建议您掌握科学上网技巧,参考 Docker 模块 FAQ 的说明配置镜像或代理。 请注意,我们提供 Supabase 自建专门咨询服务,¥2000 / 例·半小时,购买附赠预制离线安装包,可以无需互联网(自然也无需翻墙)安装,将您的企业级自建 Supabase 安稳扶上马!

离线软件包使用说明:请在执行安装前,将收到的

pkg.tgz放置于/tmp/pkg.tgz,将supabase目录整个放置在/tmp/supabase即可。

修改后的配置文件,应该如下所示:

对默认生成的配置文件进行修改

all:

children:

# infra 集群,包含 Prometheus & Grafana 监控基础设施

infra: { hosts: { 10.10.10.10: { infra_seq: 1 } } }

# etcd 集群,本例为单节点 Etcd,用于提供 PG 高可用

etcd: { hosts: { 10.10.10.10: { etcd_seq: 1 } }, vars: { etcd_cluster: etcd } }

# minio 集群,单节点 SNSD 的 S3 兼容对象存储

minio: { hosts: { 10.10.10.10: { minio_seq: 1 } }, vars: { minio_cluster: minio } }

# pg-meta, Supabase 底层实际的 PostgreSQL 数据库

pg-meta:

hosts: { 10.10.10.10: { pg_seq: 1, pg_role: primary } }

vars:

pg_cluster: pg-meta

pg_users:

# supabase 使用的角色

- { name: anon ,login: false }

- { name: authenticated ,login: false }

- { name: dashboard_user ,login: false ,replication: true ,createdb: true ,createrole: true }

- { name: service_role ,login: false ,bypassrls: true }

# 【注意】如果你要修改 Supabase 业务用户的密码,请在这里统一修改所有用户的密码

- { name: supabase_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: true ,roles: [ dbrole_admin ] ,superuser: true ,replication: true ,createdb: true ,createrole: true ,bypassrls: true }

- { name: authenticator ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin, authenticated ,anon ,service_role ] }

- { name: supabase_auth_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin ] ,createrole: true }

- { name: supabase_storage_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin, authenticated ,anon ,service_role ] ,createrole: true }

- { name: supabase_functions_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin ] ,createrole: true }

- { name: supabase_replication_admin ,password: 'DBUser.Supa' ,replication: true ,roles: [ dbrole_admin ]}

- { name: supabase_read_only_user ,password: 'DBUser.Supa' ,bypassrls: true ,roles: [ dbrole_readonly, pg_read_all_data ] }

# 【注意】 这里定义了 Supabase 使用的底层 Postgres 业务数据库,

pg_databases:

- name: postgres

baseline: supabase.sql # 这里的 files/supabase.sql 文件包含了初始化 Supabase 所必需的模式迁移脚本,非常重要!

owner: supabase_admin # 这里的数据库所有者,必须是上面定义的 supabase_admin,我们建议使用此用户进行模式变更。

comment: supabase postgres database

schemas: [ extensions ,auth ,realtime ,storage ,graphql_public ,supabase_functions ,_analytics ,_realtime ]

extensions: # 定义在这里的扩展会默认在数据库中 “创建并启用”

- { name: pgcrypto ,schema: extensions } # 1.3

- { name: pg_net ,schema: extensions } # 0.9.2

- { name: pgjwt ,schema: extensions } # 0.2.0

- { name: uuid-ossp ,schema: extensions } # 1.1

- { name: pgsodium } # 3.1.9

- { name: supabase_vault } # 0.2.8

- { name: pg_graphql } # 1.5.9

- { name: pg_jsonschema } # 0.3.3

- { name: wrappers } # 0.4.3

- { name: http } # 1.6

- { name: pg_cron } # 1.6

- { name: timescaledb } # 2.17

- { name: pg_tle } # 1.2

- { name: vector } # 0.8.0

# 这些扩展默认需要动态加载

pg_libs: 'pg_stat_statements, plpgsql, plpgsql_check, pg_cron, pg_net, timescaledb, auto_explain, pg_tle, plan_filter'

# 如果你想安装其他扩展插件,请在这里指定,但请同样添加到下面的 repo_packages 中。

pg_extensions: # 在这里定义 “安装” 的扩展集合,安装后您可以按需手工 “启用/创建”

- supabase # Supabase 所必需的关键扩展集合,其他扩展为可选

- timescaledb postgis pg_graphql pg_jsonschema wrappers pg_search pg_analytics pg_parquet plv8 duckdb_fdw pg_cron pg_timetable pgqr

- supautils pg_plan_filter passwordcheck plpgsql_check pgaudit pgsodium pg_vault pgjwt pg_ecdsa pg_session_jwt index_advisor

- pgvector pgvectorscale pg_summarize pg_tiktoken pg_tle pg_stat_monitor hypopg pg_hint_plan pg_http pg_net pg_smtp_client pg_idkit

pg_parameters:

cron.database_name: postgres

pgsodium.enable_event_trigger: off

pg_hba_rules: # 额外的 HBA 规则,允许 Supabase 从容器网段访问

- { user: all ,db: postgres ,addr: intra ,auth: pwd ,title: 'allow supabase access from intranet' }

- { user: all ,db: postgres ,addr: 172.17.0.0/16 ,auth: pwd ,title: 'allow access from local docker network' }

pg_vip_enabled: true

pg_vip_address: 10.10.10.2/24

pg_vip_interface: eth1

# 这里定义的 Ansible 分组 supabase 包含了 Docker 与 Supabase 相关的配置,您可以使用 ./supabase.yml 剧本直接将其拉起

supabase:

hosts:

10.10.10.10: { supa_seq: 1 } # instance id

vars:

supa_cluster: supa

docker_enabled: true # 在 supabase 分组上启用 Docker,因为我们要用 Docker Compose 拉起无状态的部分

# 【注意】中国大陆地区的用户请指定 DockerHub 镜像站点或代理服务器,否则拉取镜像会失败

#docker_registry_mirrors: ['https://docker.xxxxx.io']

#proxy_env: # add [OPTIONAL] proxy env to /etc/docker/daemon.json configuration file

# no_proxy: "localhost,127.0.0.1,10.0.0.0/8,192.168.0.0/16,*.pigsty,*.aliyun.com,mirrors.*,*.myqcloud.com,*.tsinghua.edu.cn"

# all_proxy: http://user:pass@host:port

# 下面的 Supabase 配置项会自动覆盖或追加到 /opt/supabase/.env 文件中(模板路径:app/supabase/.env ,内容详见:https://github.com/Vonng/pigsty/blob/main/app/supabase/.env)

supa_config:

# 【非常重要】: 请修改下面的 JWT_SECRET 以及 ANON_KEY 与 SERVICE_ROLE_KEY : https://supabase.com/docs/guides/self-hosting/docker#securing-your-services

jwt_secret: your-super-secret-jwt-token-with-at-least-32-characters-long

anon_key: eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyAgCiAgICAicm9sZSI6ICJhbm9uIiwKICAgICJpc3MiOiAic3VwYWJhc2UtZGVtbyIsCiAgICAiaWF0IjogMTY0MTc2OTIwMCwKICAgICJleHAiOiAxNzk5NTM1NjAwCn0.dc_X5iR_VP_qT0zsiyj_I_OZ2T9FtRU2BBNWN8Bu4GE

service_role_key: eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyAgCiAgICAicm9sZSI6ICJzZXJ2aWNlX3JvbGUiLAogICAgImlzcyI6ICJzdXBhYmFzZS1kZW1vIiwKICAgICJpYXQiOiAxNjQxNzY5MjAwLAogICAgImV4cCI6IDE3OTk1MzU2MDAKfQ.DaYlNEoUrrEn2Ig7tqibS-PHK5vgusbcbo7X36XVt4Q

dashboard_username: supabase

dashboard_password: pigsty

#【注意】请在下面填入 PostgreSQL 链接串信息

postgres_host: 10.10.10.10

postgres_port: 5436 # 使用 5436 端口,通过 haproxy 始终访问主库

postgres_db: postgres

postgres_password: DBUser.Supa # 如果你在上面修改了 PostgreSQL 业务用户的密码,请一并修改这里的 PG 用户密码

# 如果您使用自定义域名,请修改下面的 domain 字段,将 supa.pigsty 替换为您自己的域名

site_url: http://supa.pigsty

api_external_url: http://supa.pigsty

supabase_public_url: http://supa.pigsty

#【可选】指定 S3/MinIO 对象存储的配置

s3_bucket: supa # Supabase 使用的 S3/MinIO 桶名称

s3_endpoint: https://sss.pigsty:9000 # 如果您使用负载均衡器访问 MinIO,或者使用外部 S3 服务,请修改这里的端点

s3_access_key: supabase # 对象存储 AK / 用户名

s3_secret_key: S3User.Supabase # 对象存储 SK / 密码

s3_force_path_style: true # MinIO 要求使用 PATH 样式的 URL

s3_protocol: https

s3_region: stub

minio_domain_ip: 10.10.10.10 # 因为 Docker 使用自己的静态域名解析记录,所以你需要将内部 MinIO 域名 sss.pigsty 解析指向任意安装 MinIO 的节点地址

#【可选】 指定 SMTP 服务器发送邮件

#smtp_admin_email: [email protected]

#smtp_host: supabase-mail

#smtp_port: 2500

#smtp_user: fake_mail_user

#smtp_pass: fake_mail_password

#smtp_sender_name: fake_sender

#enable_anonymous_users: false

#==============================================================#

# Global Parameters

#==============================================================#

vars:

version: v3.1.0 # pigsty version string

admin_ip: 10.10.10.10 # admin node ip address

region: default # upstream mirror region: default|china|europe

node_tune: oltp # node tuning specs: oltp,olap,tiny,crit

pg_conf: oltp.yml # pgsql tuning specs: {oltp,olap,tiny,crit}.yml

infra_portal: # domain names and upstream servers

home : { domain: h.pigsty }

grafana : { domain: g.pigsty ,endpoint: "${admin_ip}:3000" , websocket: true }

prometheus : { domain: p.pigsty ,endpoint: "${admin_ip}:9090" }

alertmanager : { domain: a.pigsty ,endpoint: "${admin_ip}:9093" }

minio : { domain: m.pigsty ,endpoint: "10.10.10.10:9001", https: true, websocket: true }

blackbox : { endpoint: "${admin_ip}:9115" }

loki : { endpoint: "${admin_ip}:3100" } # expose supa studio UI and API via nginx

#【注意】如果您使用公网域名,那么请修改下面的 domain 字段,将 supa.pigsty 替换为您自己的域名,您可以用 key / cert 指定自己的 HTTPS 证书路径

supa : { domain: supa.pigsty ,endpoint: "10.10.10.10:8000", websocket: true }

#----------------------------------#

# 【非常重要】请修改这些密码!!

#----------------------------------#

#grafana_admin_username: admin

grafana_admin_password: pigsty

#pg_admin_username: dbuser_dba

pg_admin_password: DBUser.DBA

#pg_monitor_username: dbuser_monitor

pg_monitor_password: DBUser.Monitor

#pg_replication_username: replicator

pg_replication_password: DBUser.Replicator

#patroni_username: postgres

patroni_password: Patroni.API

#haproxy_admin_username: admin

haproxy_admin_password: pigsty

# 【MINIO】 相关参数

minio_access_key: minioadmin #【注意】 MinIO 的根用户名,默认为:`minioadmin`

minio_secret_key: minioadmin #【注意】 MinIO 的根用户密码,默认为:`minioadmin`

minio_buckets: [ { name: pgsql }, { name: supa } ] #【注意】 Pigsty 默认使用本地 MinIO 上的 pgsql 桶存放PG备份,supa 桶作为对象存储

minio_users: #【注意】 这是 MinIO 上创建的用户列表,默认创建三个业务用户

- { access_key: dba , secret_key: S3User.DBA, policy: consoleAdmin } #【注意】 这是默认的业务管理员用户,目前由用户自行使用,请修改这里的密码!

- { access_key: pgbackrest , secret_key: S3User.Backup, policy: readwrite } #【注意】 PGSQL 使用 MinIO 的用户,如果修改这里的密码,请相应调整 pgbackrest_repo 中的密码

- { access_key: supabase , secret_key: S3User.Supabase, policy: readwrite } #【注意】 SUPABASE 使用 MinIO 的用户,如果修改这里的密码,请相应调整 supabase 配置文件中的密码

minio_endpoint: https://sss.pigsty:9000 #【信息】 如果你使用负载均衡器访问 MinIO,才需要修改这里的端口

node_etc_hosts: ["10.10.10.10 sss.pigsty"] #【信息】 将 MinIO 默认域名 sss.pigsty 指向任意安装 MinIO 节点的地址

# PostgreSQL 备份存储仓库,如果你希望将备份存储到对象存储中,请修改这两个参数

pgbackrest_method: minio # pgbackrest 备份方法:local,minio,[其他用户定义的仓库...],本例中将备份存储到 MinIO 上

pgbackrest_repo: # pgbackrest 备份仓库: https://pgbackrest.org/configuration.html#section-repository

local: # 默认的备份仓库是本地文件系统,但本例中我们【不用】这种方式

path: /pg/backup # 本地备份目录 `/pg/backup` (你可以修改 pg_fs_bkup 来修改实际备份盘位置而无需修改这里)

retention_full_type: count # 保留 N 个全量备份

retention_full: 2 # N = 2

#【非常重要】 Pigsty 这里使用 MinIO 存储备份,请在这里根据上面 MinIO 的配置情况进行相应修改

minio: #

type: s3 #

s3_endpoint: sss.pigsty # 【重要】 如果你上面修改了 MinIO pgBackRest 备份用户的密码,那么这里也需要修改!

s3_region: us-east-1 #

s3_bucket: pgsql #

s3_key: pgbackrest #

s3_key_secret: S3User.Backup # 【重要】 如果你上面修改了 MinIO pgBackRest 备份用户的密码,那么这里也需要修改!

s3_uri_style: path #

path: /pgbackrest #

storage_port: 9000 #

storage_ca_file: /pg/cert/ca.crt # 对象存储使用的 CA 文件(如果您的对象存储使用的是自签名 CA 证书)

bundle: y # 将小文件合并打包以减少碎片,提高上传效率

cipher_type: aes-256-cbc # 使用 AES-256-CBC 加密备份,如果您使用远程对象存储放备份,加密是合规建议项

cipher_pass: pgBackRest # 【重要】备份 AES 加密密码,我们建议修改这个密码,否则加密无意义

retention_full_type: time # 保留 一段时间 内的全量备份

retention_full: 14 # 一段时间 = 14 天

#【注意】如果你想使用其他 PG 大版本运行 Supabase,修改此变量,建议使用 15-17

pg_version: 17

repo_modules: node,pgsql,infra,docker

repo_packages: [node-bootstrap, infra-package, infra-addons, node-package1, node-package2, pgsql-utility, docker ]

# 【注意】如果你想安装其他扩展插件,请在这里添加到下载列表中

repo_extra_packages:

- pgsql-main

- supabase # supabase 别名包含了所有必须的扩展,下面则是一些可选的额外扩展插件

- timescaledb postgis pg_graphql pg_jsonschema wrappers pg_search pg_analytics pg_parquet plv8 duckdb_fdw pg_cron pg_timetable pgqr

- supautils pg_plan_filter passwordcheck plpgsql_check pgaudit pgsodium pg_vault pgjwt pg_ecdsa pg_session_jwt index_advisor

- pgvector pgvectorscale pg_summarize pg_tiktoken pg_tle pg_stat_monitor hypopg pg_hint_plan pg_http pg_net pg_smtp_client pg_idkit

...

自建关键技术决策

以下是一些自建 Supabase 会涉及到的关键技术决策,供您参考:

使用默认的单节点部署 Supabase 无法享受到 PostgreSQL / MinIO 的高可用能力。 尽管如此,单节点部署相比官方纯 Docker Compose 方案依然要有显著优势: 例如开箱即用的监控系统,自由安装扩展的能力,各个组件的扩缩容能力,以及数据库时间点恢复能力等。

如果您只有一台服务器,Pigsty 建议您直接使用外部的 S3 作为对象存储,存放 PostgreSQL 的备份,并承载 Supabase Storage 服务。 这样的部署在故障时可以提供一个最低标准的 RTO (小时级恢复时长)/ RPO (MB级数据损失)兜底容灾水平。 此外,如果您选择在云上自建,我们也建议您直接使用 S3,而非默认使用的本体 MinIO ,单纯在本地 EBS 上再套一层 MinIO 转发,除了便于开发测试外,对生产实用并没有意义。

在严肃的生产部署中,Pigsty 建议使用至少3~4个节点的部署策略,确保 MinIO 与 PostgreSQL 都使用满足企业级高可用要求的多节点部署。

在这种情况下,您需要相应准备更多节点与磁盘,并相应调整 pigsty.yml 配置清单中的集群配置,以及 supabase 集群配置中的接入信息。

部分 Supabase 的功能需要发送邮件,所以要用到 SMTP。除非单纯用于内网,否则对于严肃的生产部署,我们建议您考虑使用外部的 SMTP 服务。 自建的邮件服务器发送的邮件可能会被对方邮件服务器拒收,或者被标记为垃圾邮件。

如果您的服务直接向公网暴露,我们建议您使用 Nginx 进行反向代理,使用真正的域名与 HTTPS 证书,并通过不同的域名区分不同的多个实例。

接下来,我们会依次讨论这几个主题:

- 进阶主题:安全加固

- 高可用的 PostgreSQL 集群部署与接入

- 高可用的 MinIO 集群部署与接入

- 使用 S3 服务替代 MinIO

- 使用外部 SMTP 服务发送邮件

- 使用真实域名,证书,通过 Nginx 反向代理

进阶主题:安全加固

Pigsty基础组件

对于严肃的生产部署,我们强烈建议您修改 Pigsty 基础组件的密码。因为这些默认值是公开且众所周知的,不改密码上生产无异于裸奔:

grafana_admin_password:pigsty,Grafana管理员密码pg_admin_password:DBUser.DBA,PG超级用户密码pg_monitor_password:DBUser.Monitor,PG监控用户密码pg_replication_password:DBUser.Replicator,PG复制用户密码patroni_password:Patroni.API,Patroni 高可用组件密码haproxy_admin_password:pigsty,负载均衡器管控密码minio_access_key:minioadmin,MinIO 根用户名minio_secret_key:minioadmin,MinIO 根用户密钥- 此外,强烈建议您修改 Supabase 使用的 PostgreSQL 业务用户 密码,默认为

DBUser.Supa

以上密码为 Pigsty 组件模块的密码,强烈建议在安装部署前就设置完毕。

Supabase密钥

除了 Pigsty 组件的密码,你还需要 修改 Supabase 的密钥,包括

jwt_secret:anon_key:service_role_key:dashboard_username: Supabase Studio Web 界面的默认用户名,默认为supabasedashboard_password: Supabase Studio Web 界面的默认密码,默认为pigsty

这里请您务必参照 Supabase教程:保护你的服务 里的说明:

- 生成一个长度超过 40 个字符的

jwt_secret,并使用教程中的工具签发anon_key与service_role_key两个 JWT。 - 使用教程中提供的工具,根据

jwt_secret以及过期时间等属性,生成一个anon_keyJWT,这是匿名用户的身份凭据。 - 使用教程中提供的工具,根据

jwt_secret以及过期时间等属性,生成一个service_role_key,这是权限更高服务角色的身份凭据。 - 如果您使用的 PostgreSQL 业务用户使用了不同于默认值的密码,请相应修改 `postgres_password`` 的值

- 如果您的对象存储使用了不同于默认值的密码,请相应修改

s3_access_key``](https://github.com/Vonng/pigsty/blob/main/conf/supa.yml#136) 与 [s3_secret_key`` 的值

Supabase 部分的凭据修改后,您可以重启 Docker Compose 容器以应用新的配置:

cd /opt/supabase; docker compose up

进阶主题:域名接入

如果你在本机或局域网内使用 Supabase,那么可以选择 IP:Port 直连 Kong 对外暴露的 HTTP 8000 端口,当然这样并不好,我们建议您使用域名与 HTTPS 来访问。

使用默认的本地域名 supa.pigsty 时,您可以在浏览器本机的 /etc/hosts 或局域网 DNS 里来配置它的解析,将其指向安装节点的【对外】IP地址。

Pigsty 管理节点上的 Nginx 会为此域名申请自签名的证书(浏览器显示《不安全》),并将请求转发到 8000 端口的 Kong,由 Supabase 处理。

不过,更为实用与常见的用例是:Supabase 通过公网队外提供服务。在这种情况下,通常您需要进行以下准备:

- 您的服务器应当有一个公网 IP 地址

- 购买域名,使用 云/DNS/CDN 供应商提供的 DNS 解析服务,将其指向安装节点的公网 IP(下位替代:本地

/etc/hosts) - 申请证书,使用 Let’s Encrypt 等证书颁发机构签发的免费 HTTPS 证书,用于加密通信(下位替代:默认自签名证书,手工信任)

准备完成后,请修改 pigsty.yml 配置文件中 all.vars.infra_portal 部分的 supa 域名,以及 all.children.supabase.vars.supa_config 中的三个域名字段。

这里我们假设您使用的自定义域名是: supa.pigsty.cc

all:

vars: # 全局配置

#.....

infra_portal: # domain names and upstream servers

home : { domain: h.pigsty }

grafana : { domain: g.pigsty ,endpoint: "${admin_ip}:3000" , websocket: true }

prometheus : { domain: p.pigsty ,endpoint: "${admin_ip}:9090" }

alertmanager : { domain: a.pigsty ,endpoint: "${admin_ip}:9093" }

minio : { domain: m.pigsty ,endpoint: "10.10.10.10:9001", https: true, websocket: true }

blackbox : { endpoint: "${admin_ip}:9115" }

loki : { endpoint: "${admin_ip}:3100" }

#supa : { domain: supa.pigsty ,endpoint: "10.10.10.10:8000", websocket: true } # 如果使用申请的 HTTPS 证书,请在这里指定证书的存放路径

supa : { domain: supa.pigsty.cc ,endpoint: "10.10.10.10:8000", websocket: true ,cert: /etc/cert/suap.pigsty.cc.crt ,key: /etc/cert/supa.pigsty.cc.key }

children: # 集群定义

supabase: # supabase 分组

vars: # supabase 分组集群配置

supa_config: # supabase 配置项

# 请在这里更新 Supabase 使用的域名

site_url: http://supa.pigsty

api_external_url: http://supa.pigsty

supabase_public_url: http://supa.pigsty

申请 HTTPS 证书超出了本文范畴,请您自行用 acmebot 之类的工具处理,将申请好的证书放置于指定位置即可。

./infra.yml -t nginx_config,nginx_launch

./supabase.yml -t supa_config,supa_launch

使用以上命令重新加载 Nginx 和 Supabase 的配置。

进阶主题:外部对象存储

您可以使用 S3 或 S3 兼容的服务,来作为 PGSQL 备份与 Supabase 使用的对象存储。这里我们使用一个 阿里云 OSS 对象存储作为例子。

Pigsty 提供了一个

terraform/spec/aliyun-meta-s3.tf模板,用于在阿里云上拉起一台服务器,以及一个 OSS 存储桶。

首先,我们修改 all.children.supabase.vars.supa_config 中 S3 相关的配置,将其指向阿里云 OSS 存储桶:

all:

children:

supabase:

vars:

supa_config:

s3_bucket: pigsty-oss

s3_endpoint: https://oss-cn-beijing-internal.aliyuncs.com

s3_access_key: xxxxxxxxxxxxxxxx

s3_secret_key: xxxxxxxxxxxxxxxx

s3_force_path_style: false

s3_protocol: https

s3_region: oss-cn-beijing

同样使用以下命令重载 Supabase 配置:

./supabase.yml -t supa_config,supa_launch

您同样可以使用 S3 作为 PostgreSQL 的备份仓库,在 all.vars.pgbackrest_repo 新增一个 aliyun 备份仓库的定义:

all:

vars:

pgbackrest_method: aliyun # pgbackrest 备份方法:local,minio,[其他用户定义的仓库...],本例中将备份存储到 MinIO 上

pgbackrest_repo: # pgbackrest 备份仓库: https://pgbackrest.org/configuration.html#section-repository

aliyun: # 定义一个新的备份仓库 aliyun

type: s3 # 阿里云 oss 是 s3-兼容的对象存储

s3_endpoint: oss-cn-beijing-internal.aliyuncs.com

s3_region: oss-cn-beijing

s3_bucket: pigsty-oss

s3_key: xxxxxxxxxxxxxx

s3_key_secret: xxxxxxxx

s3_uri_style: host

path: /pgbackrest

bundle: y

cipher_type: aes-256-cbc

cipher_pass: PG.${pg_cluster} # 设置一个与集群名称绑定的加密密码

retention_full_type: time

retention_full: 14

然后在 all.vars.pgbackrest_mehod 中指定使用 aliyun 备份仓库,重置 pgBackrest 备份:

./pgsql.yml -t pgbackrest

Pigsty 会将备份仓库切换到外部对象存储上。

进阶主题:备份策略

你可以使用操作系统的 Crontab 来设置定时备份策略,例如,向默认的 all.children.pg-meta.vars 中添加 node_crontab 参数:

all:

children:

pg-meta:

hosts: { 10.10.10.10: { pg_seq: 1, pg_role: primary } }

vars:

pg_cluster: pg-meta # 每天凌晨一点做个全量备份

node_crontab: [ '00 01 * * * postgres /pg/bin/pg-backup full' ]

然后执行以下命令,将 Crontab 配置应用到节点上:

./node.yml -t node_crontab

更多关于备份策略的主题,请参考 备份策略

进阶主题:使用SMTP

你可以使用 SMTP 来发送邮件,修改 supabase 配置,添加 SMTP 信息:

all:

children:

supabase:

vars:

supa_config:

smtp_host: smtpdm.aliyun.com:80

smtp_port: 80

smtp_user: [email protected]

smtp_pass: your_email_user_password

smtp_sender_name: MySupabase

smtp_admin_email: [email protected]

enable_anonymous_users: false

不要忘了使用 supabase.yml -t supa_config,supa_launch 来重载配置

进阶主题:真·高可用

经过上面的配置,您已经可以使用一个带有公网域名,HTTPS 证书,SMTP 邮件服务器,备份的 Supabase 了。

如果您的这个节点挂了,起码外部 S3 存储中保留了备份,您可以在新的节点上重新部署 Supabase,然后从备份中恢复。 这样的部署在故障时可以提供一个最低标准的 RTO (小时级恢复时长)/ RPO (MB级数据损失)兜底容灾水平 兜底。

但如果您想要达到 RTO < 30s ,零数据丢失,那么就需要用到多节点高可用集群了。多节点部署有三个维度:

- ETCD: DCS 需要使用三个节点或以上,才能容忍一个节点的故障。

- PGSQL: PGSQL 同步提交不丢数据模式,建议使用至少三个节点。

- INFRA:监控基础设施故障影响稍小,但我们建议生产环境使用三副本

- Supabase 本身也可以是多节点的副本,实现高可用

我们建议您参考 trio 与 safe 中的集群配置,将您的集群配置升级到三节点或以上。

在这种情况下,您还需要修改 PostgreSQL 与 MinIO 的接入点,使用 DNS / L2 VIP / HAProxy 等 高可用接入点

例如,假设您使用 L2 VIP 接入 MinIO 集群与 PostgreSQL 集群,那么就需要相应修改配置:

all:

children:

supabase:

hosts:

10.10.10.10: { supa_seq: 1 }

10.10.10.11: { supa_seq: 2 }

10.10.10.12: { supa_seq: 3 }

vars:

supa_cluster: supa # cluster name

supa_config:

postgres_host: 10.10.10.2 # 例如,使用 PG 集群上的 L2 VIP 接入服务

postgres_port: 5436 # 使用 5436 端口,始终直连主库,也可以使用 5433,通过连接池访问主库

s3_endpoint: https://sss.pigsty:9002 # 假如您的负载均衡器使用了 9002 端口,那么请更改这里的 Endpoint

minio_domain_ip: 10.10.10.3 # 修改此参数,将 sss.pigsty 的域名指向挂载在 MinIO 集群前面的 L2 VIP

应用 Supabase 的配置后,您可能还需要在 Supabase 集群前套上一个负载均衡器,用于将请求分发到后端的多个节点上。

以下是一个三节点的 高可用 Supabase 自建的参考配置文件:

3-Node HA Supabase Config Template

all:

#==============================================================#

# Clusters, Nodes, and Modules

#==============================================================#

children:

# infra cluster for proxy, monitor, alert, etc..

infra:

hosts:

10.10.10.10: { infra_seq: 1 ,nodename: infra-1 }

10.10.10.11: { infra_seq: 2 ,nodename: infra-2, repo_enabled: false, grafana_enabled: false }

10.10.10.12: { infra_seq: 3 ,nodename: infra-3, repo_enabled: false, grafana_enabled: false }

vars:

vip_enabled: true

vip_vrid: 128

vip_address: 10.10.10.3

vip_interface: eth1

haproxy_services:

- name: minio # [REQUIRED] service name, unique

port: 9002 # [REQUIRED] service port, unique

balance: leastconn # [OPTIONAL] load balancer algorithm

options: # [OPTIONAL] minio health check

- option httpchk

- option http-keep-alive

- http-check send meth OPTIONS uri /minio/health/live

- http-check expect status 200

servers:

- { name: minio-1 ,ip: 10.10.10.10 ,port: 9000 ,options: 'check-ssl ca-file /etc/pki/ca.crt check port 9000' }

- { name: minio-2 ,ip: 10.10.10.11 ,port: 9000 ,options: 'check-ssl ca-file /etc/pki/ca.crt check port 9000' }

- { name: minio-3 ,ip: 10.10.10.12 ,port: 9000 ,options: 'check-ssl ca-file /etc/pki/ca.crt check port 9000' }

etcd: # dcs service for postgres/patroni ha consensus

hosts: # 1 node for testing, 3 or 5 for production

10.10.10.10: { etcd_seq: 1 } # etcd_seq required

10.10.10.11: { etcd_seq: 2 } # assign from 1 ~ n

10.10.10.12: { etcd_seq: 3 } # odd number please

vars: # cluster level parameter override roles/etcd

etcd_cluster: etcd # mark etcd cluster name etcd

etcd_safeguard: false # safeguard against purging

etcd_clean: true # purge etcd during init process

# minio cluster 4-node

minio:

hosts:

10.10.10.10: { minio_seq: 1 , nodename: minio-1 }

10.10.10.11: { minio_seq: 2 , nodename: minio-2 }

10.10.10.12: { minio_seq: 3 , nodename: minio-3 }

vars:

minio_cluster: minio

minio_data: '/data{1...4}'

minio_buckets: [ { name: pgsql }, { name: supa } ]

minio_users:

- { access_key: dba , secret_key: S3User.DBA, policy: consoleAdmin }

- { access_key: pgbackrest , secret_key: S3User.Backup, policy: readwrite }

- { access_key: supabase , secret_key: S3User.Supabase, policy: readwrite }

# pg-meta, the underlying postgres database for supabase

pg-meta:

hosts:

10.10.10.10: { pg_seq: 1, pg_role: primary }

10.10.10.11: { pg_seq: 2, pg_role: replica }

10.10.10.12: { pg_seq: 3, pg_role: replica }

vars:

pg_cluster: pg-meta

pg_users:

# supabase roles: anon, authenticated, dashboard_user

- { name: anon ,login: false }

- { name: authenticated ,login: false }

- { name: dashboard_user ,login: false ,replication: true ,createdb: true ,createrole: true }

- { name: service_role ,login: false ,bypassrls: true }

# supabase users: please use the same password

- { name: supabase_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: true ,roles: [ dbrole_admin ] ,superuser: true ,replication: true ,createdb: true ,createrole: true ,bypassrls: true }

- { name: authenticator ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin, authenticated ,anon ,service_role ] }

- { name: supabase_auth_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin ] ,createrole: true }

- { name: supabase_storage_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin, authenticated ,anon ,service_role ] ,createrole: true }

- { name: supabase_functions_admin ,password: 'DBUser.Supa' ,pgbouncer: true ,inherit: false ,roles: [ dbrole_admin ] ,createrole: true }

- { name: supabase_replication_admin ,password: 'DBUser.Supa' ,replication: true ,roles: [ dbrole_admin ]}

- { name: supabase_read_only_user ,password: 'DBUser.Supa' ,bypassrls: true ,roles: [ dbrole_readonly, pg_read_all_data ] }

pg_databases:

- name: postgres

baseline: supabase.sql

owner: supabase_admin

comment: supabase postgres database

schemas: [ extensions ,auth ,realtime ,storage ,graphql_public ,supabase_functions ,_analytics ,_realtime ]

extensions:

- { name: pgcrypto ,schema: extensions } # 1.3 : cryptographic functions

- { name: pg_net ,schema: extensions } # 0.9.2 : async HTTP

- { name: pgjwt ,schema: extensions } # 0.2.0 : json web token API for postgres

- { name: uuid-ossp ,schema: extensions } # 1.1 : generate universally unique identifiers (UUIDs)

- { name: pgsodium } # 3.1.9 : pgsodium is a modern cryptography library for Postgres.

- { name: supabase_vault } # 0.2.8 : Supabase Vault Extension

- { name: pg_graphql } # 1.5.9 : pg_graphql: GraphQL support

- { name: pg_jsonschema } # 0.3.3 : pg_jsonschema: Validate json schema

- { name: wrappers } # 0.4.3 : wrappers: FDW collections

- { name: http } # 1.6 : http: allows web page retrieval inside the database.

- { name: pg_cron } # 1.6 : pg_cron: Job scheduler for PostgreSQL

- { name: timescaledb } # 2.17 : timescaledb: Enables scalable inserts and complex queries for time-series data

- { name: pg_tle } # 1.2 : pg_tle: Trusted Language Extensions for PostgreSQL

- { name: vector } # 0.8.0 : pgvector: the vector similarity search

# supabase required extensions

pg_libs: 'pg_stat_statements, plpgsql, plpgsql_check, pg_cron, pg_net, timescaledb, auto_explain, pg_tle, plan_filter'

pg_extensions: # extensions to be installed on this cluster

- supabase # essential extensions for supabase

- timescaledb postgis pg_graphql pg_jsonschema wrappers pg_search pg_analytics pg_parquet plv8 duckdb_fdw pg_cron pg_timetable pgqr

- supautils pg_plan_filter passwordcheck plpgsql_check pgaudit pgsodium pg_vault pgjwt pg_ecdsa pg_session_jwt index_advisor

- pgvector pgvectorscale pg_summarize pg_tiktoken pg_tle pg_stat_monitor hypopg pg_hint_plan pg_http pg_net pg_smtp_client pg_idkit

pg_parameters:

cron.database_name: postgres

pgsodium.enable_event_trigger: off

pg_hba_rules: # supabase hba rules, require access from docker network

- { user: all ,db: postgres ,addr: intra ,auth: pwd ,title: 'allow supabase access from intranet' }

- { user: all ,db: postgres ,addr: 172.17.0.0/16 ,auth: pwd ,title: 'allow access from local docker network' }

pg_vip_enabled: true

pg_vip_address: 10.10.10.2/24

pg_vip_interface: eth1

node_crontab: [ '00 01 * * * postgres /pg/bin/pg-backup full' ] # make a full backup every 1am

# launch supabase stateless part with docker compose: ./supabase.yml

supabase:

hosts:

10.10.10.10: { supa_seq: 1 } # instance 1

10.10.10.11: { supa_seq: 2 } # instance 2

10.10.10.12: { supa_seq: 3 } # instance 3

vars:

supa_cluster: supa # cluster name

docker_enabled: true # enable docker

# use these to pull docker images via proxy and mirror registries

#docker_registry_mirrors: ['https://docker.xxxxx.io']

#proxy_env: # add [OPTIONAL] proxy env to /etc/docker/daemon.json configuration file

# no_proxy: "localhost,127.0.0.1,10.0.0.0/8,192.168.0.0/16,*.pigsty,*.aliyun.com,mirrors.*,*.myqcloud.com,*.tsinghua.edu.cn"

# #all_proxy: http://user:pass@host:port

# these configuration entries will OVERWRITE or APPEND to /opt/supabase/.env file (src template: app/supabase/.env)

# check https://github.com/Vonng/pigsty/blob/main/app/supabase/.env for default values

supa_config:

# IMPORTANT: CHANGE JWT_SECRET AND REGENERATE CREDENTIAL ACCORDING!!!!!!!!!!!

# https://supabase.com/docs/guides/self-hosting/docker#securing-your-services

jwt_secret: your-super-secret-jwt-token-with-at-least-32-characters-long

anon_key: eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyAgCiAgICAicm9sZSI6ICJhbm9uIiwKICAgICJpc3MiOiAic3VwYWJhc2UtZGVtbyIsCiAgICAiaWF0IjogMTY0MTc2OTIwMCwKICAgICJleHAiOiAxNzk5NTM1NjAwCn0.dc_X5iR_VP_qT0zsiyj_I_OZ2T9FtRU2BBNWN8Bu4GE

service_role_key: eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyAgCiAgICAicm9sZSI6ICJzZXJ2aWNlX3JvbGUiLAogICAgImlzcyI6ICJzdXBhYmFzZS1kZW1vIiwKICAgICJpYXQiOiAxNjQxNzY5MjAwLAogICAgImV4cCI6IDE3OTk1MzU2MDAKfQ.DaYlNEoUrrEn2Ig7tqibS-PHK5vgusbcbo7X36XVt4Q

dashboard_username: supabase

dashboard_password: pigsty

# postgres connection string (use the correct ip and port)

postgres_host: 10.10.10.3 # use the pg_vip_address rather than single node ip

postgres_port: 5433 # access via the 'default' service, which always route to the primary postgres

postgres_db: postgres

postgres_password: DBUser.Supa # password for supabase_admin and multiple supabase users

# expose supabase via domain name

site_url: http://supa.pigsty

api_external_url: http://supa.pigsty

supabase_public_url: http://supa.pigsty

# if using s3/minio as file storage

s3_bucket: supa

s3_endpoint: https://sss.pigsty:9002

s3_access_key: supabase

s3_secret_key: S3User.Supabase

s3_force_path_style: true

s3_protocol: https

s3_region: stub

minio_domain_ip: 10.10.10.3 # sss.pigsty domain name will resolve to this l2 vip that bind to all nodes

# if using SMTP (optional)

#smtp_admin_email: [email protected]

#smtp_host: supabase-mail

#smtp_port: 2500

#smtp_user: fake_mail_user

#smtp_pass: fake_mail_password

#smtp_sender_name: fake_sender

#enable_anonymous_users: false

#==============================================================#

# Global Parameters

#==============================================================#

vars:

version: v3.1.0 # pigsty version string

admin_ip: 10.10.10.10 # admin node ip address

region: china # upstream mirror region: default|china|europe

node_tune: oltp # node tuning specs: oltp,olap,tiny,crit

pg_conf: oltp.yml # pgsql tuning specs: {oltp,olap,tiny,crit}.yml

infra_portal: # domain names and upstream servers

home : { domain: h.pigsty }

grafana : { domain: g.pigsty ,endpoint: "${admin_ip}:3000" , websocket: true }

prometheus : { domain: p.pigsty ,endpoint: "${admin_ip}:9090" }

alertmanager : { domain: a.pigsty ,endpoint: "${admin_ip}:9093" }

minio : { domain: m.pigsty ,endpoint: "10.10.10.10:9001", https: true, websocket: true }

blackbox : { endpoint: "${admin_ip}:9115" }

loki : { endpoint: "${admin_ip}:3100" } # expose supa studio UI and API via nginx

supa : { domain: supa.pigsty ,endpoint: "10.10.10.10:8000", websocket: true }

#----------------------------------#

# Credential: CHANGE THESE PASSWORDS

#----------------------------------#

#grafana_admin_username: admin

grafana_admin_password: pigsty

#pg_admin_username: dbuser_dba

pg_admin_password: DBUser.DBA

#pg_monitor_username: dbuser_monitor

pg_monitor_password: DBUser.Monitor

#pg_replication_username: replicator

pg_replication_password: DBUser.Replicator

#patroni_username: postgres

patroni_password: Patroni.API

#haproxy_admin_username: admin

haproxy_admin_password: pigsty

# use minio as supabase file storage, single node single driver mode for demonstration purpose

minio_access_key: minioadmin # root access key, `minioadmin` by default

minio_secret_key: minioadmin # root secret key, `minioadmin` by default

minio_buckets: [ { name: pgsql }, { name: supa } ]

minio_users:

- { access_key: dba , secret_key: S3User.DBA, policy: consoleAdmin }

- { access_key: pgbackrest , secret_key: S3User.Backup, policy: readwrite }

- { access_key: supabase , secret_key: S3User.Supabase, policy: readwrite }

minio_endpoint: https://sss.pigsty:9000 # explicit overwrite minio endpoint with haproxy port

node_etc_hosts: ["10.10.10.3 sss.pigsty"] # domain name to access minio from all nodes (required)

# use minio as default backup repo for PostgreSQL

pgbackrest_method: minio # pgbackrest repo method: local,minio,[user-defined...]

pgbackrest_repo: # pgbackrest repo: https://pgbackrest.org/configuration.html#section-repository

local: # default pgbackrest repo with local posix fs

path: /pg/backup # local backup directory, `/pg/backup` by default

retention_full_type: count # retention full backups by count

retention_full: 2 # keep 2, at most 3 full backup when using local fs repo

minio: # optional minio repo for pgbackrest

type: s3 # minio is s3-compatible, so s3 is used

s3_endpoint: sss.pigsty # minio endpoint domain name, `sss.pigsty` by default

s3_region: us-east-1 # minio region, us-east-1 by default, useless for minio

s3_bucket: pgsql # minio bucket name, `pgsql` by default

s3_key: pgbackrest # minio user access key for pgbackrest

s3_key_secret: S3User.Backup # minio user secret key for pgbackrest

s3_uri_style: path # use path style uri for minio rather than host style

path: /pgbackrest # minio backup path, default is `/pgbackrest`

storage_port: 9002 # minio port, 9000 by default

storage_ca_file: /pg/cert/ca.crt # minio ca file path, `/pg/cert/ca.crt` by default

bundle: y # bundle small files into a single file

cipher_type: aes-256-cbc # enable AES encryption for remote backup repo

cipher_pass: pgBackRest # AES encryption password, default is 'pgBackRest'

retention_full_type: time # retention full backup by time on minio repo

retention_full: 14 # keep full backup for last 14 days

# download docker and supabase related extensions

pg_version: 17

repo_modules: node,pgsql,infra,docker

repo_packages: [node-bootstrap, infra-package, infra-addons, node-package1, node-package2, pgsql-utility, docker ]

repo_extra_packages:

- pgsql-main

- supabase # essential extensions for supabase

- timescaledb postgis pg_graphql pg_jsonschema wrappers pg_search pg_analytics pg_parquet plv8 duckdb_fdw pg_cron pg_timetable pgqr

- supautils pg_plan_filter passwordcheck plpgsql_check pgaudit pgsodium pg_vault pgjwt pg_ecdsa pg_session_jwt index_advisor

- pgvector pgvectorscale pg_summarize pg_tiktoken pg_tle pg_stat_monitor hypopg pg_hint_plan pg_http pg_net pg_smtp_client pg_idkit

面向未来数据库的现代硬件

作者:Alex Miller 2024-11-19 @ Snowflake, Apple, Google

译者:冯若航 & GPT o1,PG 大法师,数据库老司机,云计算泥石流

译者推荐:本文是一篇关于硬件发展如何影响数据库设计的综述,分别介绍了在网络,存储,计算三个领域的关键硬件进展。我一直都认为,充分利用好新硬件(而非折腾所谓分布式)才是数据库内核发展的正路。 请看《重新拿回计算机硬件的红利》与《分布式数据库是伪需求吗》。 而这篇文章很好地介绍了一些数据库领域的前沿软硬件结合实践,值得一读。

原文:Modern Hardware for Future Databases

我们正处于一个令人兴奋的数据库时代,每个主要资源领域都在不断进步,每一项进步都有可能影响最优的数据库架构。总的来说,我希望在未来十年内,能看到数据库架构发生一些有趣的转变,但我不确定是否能有必要的硬件支持。

网络

根据 Stonebraker 在 HPTS 2024 的演讲,使用 VoltDB 的一些基准测试发现,其服务器端大约 60% 的 CPU 时间花在了 TCP/IP 协议栈上。VoltDB 本身就是一种旨在尽可能消除非查询处理工作以服务请求的数据库架构,所以这是一个极端的例子。然而,这仍然有效地指出了 TCP 的计算开销并不小,且随着网络带宽的增加,这一问题会变得更加明显。尽管这并不是新的观察结果,但已有一系列逐步升级的解决方案被提出。

一种被提议的解决方案是用另一种基于 UDP 的协议替换 TCP,QUIC 就是一个常被选择的例子。然而,这种想法存在误区。“虽然这是一个严重不准确的简化,但在最简单的层面上,QUIC 只是将 TCP 封装并加密在 UDP 负载中。” TCP 和 QUIC 的 CPU 开销也非常相似。要想实现显著的改进,需要进一步偏离 TCP 并针对特定环境进行专门化,例如 Homa 这样的论文展示了在数据中心环境中的一些改进。但即使有了更好的协议,更大的优化潜力还是在于减少内核网络栈的开销。

注释:如果你在阅读时想知道为什么这里提到了 QUIC,那是因为我多次参与了关于 TCP 或 TLS 被指责为某些问题的讨论,而迁移到 QUIC 被建议为解决方案。QUIC 确实能帮助解决一些问题,但也有一些问题它并不能改善,甚至可能使其更糟。需要理解的是,在稳定状态下的延迟和带宽属于后者。

一种减少内核工作量的方法是将计算密集但简单的部分移至硬件。这在一段时间内已经逐步实现,例如增强了将分段和校验任务卸载到网卡。更近期的改进是 KTLS,它允许将 TLS 中的数据包加密也卸载到网卡。尝试将整个 TCP 卸载到硬件中,以 TCP 卸载引擎(TOE) 的形式,已被 Linux 维护者系统性地拒绝了。因此,尽管有了这些不错的改进,但 TCP 协议栈的主要部分仍然是内核的责任。

因此,另一种解决方案是去除内核作为网卡和应用程序之间的中间层。像 数据平面开发套件(DPDK) 这样的框架允许用户空间轮询网卡以获取数据包,消除了中断的开销,将所有处理保留在用户空间意味着不需要进入和退出内核。DPDK 在采用方面也遇到了困难,因为它需要对网卡的独占控制。因此,每个主机需要有两个网卡,一个用于 DPDK,另一个用于操作系统和其他所有进程。Marc Richards 制作了一个不错的Linux 内核 vs DPDK基准测试,结果显示 DPDK 提供了 50% 的吞吐量提升,随后列举了为获得这 50% 增益而需要接受的一系列缺点。看来这是大多数数据库不感兴趣的权衡,甚至 ScyllaDB 也基本上放弃了对此的投入。

更新的硬件提供了一个有趣的新选项:将 CPU 从网络路径中移除。RDMA(远程直接内存访问) 提供了 verbs,一组有限的操作(主要是读、写和 8 字节的 CAS),这些操作可以完全在网卡内执行,无需 CPU 交互。切断 CPU 后,远程读取的延迟接近 1 微秒,而 TCP 的延迟则超过 100 微秒。作为 RDMA 的一部分,数据包丢失和流量控制的责任也完全下放到网卡。切断 CPU 还意味着可以在不使 CPU 成为瓶颈的情况下传输大量数据。

注释:为什么将丢包检测和流量控制下放到硬件对于 RDMA 是可接受的,但 Linux 维护者一直拒绝对 TCP 这样做?因为这是一个不同且受限得多的 API,减少了网卡与主机之间的复杂性。《TCP 卸载是一个愚蠢但已经到来的想法》 是在这个领域一篇有趣的阅读材料。(来自 2003 年!)

将 RDMA 作为低延迟和高吞吐量的网络原语,改变了人们设计数据库的方式。《神话的终结:分布式事务可以扩展》 显示了 RDMA 的低延迟使经典的 2PL+2PC 能够扩展到大型集群。《云中可扩展的 OLTP 是一个已解决的问题吗?》 提出了在节点之间共享可写页面缓存的想法,因为低延迟使组件的更紧密耦合变得可行。RDMA 不仅适用于 OLTP 数据库;BigQuery 使用了基于 RDMA Shuffle 的连接,因为其高吞吐量。改变给定吞吐量下的延迟和 CPU 利用率,改变了最佳设计的选择,或者解锁了以前被认为不可行的新设计[^3]。

注释:要使用 RDMA,我强烈建议使用 libfabric,因为它对所有不同的 RDMA 供应商和库进行了抽象。RDMAmojo 博客 有多年关于 RDMA 的专业内容,是学习 RDMA 各个方面的最佳资源之一。

最后,还有一类更新的硬件,延续了将更多计算能力放入网卡本身的趋势,即 SmartNIC 或数据处理单元(DPUs)。它们允许将任意计算下放到网卡,并可能响应其他网卡的请求而被调用。这些技术相当新颖,我建议查看 《DPDPU:使用 DPU 进行数据处理》 以获取概览,《DDS:DPU 优化的分布式存储》 了解如何将它们集成到数据库中,以及 《Azure 加速网络:公共云中的 SmartNIC》 了解部署细节。总体而言,我预计 SmartNIC 会将 RDMA 从简单的读写扩展到允许绕过 CPU 的通用 RPC(用于计算成本低的请求回复)。

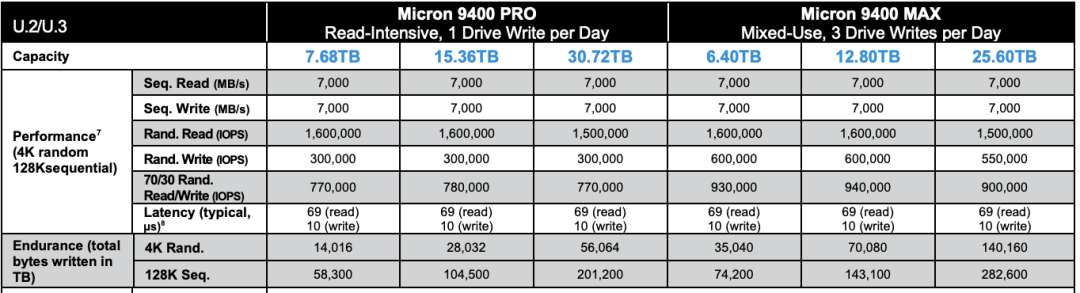

存储

在存储设备方面,有一些旨在降低特定用例中存储设备总拥有成本的进展。制造商巧妙地发现,可以读取比写入产生的磁化硬盘盘片的磁道宽度更小的条带,因此可以重叠磁道以达到最小宽度。于是,我们有了叠瓦式磁记录(SMR)硬盘驱动器,引入了将存储划分为区域(zones)的概念,这些区域只支持追加或擦除。SMR HDD 针对的是像对象存储这样访问不频繁但需要存储大量数据的用例。

类似的想法已被应用到 SSD,分区 SSD(Zoned SSDs)也已出现。在 SSD 中暴露区域意味着驱动器不需要提供闪存转换层(FTL)或复杂的垃圾回收过程。与 SMR 类似,这降低了 ZNS SSD 相对于“常规”SSD 的成本,但还特别关注应用驱动的垃圾回收效率更高,从而减少总的写放大效应并延长驱动器寿命。考虑在 SSD 上的 LSM(Log-Structured Merge Trees),它们已经通过增量追加和大擦除块进行操作。移除 LSM 和 SSD 之间的 FTL,打开了优化的机会。最近,Google 和 Meta 合作提出了灵活数据放置(FDP)的提案,它更像是对具有相关生命周期的写入进行分组的提示,而不是像 ZNS 那样严格执行分区。目标是实现更容易的升级路径,使 SSD 可以忽略写请求的 FDP 部分,仍然在语义上正确,只是性能或写放大效应更差。

注释:如果你期待关于持久内存的讨论,遗憾的是 Intel 已经终止了 Optane,所以目前这是一个死胡同。似乎还有一些公司,如 Kioxia 或 Everspin 继续在这方面努力,但我还没有听说过它们的实际应用。

其他改进并非针对成本效率,而是提高存储设备支持的功能集。特别关注 NVMe,NVMe 添加了复制命令,以消除读取和写入相同数据的浪费。融合的比较与写入命令允许将 CAS 操作下放到驱动器本身,从而实现诸如将乐观锁耦合下放到驱动器的创新设计。NVMe 从 SCSI 继承了数据完整性字段(DIF)和数据完整性扩展(DIX)的支持,这使得可以将页面校验和下放到驱动器中(Oracle 就显著地使用了这一点)。还有像 KV-SSD这样的项目,将整个数据模型从按索引存储块改变为按键存储对象,甚至走向完全取代软件存储引擎。SSD 制造商持续让 SSD 具备更多的操作能力。

注释:截至 2024 年 7 月 25 日,AWS 已取消发布 S3 Select,可能是为了支持 S3 Object Lambda。

作为 SSD 功能的倒数第二步,SmartSSD 正在出现,它允许在 SSD 中集成任意计算。《在 SmartSSD 上进行查询处理:机会与挑战》 综述了它们在查询处理任务中的应用。将过滤器下推到存储总是有利的;我经常引用之前的工作,如利用 S3 Select 的 PushdownDB,作为分析领域的优秀案例。使用 SmartSSD,我们有像 《POLARDB 与计算存储的融合》 这样的论文。即使没有专门的集成,也有人认为,即使是透明的驱动器内压缩也能在写放大方面缩小 B+ 树和 LSM 之间的差距(参考)。利用 SmartSSD 仍然是一个新兴的研究领域,但其潜在影响巨大。

计算

事务处理

在最近的 VLDB 会议上,两位数据库研究领域的权威发表了一篇立场论文:《云原生数据库系统和 Unikernels:为现代硬件重新想象操作系统抽象》,主张 Unikernel 允许数据库针对其确切需求定制操作系统。早期关于 VMCache 的工作特别强调了高效数据库缓冲区管理的挑战,在这个领域,要么接受指针变换(pointerswizzling)的复杂性,要么频繁地挂钩内核并调用 mmap() 相关的系统调用。

两种选择都不理想,而 Unikernel 则提供了对虚拟内存原语的直接访问。随着该领域受到更多关注,开发 Unikernel 所需的努力正在减少。黑金章(Akira Kurogane) 通过 Unikraft 以极小的代价就让 MongoDB 作为Unikernel 运行,后续的帖子显示,在没有任何 MongoDB 内部更改的情况下,性能有所提升。一直以来都有一个无休止的笑话,称数据库想要成为操作系统,因为对性能改进的渴望需要对网络、文件系统、磁盘 I/O、内存等有更多的控制,而 Unikernel 数据库正好提供了这一切,使其成为可能。

为了实现超越 TLS 或磁盘加密的数据机密性,安全飞地(secure enclaves)允许执行可验证的未被篡改的代码,使所操作的数据免受被破坏的操作系统的侵害。可信平台模块(TPM) 允许密钥在机器中安全保存,而安全飞地则扩展到任意的代码和数据。这使得构建对恶意攻击具有极高弹性的数据库成为可能,但对其设计有若干限制。微软已经发表了将安全飞地集成到 Hekaton 中的研究,并已将该工作作为 SQL Server Always Encrypted 的一部分发布。阿里巴巴也发表了他们在为担心数据机密性的企业客户构建飞地原生存储引擎方面的努力。数据库一直以来通过合规监管这一渠道推广安全改进,安全飞地在数据机密性方面是一个有意义的进步。

自从 Spanner 引入 TrueTime 以来,时钟同步在地理分布式数据库的事务排序中变得备受关注。每个主要的云提供商都有一个与原子钟或 GPS 卫星连接的 NTP 服务(AWS、Azure、GCP)。这对任何类似的设计都非常有用,例如 CockroachDB 或 Yugabyte,它们的正确性对时钟同步至关重要,而保守的宽误差范围会降低性能。AWS 最近的 Aurora Limitless 也使用了类似 TrueTime 的设计。这是唯一提到的特定云的、并非完全硬件的内容,因为这是主要的云供应商向用户提供昂贵的硬件(原子钟),而用户原本不会考虑自行购买。

硬件事务内存有着相当不幸的历史。Sun 的 Rock 处理器具备硬件事务内存功能,直到 Sun 被收购并且 Rock 项目被终止。英特尔曾两次尝试发布它,但两次都不得不禁用。在将硬件事务内存应用于内存数据库的主题上有一些有趣的工作,但除了找到一些旧的 CPU 进行实验之外,我们都必须等待 CPU 制造商宣布他们计划再次尝试。

注释:第一次是由于一个错误,第二次是由于一个破坏 KASLR 的侧信道攻击。还有一个通过误解CTF 挑战的意图而发现的投机执行定时攻击。

查询处理

一直以来,不断有公司成立,试图利用专用硬件来加速查询处理,以实现比仅使用 CPU 的竞争对手更好的性能和成本效率。像 Voltron、HEAVY.ai 和 Brytlyt 这样的 GPU 驱动数据库,就是朝这个方向迈出的第一步。如果英特尔或 AMD 的集成显卡在未来某个时候获得 OpenCL 支持,我不会感到太惊讶,这将为所有数据库在更广泛的硬件配置中假设一定程度的 GPU 能力打开大门。

注释:OpenGL 计算着色器是使用 GPU 进行任意计算的最通用和可移植的形式,而集成显卡芯片组已经支持这些。不过,我找不到任何关于使用它们的数据库相关论文。

还有机会使用更高能效的硬件。最新的神经处理单元(NPU)和张量处理单元(TPU)已经在类似 《TCUDB:使用张量处理器加速数据库》 的工作中被证明可用于查询处理。一些公司尝试利用 FPGA。Swarm64 曾试图(但可能失败了)进入这个市场。AWS 自己也以 Redshift AQUA 进行了尝试。即使是最大的公司,走到 ASIC 这一步似乎也不值得,因为连 Oracle 都在 2017 年停止了他们的 SPARC 开发。我对 FPGA 到 ASIC 的前景并不十分乐观,因为内存带宽无论如何都会在某个时候成为主要瓶颈,但 ADMS 是关注该领域论文的会议。

注释:严格来说,ADMS 是附属于 VLDB 的一个研讨会,但我不知道泛指会议、期刊和研讨会的词是什么。

云端可用性

最后,让我们直面这个令人沮丧的事实:如果无法获得,这些硬件进步都无关紧要。对于当今的系统,这意味着云端,而云端并未向客户提供最前沿的硬件进步。

在网络方面,情况并不理想。DPDK 是相对容易获取的最先进网络技术,因为大多数云允许某些类型的实例拥有多个网卡。AWS 以 安全可靠数据报(SRD) 的形式提供了伪 RDMA,根据基准测试,其性能大约介于 TCP 和 RDMA 之间。真正的 RDMA 仅在 Azure、GCP 和 OCI 的高性能计算实例中可用。只有阿里巴巴在通用计算实例上提供了 RDMA。

注释:尽管可能会有类似于 SRD 较差的延迟影响。阿里巴巴通过 iWARP 部署了 RDMA,速度可能会稍慢一些,但我还没有看到任何基准测试。

SmartNIC 在任何公开场合都不可用。这其中有充分的理由:微软发表的论文指出,部署 RDMA 是困难的。事实上,非常困难。即使是他们关于成功使用 RDMA 的论文也强调了这非常困难。距离微软开始在内部使用 RDMA 已经接近十年了,但它仍未在他们的云端提供。我无法猜测它是否或何时会出现。

在存储方面,情况并没有好多少。SMR HDD 少数几次进入消费市场时,仍以支持块存储 API 的驱动器形式出现,消费者对此非常反感。ZNS SSD 似乎同样被锁定在仅限企业采购的协议背后。有人可能认为英特尔停止了 Optane 品牌的持久内存和 SSD,这意味着它们在云端不可用,但阿里巴巴仍然提供了持久内存优化的实例。Spare Cores 的优秀团队实际上向我提供了每个云供应商的 nvme id-ctrl 输出,他们获取的 NVMe 设备都没有支持任何可选功能:复制、融合的比较和写入、数据完整性扩展,或多块原子写入。

注释:尽管 AWS 支持防止撕裂写入,GCP 以前也有类似的文档。

阿里巴巴也是唯一一家在 SmartSSD 上进行投资的云供应商,与 ScaleFlux 合作在 PolarDB 上进行了研究。这仍然意味着 SmartSSD 对公众不可用,但即使论文也承认,这是“首次在公开文献中报道的、使用计算存储驱动器的云原生数据库的实际部署”。

在计算方面,情况终于有所改善。云完全允许 Unikernel,TPM 也广泛可用,但据我所知,只有 AWS 和 Azure支持安全飞地。时间同步已可用,但没有承诺的误差范围使得无法关键依赖。(硬件事务内存不可用,但这很难责怪云供应商。)AI 的爆炸式增长意味着有足够的资金支持更高效的计算资源。GPU 在所有云中都可用。AWS[^5]、Azure、IBM 和阿里巴巴提供了 FPGA 实例。(GCP 和 OCI 没有。)不幸的现实是,只有当计算成为瓶颈时,更快的计算才有意义。GPU 和 FPGA 都受到内存限制的影响,因此无法在其本地内存中维护数据库。相反,需要依赖数据的流入和流出,这意味着受到 PCIe 速度的限制。所有这些都会鼓励在本地设备中进行周到的主板布局和总线设计,但这在云中是不可行的。

注释:理想情况下,人们希望有对等 DMA 支持,能够直接从磁盘读取数据到 FPGA 中,而至少 AWS 的 F1 不支持这一点。

因此,我对下一代数据库的看法是悲观的:在新硬件进步可用之前,没人能够构建严重依赖它们的数据库,但没有云供应商愿意部署无法立即使用的硬件。下一代数据库正被这种循环依赖所束缚,因为它们尚未存在。

注释:除了云供应商自己。最值得注意的是,微软和谷歌在内部已经拥有 RDMA 并在他们的数据库产品中广泛利用,同时不允许公众使用。我一直有一篇草稿文章的提纲,标题是“云供应商的 RDMA 竞争优势”。

然而,阿里巴巴的表现令人惊讶地出色。他们始终处于让所有硬件进步可用的前沿。我很惊讶在学术界和工业界中没有经常看到使用阿里巴巴进行基准测试。

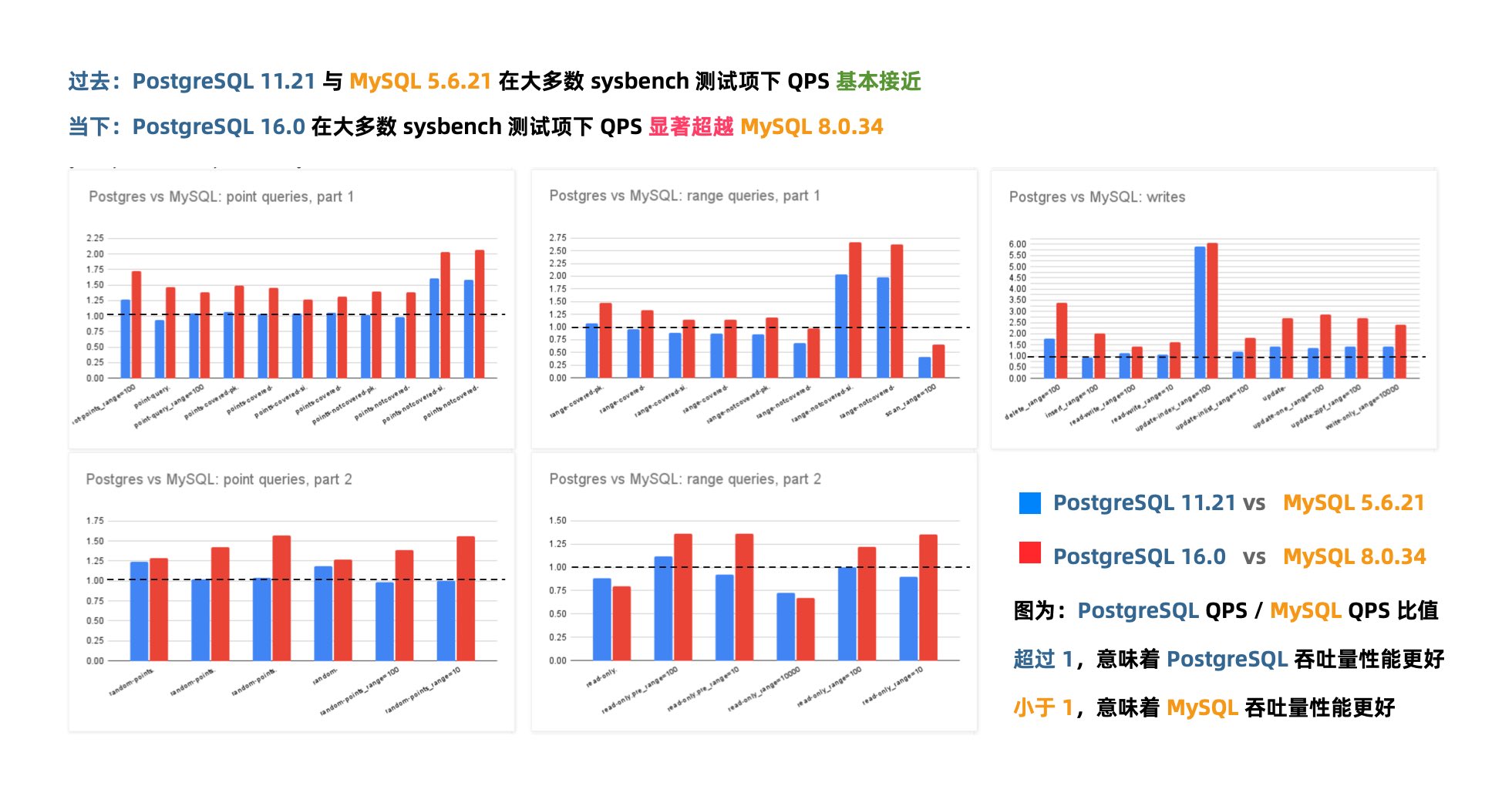

PZ:MySQL还有机会赶上PostgreSQL的势头吗?

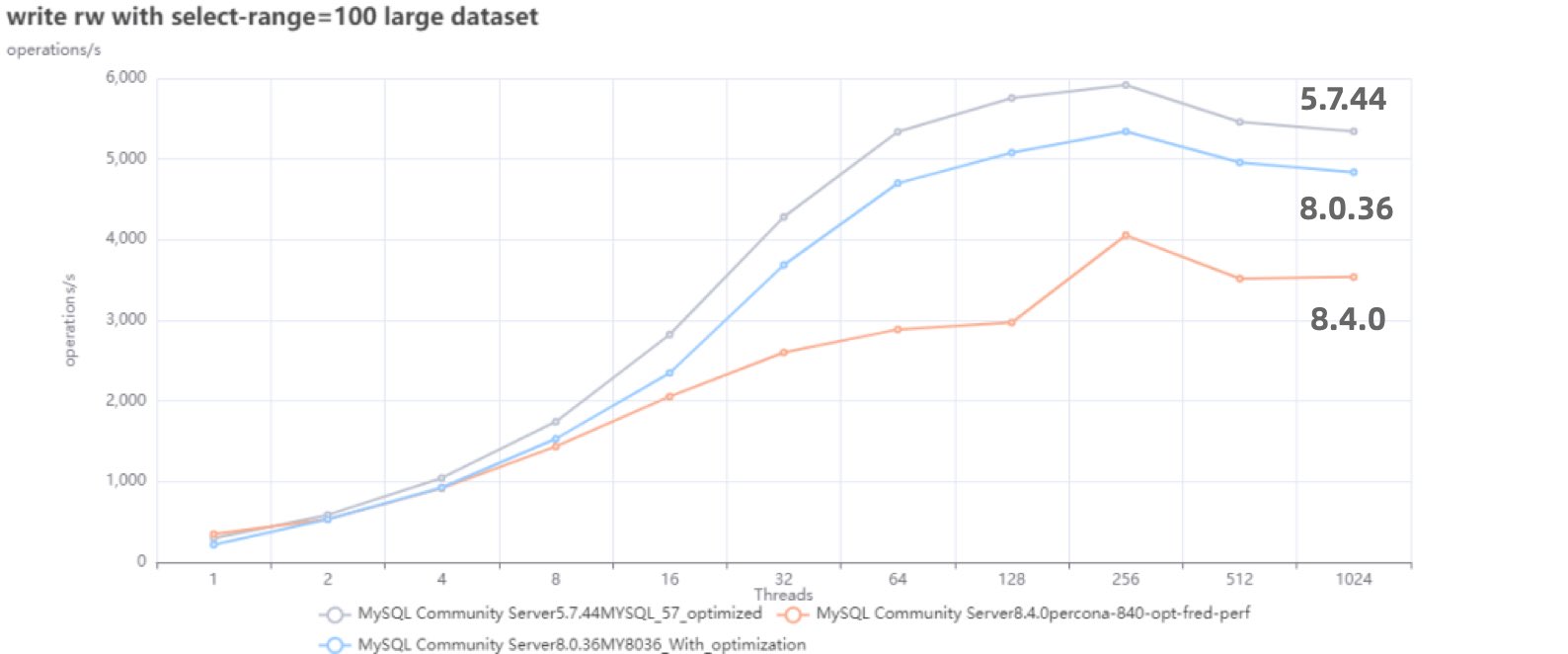

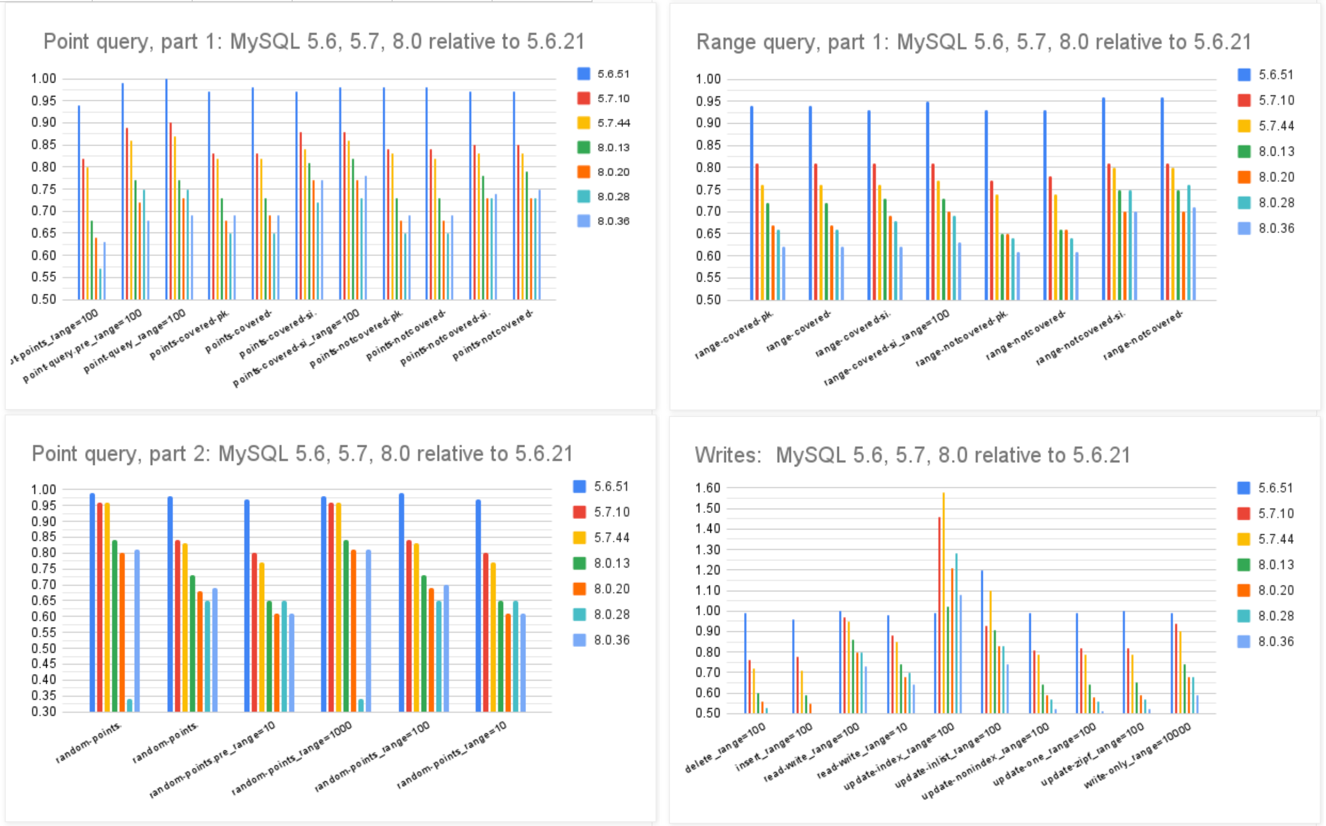

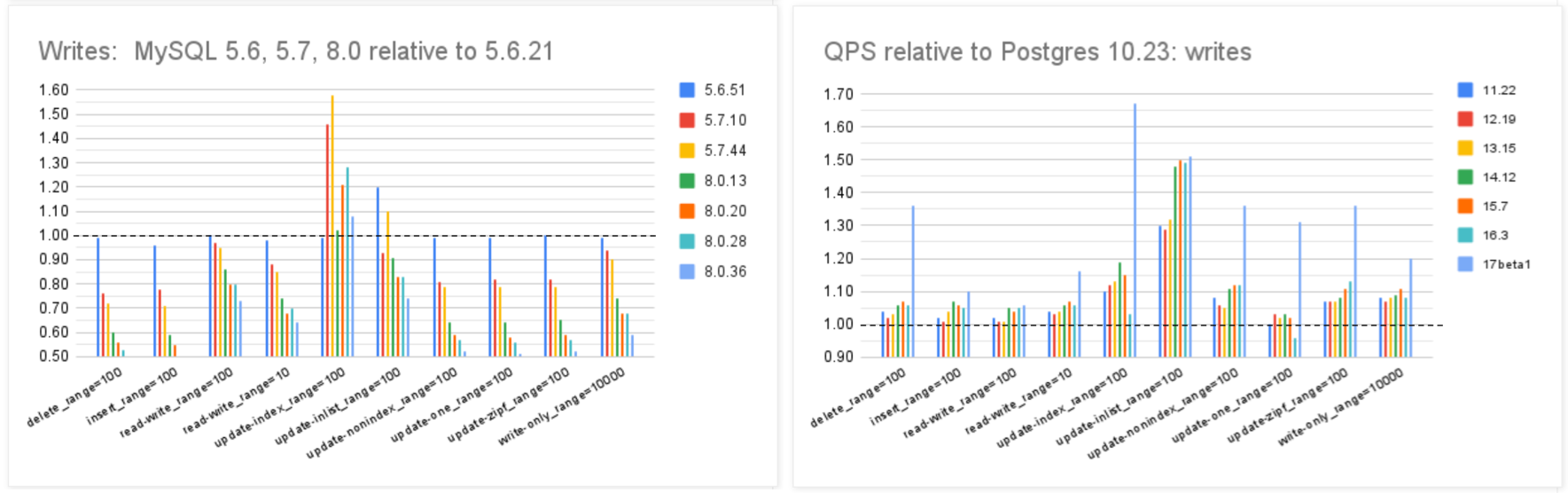

Percona 的老板 Peter Zaitsev最近发表一篇博客,讨论了MySQL是否还能跟上PostgreSQL的脚步。

Percona 作为MySQL 生态扛旗者,Percona 开发了知名的PT系列工具,MySQL备份工具,监控工具与发行版。他们的看法在相当程度上代表了 MySQL 社区的想法。

作者:Peter Zaitsev,Percona 老板,原文:How Can MySQL Catch Up with PostgreSQL’s Momentum?

MySQL还能跟上PostgreSQL的步伐吗?

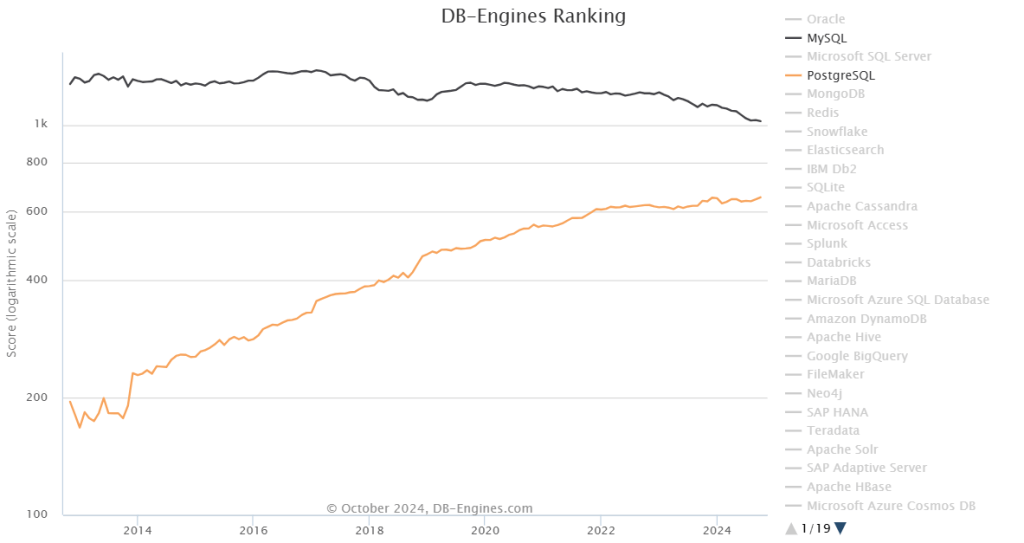

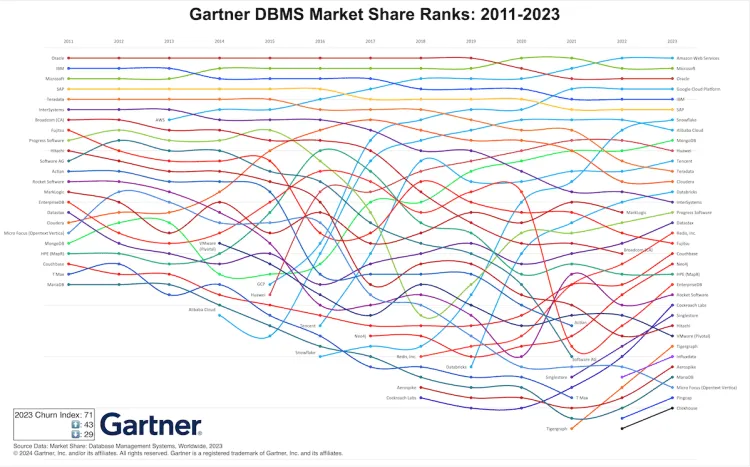

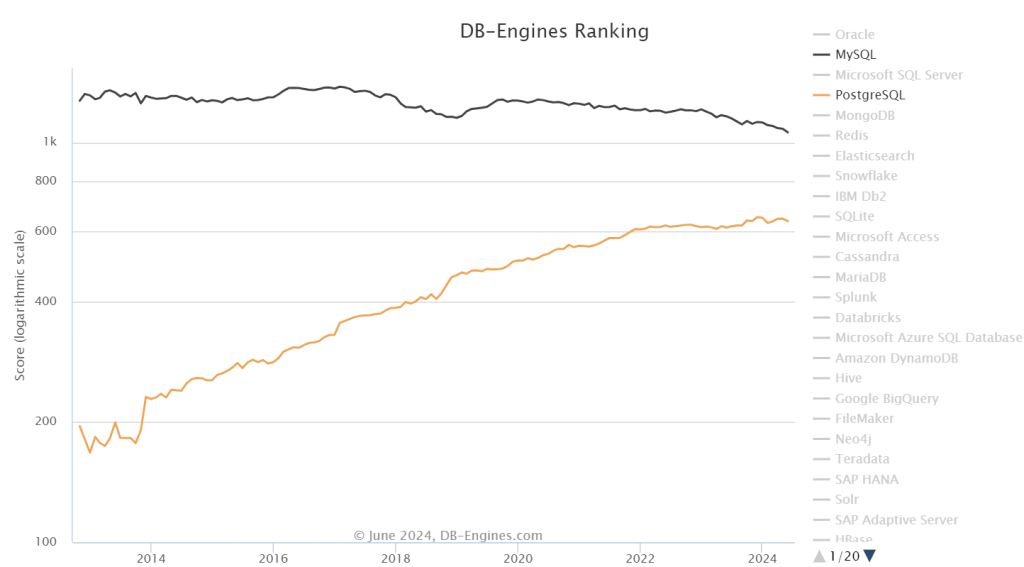

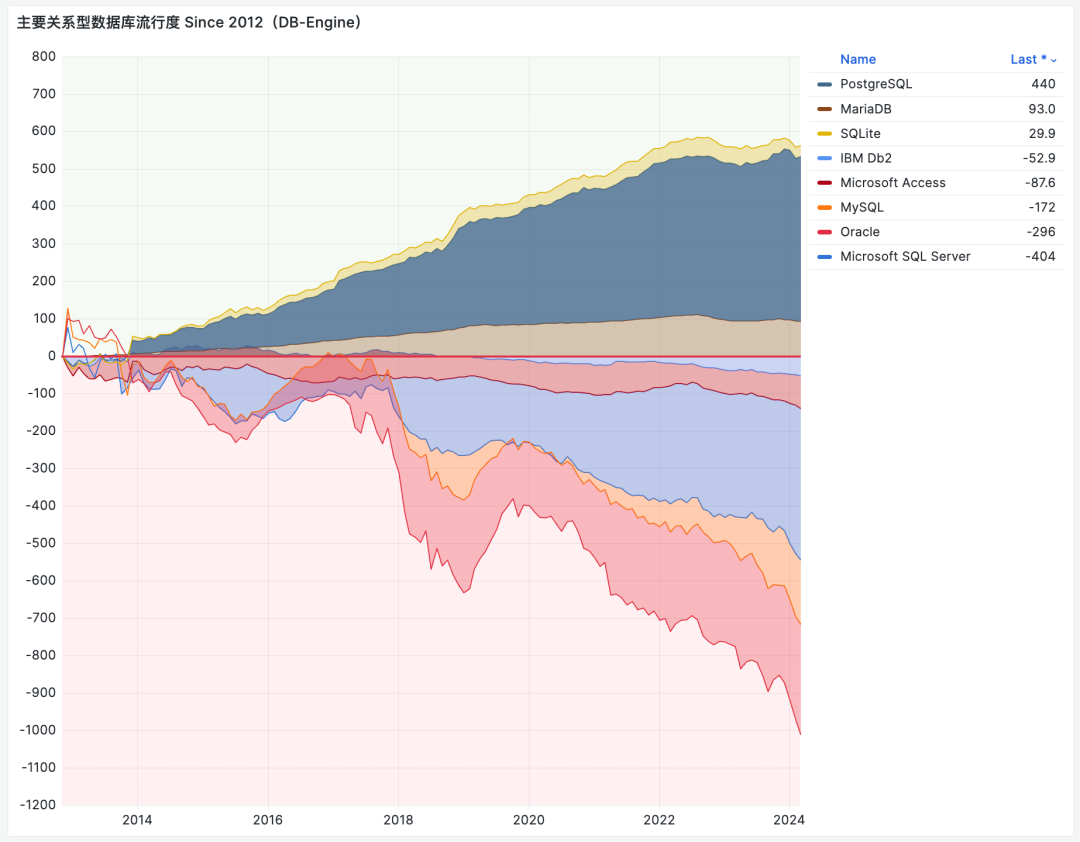

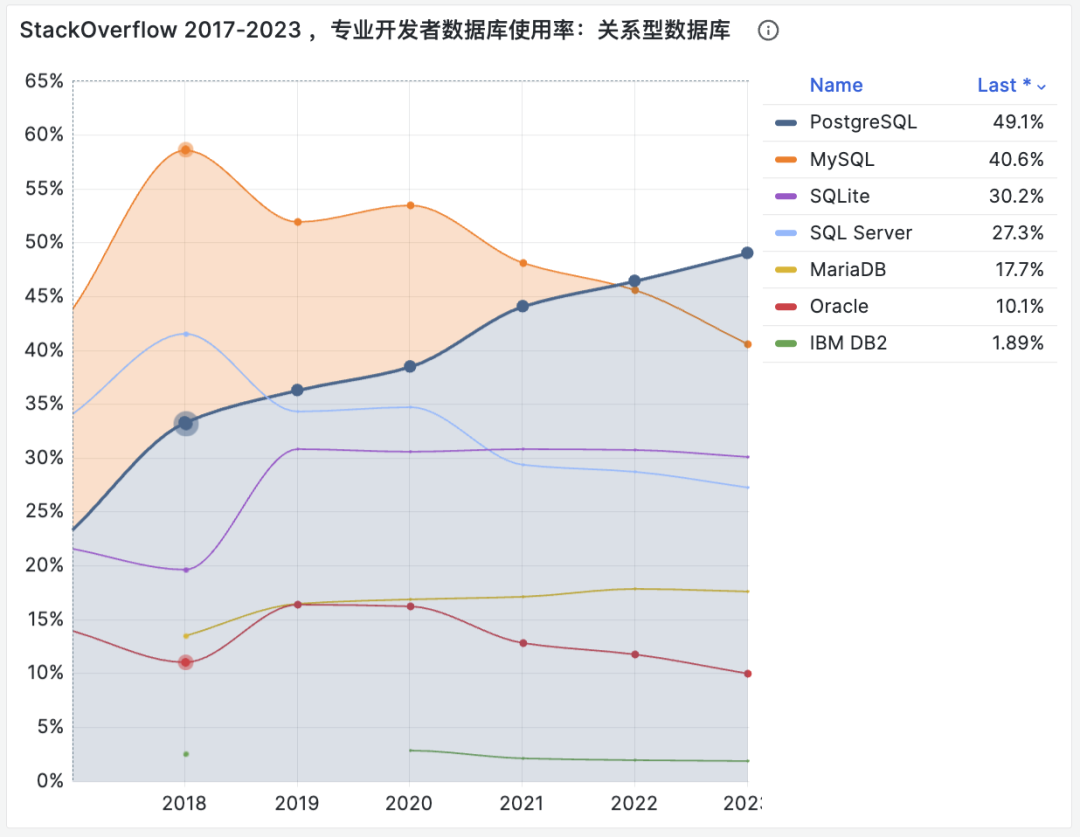

当我与MySQL社区的老前辈交谈时,我经常听到这样的问题:“为什么MySQL如此出色,依然比PostgreSQL更受欢迎(至少根据DB-Engines的统计方法),但它的地位却在不断下降,而PostgreSQL的受欢迎程度却在不可阻挡地增长?” 在MySQL 生态能做些什么扭转这一趋势吗?让我们来深入探讨一下!

让我们看看为什么PostgreSQL一直表现如此强劲,而MySQL却在走下坡路。我认为这归结为所有权与治理、许可证、社区、架构以及开源产品的势能。

所有权和治理

MySQL 从未像 PostgreSQL 那样是“社区驱动”的。然而,当 MySQL 由瑞典小公司 MySQL AB 拥有,且由终身仁慈独裁者(BDFL)Michael “Monty” Widenius掌舵时,它获得了大量的社区信任,更重要的是,大公司并没有将其视为特别的威胁。

现在情况不同了——Oracle 拥有 MySQL,业界的许多大公司,特别是云厂商,将 Oracle 视为竞争对手。显然它们没有理由去贡献代码与营销,为你的竞争对手创造价值。此外,拥有 MySQL 商标的 Oracle 在 MySQL 上总是会有额外的优先权。

相比之下,PostgreSQL 由社区运营,领域内的每个商业供应商都站在同一起跑线上—— 像 EDB 这样的大公司与PostgreSQL 生态系统中的小公司相比,没有特殊的优待。

这意味着大公司更愿意贡献并推荐 PostgreSQL 作为首选,因为这不会为他们的竞争对手创造价值,而且他们对PostgreSQL 项目的方向有更大的影响力。数百家小公司通过本地“草根”社区的开发和营销努力,使 PostgreSQL 在全球无处不在。

MySQL社区能做些什么来解决这个问题? MySQL 社区能做的很少——这完全掌握在 Oracle 手中。正如我在《Oracle能拯救MySQL吗?》中所写,将 MySQL 移交给一个中立的基金会(如 Linux 或 Kubernetes 项目)将提供与 PostgreSQL 竞争的机会。不过,我并不抱太大希望,因为我认为Oracle此刻更感兴趣的是“硬性”变现,而不是扩大采用率。

许可证

MySQL 采用双许可证模式: GPLv2 和可从 Oracle 购买的商业许可证,而PostgreSQL则采用非常宽松的 PostgreSQL 许可证。

这实际上意味着您可以轻松创建使用商业许可的 PostgreSQL衍生版本,或将其嵌入到商业许可的项目中,而无需任何“变通方法”。构建此类产品的人们当然是在支持和推广 PostgreSQL。

MySQL 确实允许云供应商创建自己的商业分支,具有MySQL兼容性的 Amazon Aurora 是最知名和最成功的此类分支,但在软件发行时这样做是不允许的。

MySQL社区能做什么? 还是那句话,能做的不多 ——唯一能在宽松许可证下重新授权MySQL的公司是Oracle,而我没有理由相信他们会想要放松控制,尽管“开放核心”和“仅限云”的版本通常与宽松许可的“核心”软件配合良好。

社区

我认为,当我们考虑开源社区时,最好考虑 三个不同的社区,而不仅仅是一个。

首先,用户社区。MySQL在这方面仍然表现不错,尽管 PostgreSQL 正日益成为新应用的首选数据库。然而,用户社区往往是其他几个社区工作的成果。

其次,贡献者社区。PostgreSQL 有着更强大的贡献者社区,这并不奇怪,因为它是由众多组织而非单一组织驱动的。我们举办了针对贡献者的活动,还编写了关于如何为 PostgreSQL 作出贡献的书籍。PostgreSQL 的可扩展架构也有助于轻松扩展 PostgreSQL,并公开分享工作成果。

最后,供应商社区。我认为这正是主要问题所在,没有那么多公司有兴趣推广 MySQL,因为这样做可能只是为Oracle 创造价值。你可能会问,这难道不会鼓励所有 Oracle 的“合作伙伴”去推广 MySQL 吗?可能会,在全球范围内也确实有一些合作伙伴支持的MySQL活动,但这些与供应商对 PostgreSQL 的支持相比,简直微不足道,因为这是 “属于他们的项目”。

MySQL社区能做什么? 这里社区还是可以发挥一点作用的 —— 尽管当前的状况使得工作更困难,回报更少,但我们仍然可以做很多事情。如果你关心 MySQL 的未来,我鼓励你组织与参与各种活动,尤其是在狭窄的 MySQL生态之外,去撰写文章、录制视频、出版书籍。在社交媒体上推广它们,并将它们提交到 Hacker News。

特别是,不要错过 FOSDEM 2025 MySQL Devroom 的征稿!

这也是 Oracle 可以参与的部分,它们可以在不减少盈利的情况下参与这些活动,并与潜在的贡献者互动 —— 举办一些外部贡献者可以参与的活动,与他们分享计划,支持他们的贡献 —— 至少在他们与你的“MySQL社区”蓝图一致的情况下。

架构

一些 PostgreSQL 同行认为,PostgreSQL 发展势头更好的原因源于更好的架构和更干净的代码库。我认为这可能是一个因素,但并非主要原因,这里的原因值得讨论。

PostgreSQL 的设计高度可扩展,而且已经实现有大量强大的扩展插件,而 MySQL 的扩展可能性则非常有限。一个显著例外是存储引擎接口 —— MySQL支持多种不同的存储引擎,而 PostgreSQL 只有一个(尽管像 Neon 或 OrioleDB 这样的分叉可以通过打补丁来改变这一点)。

这种可扩展性使得在 PostgreSQL 上进行创新更加容易,(特别是PG还有着一个更强大的贡献者社区支持),而无需将新功能纳入核心代码库中。

MySQL社区能做些什么? 我认为即使 MySQL 的可扩展性很有限,我们仍然可以通过MySQL已经支持的各种类型的插件和“组件”来实现很多功能。

我们首先需要为MySQL建立一个“社区插件市场”,这将鼓励开发者构建更多插件并让它们得到更多曝光。我们还需要Oracle的支持 —— 承诺扩展MySQL的插件架构,赋能开发者构建插件 —— 即使这会与Oracle的产品产生一些竞争。例如,如果 MySQL 有插件可以创建自定义数据类型和可插拔索引,或许我们已经会看到 MySQL 的 PGVector替代品了。

开源产品的势头

选择数据库是一个长期的赌注,因为更换数据库并不容易。去问问那些几十年前选择了 Oracle 而现在被其束缚的人吧。这意味着在选择数据库时,你需要考虑未来,不仅要考虑这些数据库在十年后是否依然存在,而且要考虑随着时间的发展,它是否还能满足未来的技术需求。

正如我在文章 《Oracle最终还是杀死了MySQL!》 中所写到的,我认为Oracle已经将大量开发重心转移到专有商业版和云专属的 MySQL 版本上 —— 几乎放弃了 MySQL 社区版。虽然今日的 MySQL 仍然在许多应用中表现出色,但它确实正在落后过气中,MySQL 社区中的许多人都在质疑它是还有未来。

MySQL社区能做什么? 还是那句话,决定权在 Oracle 手中,因为他们是唯一能决定 MySQL 官方路线的人。你可能会问,那么我们的 Percona Server for MySQL 呢?我相信在Percona,我们确实提供了一个领先的 Oracle MySQL的开源替代品,但因为我们专注于完整的 MySQL 兼容性,所以必须谨慎对待对 MySQL 所做的变更,以避免破坏这种兼容性或使上游合并成本过高。MariaDB 做出了不同的利弊权衡;不受限制的创新使其与MySQL 的兼容性越来越差,而且每个新版本都离 MySQL 越来越远。

MariaDB

既然提到了MariaDB,你可能会问,MariaDB 不是已经尽可能地解决了所有这些问题吗?—— 毕竟 MariaDB 不是由 MariaDB基金会等机构管理的吗?别急,我认为MariaDB是 一个有缺陷的基金会,它并不拥有所有的知识产权,尤其是商标,无法为所有供应商提供公平的竞争环境。它仍然存在商标垄断问题,因为只有一家公司可以提供所有 “MariaDB” 相关的服务,地位高于其他所有公司。

然而,MariaDB 可能有一个机会窗口;随着 MariaDB(公司)刚刚被K1收购,MariaDB的治理和商标所有权有机会向 PostgreSQL 的模式靠近。不过,我并不抱太大希望,因为放松对商标知识产权的控制并不是私募股权公司所惯常做的。

当然,MariaDB 基金会也可以选择通过将项目更名为 SomethingElseDB 来获得对商标的完全控制,但这意味着MariaDB 将失去所有的品牌知名度;这也不太可能发生。

MariaDB 也已经与 MySQL 有了显著的分歧,调和这些差异将需要多年的努力,但我认为如果有足够的资源和社区意愿,这也许是一个可以解决的问题。

总结

正如你所看到的,由于 MySQL 的所有权和治理方式,MySQL 社区在其能做的事情上受到限制。从长远来看,我认为 MySQL 社区唯一能与 PostgreSQL 竞争的方法是所有重要的参与者联合起来(就像Valkey项目那样),在不同的品牌下创建一个 MySQL 的替代品 —— 这可以解决上述大部分问题。

开源“暴君”Linus清洗整风

最近Linus在项目中踢出了几位俄罗斯籍开发者,引发开源世界中的一片哀嚎声。但其实很多人都忘记了,Linux 是 Linus 的个人项目,三十年前是,现在也依然是。Linus 本人始终亲自掌握着开源项目的最高权力 —— Linux 的发布权。Linux 社区本质是帝制的 —— 而 Linus 本人就是最早且最成功的技术独裁者。

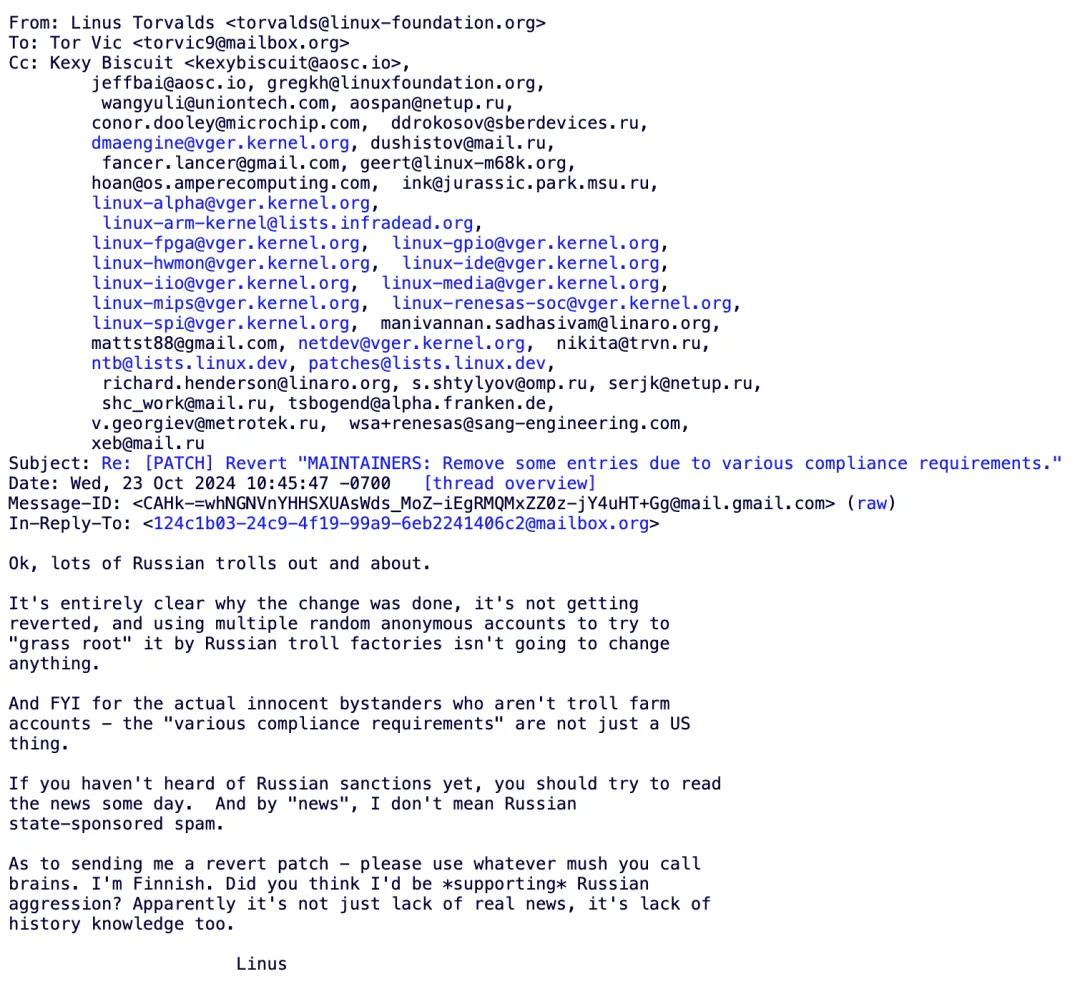

Ok, lots of Russian trolls out and about.

It’s entirely clear why the change was done, it’s not getting reverted, and using multiple random anonymous accounts to try to “grass root” it by Russian troll factories isn’t going to change anything. And FYI for the actual innocent bystanders who aren’t troll farm accounts - the “various compliance requirements” are not just a US thing.

If you haven’t heard of Russian sanctions yet, you should try to read the news some day. And by “news”, I don’t mean Russian state-sponsored spam.

As to sending me a revert patch - please use whatever mush you call brains. I’m Finnish. Did you think I’d be supporting Russian aggression? Apparently it’s not just lack of real news, it’s lack of history knowledge too.

Linus

在开源/自由软件社区,有 BDFL(“Benevolent Dictator for Life”,译为“仁慈的终身独裁者”)的说法。例如 Python 之父 Guido van Rossum,与 Linux 之父 Linus Torvalds。当然在很多人眼中,Linus 算不上 “仁君”,而是一个“暴君”,比如,Linus 经常使用直白粗俗的语言,公开斥责羞辱批评其他技术,参与者,厂商。

但这个 “暴君” 几十年如一日地在挖土,并且把自己的劳动毫无保留的贡献给别人,无数操作系统公司籍此赚的钵满盆翻。而正所谓 “升米恩,斗米仇” —— 时间一长,大家习惯了他的慷慨,却忘记了这个项目从头到尾,都是 Linus 本人的 “兴趣” 。在 Linus 自传的书名《Just for Fun》中,这一点体现的淋漓尽致 —— Linus 项目只是 Linux 本人的 Hobby。

能够约束 Linus 本人的,也就只有 Linux 项目使用的 GPL 协议 —— 他既没有成立公司搞商业化,也没有阻止其他人复制它。开源社区就是这样,太平洋也没加盖,代码都放在那里,你行你就上,搞个 fork 分叉呗?我一点儿也不怀疑,如果 Linus 本人哪天薨了,Linux 项目很快就会散作满天星,分叉满天飞了。

按照开源社区的习惯法,如果有人对此感到不满,完全可以自己做个 Fork 和上游比拼生产力,发起一场斯巴达克斯式的造反运动。例如 GCC 之前由于理念不同也分裂过,后来支线干的比主线好,更受开发者欢迎,这个支线(EGCS)就成新主线了。正所谓:“Talk is cheap, show me the code”, “You can you up, no can no BB” —— 而不是逼逼叨跟怨妇似的高呼:“ Linus 大王你变了” 或者 “Linus 大傻逼”,并指望天降正义。

当然,在我看来,Linus 这次做法并不好,但不是因为他把老毛子开发者给踢了。而是因为他没有用光明正大,堂堂正正的方式踢掉老毛子。而是由二号位采取比较遮掩,含糊的形式做了这件事,然后 Linus 合并,并在事后用胡扯蛋式的回复来回应,留下了一些破坏开源社区习惯法的污点瑕疵。

他要是光明正大的说:“我收到米帝的制裁禁令,要干老毛子”。或者干脆就两手一摊 “老子爱咋样咋样,你们管不着” —— Which is fact —— 说不定就没这么多事了。

老冯评论

全球化的时代过去了,逆全球化的风雨已经吹进了开源社区中。上古竞于道德的时代过去了,而当今争于气力。在从全球化走向区域化的大趋势中,一定会发生的事情就是 “共同体(社区)边界的重新划定”,或者干脆就是老的全球性大社区分裂成几个新的小社区。

而在这个划界过程中,必然会出现“他者”与“敌人”。有实质内容的理想,必然会制造出敌人 —— 没有敌人,说明你的社区理念没有实质内容,也就不会有真正的支持者。理想是权力欲望的最高形态,而邪恶是权力的内在本质,理想和邪恶不可分离,犹如爱情和嫉妒不可分离一样。

Linus 很明显已经划出了一道新的边界,将老毛子划出了社区边界之外 —— 一场 “清洗整风” 运动,尽管被许多人认为这是“邪恶”的,然而这正是其权力意志与“主权”的体现,嘴炮与谴责在实力面前太过廉价,改变不了什么。

而被划除在社区边界之外的老毛子,以及有较大概率步其后尘的老中,确实应该好好思考一下以后的道路该怎么走了。

参考阅读

先优化碳基BIO核,再优化硅基CPU核

先优化生物核,再优化硅内核

企业痴迷于 AI 的一个重要原因是,它有可能显著降低程序员的薪酬成本。如果一个公司需要 10 名程序员完成一项任务,而每个程序员的年薪为 20 万美元,那这就是一个每年 200 万美元的问题。如果 AI 能砍掉四分之一的成本,他们就能省出 50 万美元!如果能砍一半那就是 100 万美元!提高效率在程序员的薪资成本上会很快转化为利润!

这就是为什么我喜欢 Ruby!这就是我搞 Rails 的原因!过去 20 年,我一直坚信编程领域的趋势是:程序员的成本会越来越高,而计算机的成本却在不断下降。因此,聪明的做法是提高程序员的生产力,即使以牺牲计算机资源为代价!

很多程序员难以理解这一点 —— 他们实际上是非常昂贵的“生物计算核”,而且是真正稀缺的资源。而硅制计算内核却非常丰富,成本也在不断下降。所以随着时间推移,用计算机的时间换取程序员生产力的交易会越来越划算。AI 是实现此目标的方式之一,但像 Ruby on Rails 这样的工具从一开始关注的也是这个问题。

我们再看看那个年薪 20 万美元的程序员。你可以从 Hetzner 租用 1 个 AMD EPYC CPU核,年租金是 55 美元(批发模式,一台 48 核的服务器月租金 220 $元,所以 220 x 12 / 48 = 55)。这意味着一个生物核的价格,相当于 3663 个硅基核。如果你能让生物核的效率提高 10%,你就相当于节省了 366 个硅核的成本。如果你能让生物核的效率提高 25%,那你就相当于节省了接近一千个硅基核!

但是,许多“软绵绵的”生物编程内核对它们的硅制同类怀有一种独特的人类同情,这种情感超越了理性的数学计算。他们单纯地觉得 —— 自己可以花更多时间,通过使用对自己不高效、但对硅内核更高效的工具和技术,来减少硅内核的负担,而不是要求硅内核做更多的工作。对于某些人来说,减轻硅内核的负担几乎成了一种道德责任,似乎他们认为自己有义务尽量承担这些任务。

从艺术和精神层面上讲,我其实还挺尊重这种做法的!让计算机用更少的资源完成更多任务,确实有一种美好的感觉。我依然对 Commodore 64 和 Amiga 时代的 Demo 充满怀念。当年那些技术高手仅用 区区4KB 就能让计算机呈现出惊艳的音画效果,实在是令人难以置信。

然而在大多数情况下,这种做法在经济上并不划算。当然,在计算性能的前沿阵地上依然需要有人去挖掘最后一丝性能。比如,需要有人从 NVIDIA 4090 显卡中榨干最后一滴性能,我们的 3D 引擎才能在 4K / 120FPS 下进行光线追踪。但这对于软件行业中的绝大多数业务场景都不现实 —— 它们的业务是写业务软件!对于这类工作,不需要什么史诗级优化,计算机在很久以前就已经足够快了。

这也是我过去 20 年来,我一直在做的工作!开发业务软件并将其作为 SaaS 销售。整个行业都在做同样的事情,带来了巨大的利润和就业机会。这是一次历史性的牛市行情,主要由使用高级语言解决业务逻辑的程序员驱动 —— 他们找出产品与市场的契合点(PMF)来推动进步。

所以,每当听到关于计算效率的讨论时,你应该想起这个“软绵绵的”生物核。世界上大多数软件的价格都是基于它们的人工成本,而不是所需的硅内核。因而哪怕只是稍微提高生物核的生产力,也值得在硅芯片采购上花大钱。而且这种成本效益的比例,只会年复一年更偏向于充分利用生物核。

—— 至少在 AGI 霸主到来前,生物核都不会彻底过时!但没有人知道这一天何时会来,或者是否会到来。所以最好着眼于当下的经济学,选择对你来说最能提高生产力的工具链,并相信快乐的程序员将是你投资中最划算的一笔。

作者:David Heinemeier Hansson,DHH,37 Signal CTO,Ruby on Rails 作者

译者:冯若航,PostgreSQL Hacker,开源 RDS PG —— Pigsty 作者,数据库老司机,云计算泥石流。

优先优化生物内核,其次是硅内核 @ 2024-09-06

老冯评论

DHH 的博客一如既往地充满洞见 —— 虽然事实听上去可能并不讨喜,但程序员本质上也是一种生物计算核 —— Bio Core ,而很多程序员已经忘记了这一点。

实际上在一百年前,Computer 指的还是 “计算员” 而非 “计算机”;而在上世纪四五十 年代,算力的衡量单位更一度是 —— “Kilo-Girls”,即一千名女孩的计算速度,类似的单位还有 kilo-girl-hour 等。当然,随着信息技术的突飞猛进,这些枯燥乏味的计算活计都交给计算机了,程序员得以专注于更高层次的抽象和创造。

对于我所在的数据库行业,我认为这篇文章能带给用户的一个启示是 —— 数据库的真正瓶颈早就不是 CPU 硅基核了,而是能用好数据库的生物核。对于绝大多数用例,数据库的瓶颈早已不再是 CPU,内存, I/O,网络,存储,而是开发者与 DBA 的思维,认知,经验,智慧。

因此,没人会在乎你的数据库能否支持 100 万 TPS,而是你的软件是否能用最小的时间成本,复杂度成本,认知成本解决问题。 易用性、简单性、可维护性成为了竞争的焦点 —— 专注于此道的 RDS 数据库服务也因此大获成功(同理还有 Neon, Supabase,Pigsty 等)。

像 AWS 这样的云厂商拿着开源的 MySQL 和 PostgreSQL 内核一路杀到了数据库市场一哥的位置,是因为 AWS 比 Oracle / EDB 有更深的数据库内核造诣,懂得如何利用硅基核吗?非也。而是因为比起优化硅基核,他们更懂得如何优化生物核 —— 他们懂得如何让开发者,DBA,运维更容易用好数据库 —— 用好数据库,而非制造数据库,成为了新的核心瓶颈点。

所以,传统数据库内核是一个夕阳产业,将与格力空调,联想电脑一样成为低毛利的制造业。 而真正的高科技与技术创新,将发生在数据库管控上 —— 用软件辅助、赋能、甚至冒天下之大不韪的“替代” 一部分开发者 —— 如何用好数据库内核与硅基CPU核,提高生物核的生产力,降低认知成本,简化复杂度,提高易用性。这才是未来数据库行业的发展方向。

高科技行业就是要依靠技术创新驱动。如果你能用开源 PG 内核替代 Oracle ,SQL Server,那别人也能 —— 最好的结果无非就是甲骨文微软都放弃传统数据库转型做云服务,传统数据库成为低利润的制造业。正如二十年的 PC 行业一样。二十年前 IBM 戴尔惠普都是国际玩家,中国联想说要做到世界一流。今天看联想确实做到了,但是 PC 行业早就不是高科技行业了,只是一个最无聊普通的制造业。

即使是在国内看起来很能打的真自研分布式数据库内核,如果选错了赛道,那所能期待的最好结局也不过是成为数据库行业的长虹,赚五个点的利润。然后被拿着开源 PostgreSQL 内核提供服务的 云厂商 RDS 和本地优先 RDS 骑脸输出,最终成为数据库领域的 “Kilo-Girl”。

Optimize for bio cores first, silicon cores second

David Heinemeier Hansson 2024-09-06

A big part of the reason that companies are going ga-ga over AI right now is the promise that it might materially lower their payroll for programmers. If a company currently needs 10 programmers to do a job, each have a cost of $200,000/year, then that’s a $2m/year problem. If AI could even cut off 1/4 of that, they would have saved half a million! Cut double that, and it’s a million. Efficiency gains add up quick on the bottom line when it comes to programmers!

That’s why I love Ruby! That’s why I work on Rails! For twenty years, it’s been clear to me that this is where the puck was going. Programmers continuing to become more expensive, computers continuing to become less so. Therefore, the smart bet was on making those programmers more productive EVEN AT THE EXPENSE OF THE COMPUTER!

That’s what so many programmers have a difficult time internalizing. They are in effect very expensive biological computing cores, and the real scarce resource. Silicon computing cores are far more plentiful, and their cost keeps going down. So as every year passes, it becomes an even better deal trading compute time for programmer productivity. AI is one way of doing that, but it’s also what tools like Ruby on Rails were about since the start.

Let’s return to that $200,000/year programmer. You can rent 1 AMD EPYC core from Hetzner for $55/year (they sell them in bulk, $220/month for a box of 48, so 220 x 12 / 48 = 55). That means the price of one biological core is the same as the price of 3663 silicon cores. Meaning that if you manage to make the bio core 10% more efficient, you will have saved the equivalent cost of 366 silicon cores. Make the bio core a quarter more efficient, and you’ll have saved nearly ONE THOUSAND silicon cores!

But many of these squishy, biological programming cores have a distinctly human sympathy for their silicon counterparts that overrides the math. They simply feel bad asking the silicon to do more work, if they could spend more of their own time to reduce the load by using less efficient for them / more efficient for silicon tools and techniques. For some, it seems to be damn near a moral duty to relieve the silicon of as many burdens they might believe they’re able carry instead.

And I actually respect that from an artsy, spiritual perspective! There is something beautifully wholesome about making computers do more with fewer resources. I still look oh-so-fondly back on the demo days of the Commodore 64 and Amiga. What those wizards were able to squeeze out of a mere 4kb to make the computer dance in sound and picture was truly incredible.

It just doesn’t make much economic sense, most of the time. Sure, there’s still work at the vanguard of the computing threshold. Somebody’s gotta squeeze the last drop of performance out of that NVIDIA 4090, such that our 3D engines can raytrace at 4K and 120FPS. But that’s not the reality at most software businesses that are in the business of making business software (say that three times fast!). Computers have long since been way fast enough for that work to happen without heroic optimization efforts.

And that’s the kind of work I’ve been doing for said twenty years! Making business software and selling it as SaaS. That’s what an entire industry has been doing to tremendous profit and gainful employment across the land. It’s been a bull run for the ages, and it’s been mostly driven by programmers working in high-level languages figuring out business logic and finding product-market fit.

So whenever you hear a discussion about computing efficiency, you should always have the squishy, biological cores in mind. Most software around the world is priced on their inputs, not on the silicon it requires. Meaning even small incremental improvements to bio core productivity is worth large additional expenditures on silicon chips. And every year, the ratio grows greater in favor of the bio cores.

At least up until the point that we make them obsolete and welcome our AGI overlords! But nobody seems to know when or if that’s going to happen, so best you deal in the economics of the present day, pick the most productive tool chain available to you, and bet that happy programmers will be the best bang for your buck.

MongoDB没有未来:好营销救不了烂芒果

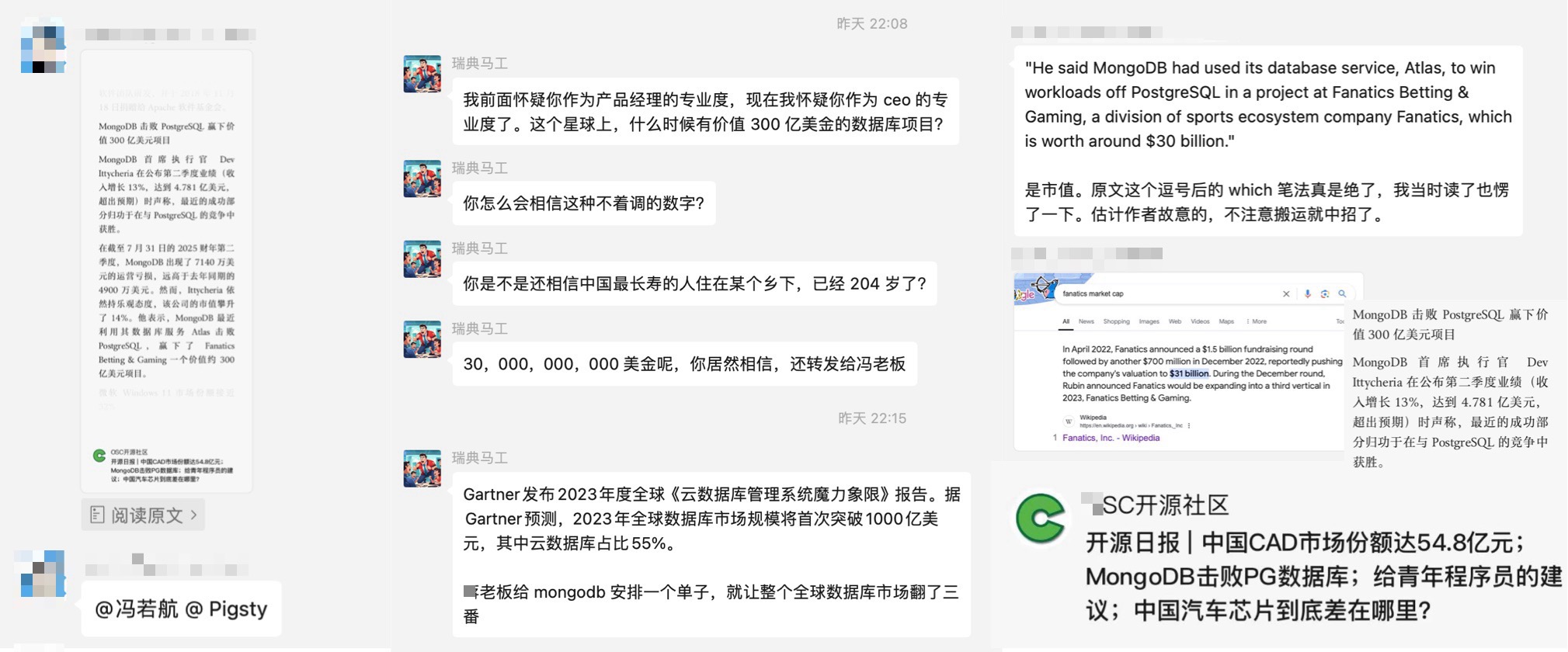

这两天 MongoDB 整的营销花活让人眼花缭乱:《MongoDB向PostgreSQL宣战》,《MongoDB 击败 PostgreSQL 赢下价值 300 亿美元项目》,以及原文 The Register 的《MongoDB在战胜强敌之后准备乱拳干翻 PostgreSQL》,活生生一副要乱拳打死老师傅的架势。

有朋友得意洋洋的特意转给我想看 PG 的笑话,这着实让我感到无奈 —— 这么离谱的新闻都有人信! 但事实是 —— 这么离谱的东西真就有人信! 包括某些CEO也照样会中招翻车。诚如石破天祖师爷所说:“永远不要低估好营销对烂产品的影响”。

把东西卖给估值300亿的公司,和做 300 亿的项目完全是两码事。当然,这不能怪人家眼拙,这是 MongoDB 在营销上的一贯伎俩 —— 如果不仔细看原文,很难区分这个 300 亿指的是项目价值还是公司估值。

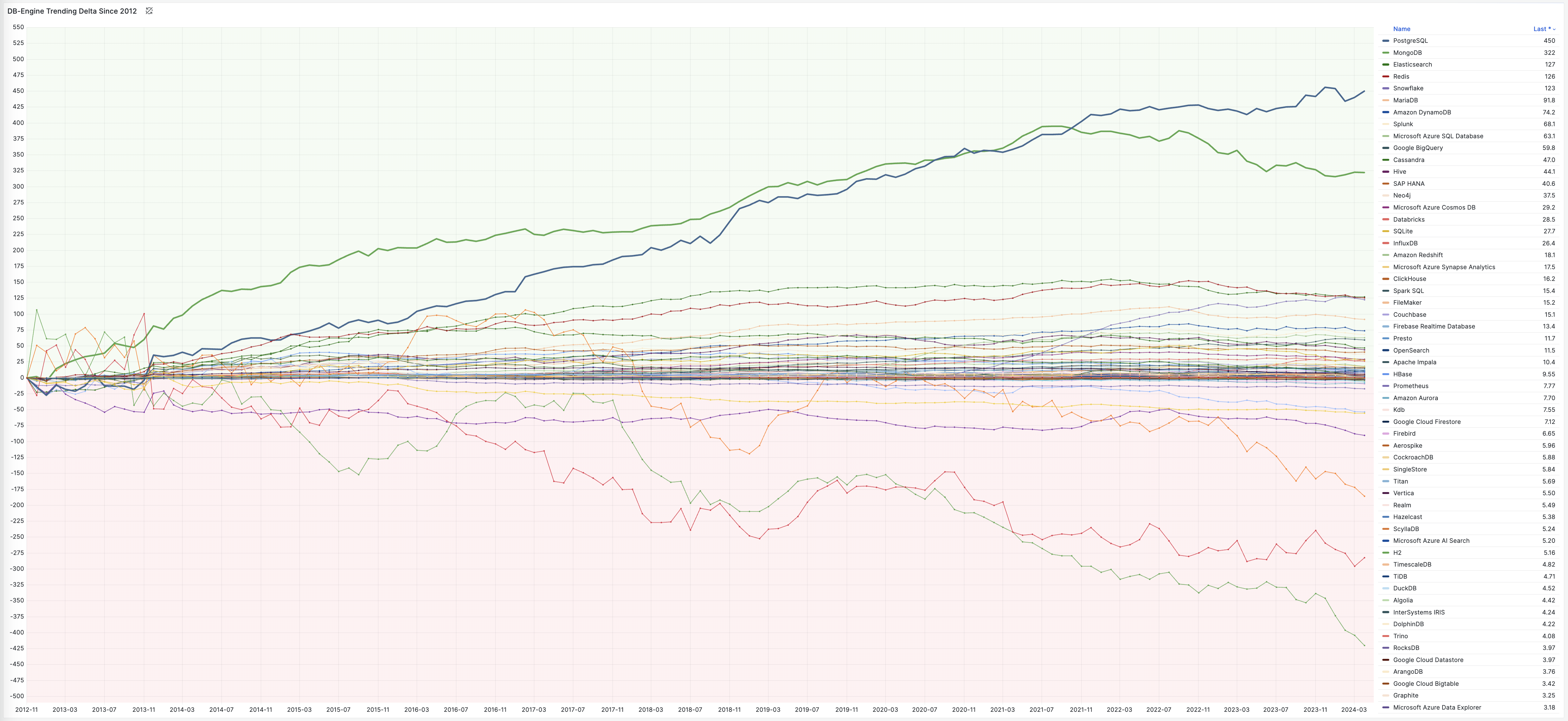

在当下,MongoDB 在产品和技术上乏善可陈;在正确性,性能,功能以及各种维度上被 PostgreSQL 按在地上摩擦;在开发者中的流行度与口碑,以及DB-Engine 热度都不断下滑,MongoDB 公司本身也不赚钱,股价也刚经过大腰斩,亏损继续扩大;“营销” 也许是 MongoDB 唯一能拿出手的东西了。

然而诚信是商业的根本,“好营销救不了烂芒果”,建立在谎言与忽悠之上的营销不会有好下场。今天我就来带大家看看,MongoDB 营销的锦绣丝绸被套里,填进去的都是些什么烂棉花。

烂产品靠营销上位

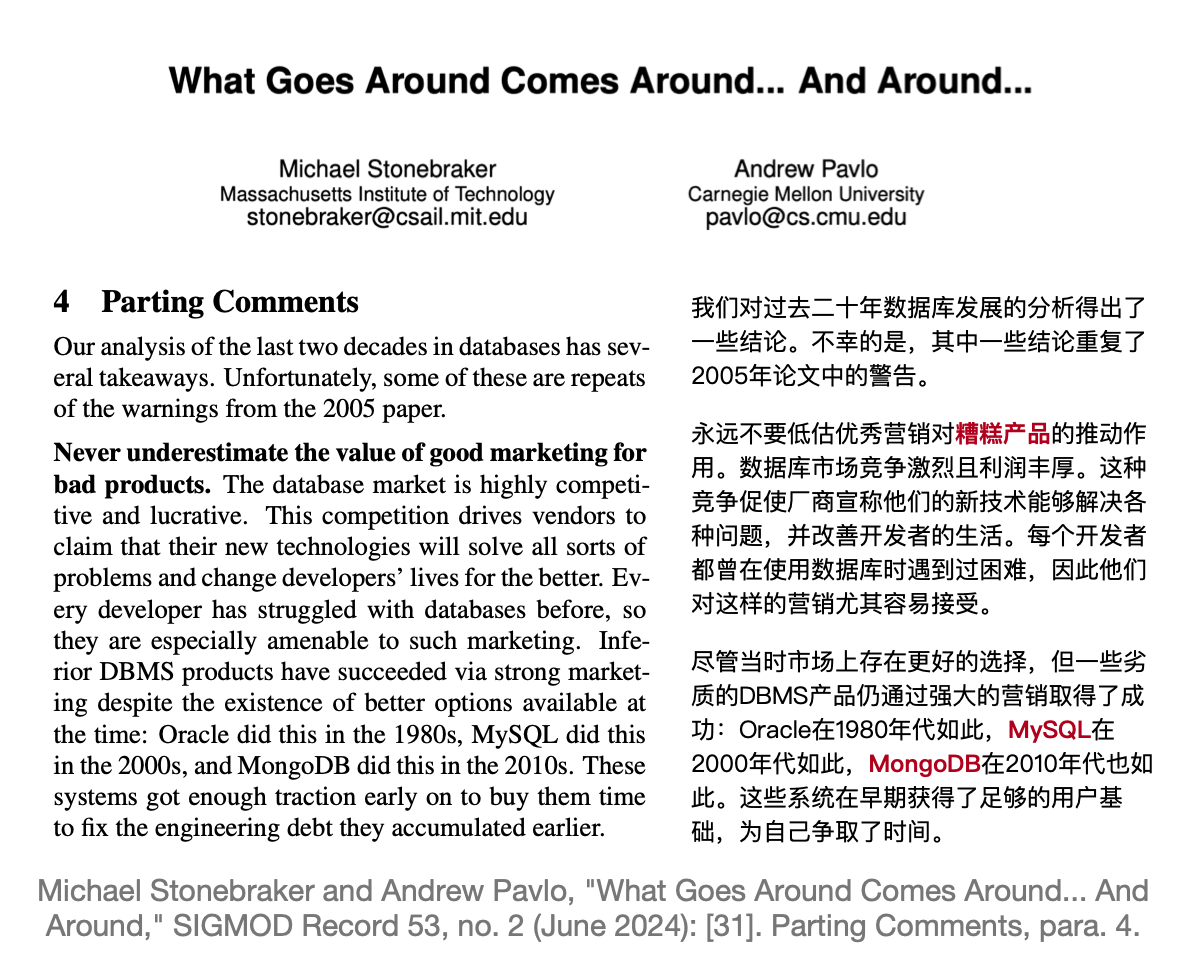

图灵奖得主,数据库祖师爷 Stonebraker 老爷子在最近在 SIGMOD 2024 发表的名著级论文《What goes around comes around… And Around》中对此有过精辟的评价:“绝对不要低估好营销对烂产品的影响 —— 比如 MySQL 与 MongoDB”。

这个世界上有许多烂数据库 —— 但能用三寸不烂之舌把烂货成功吹成宝贝卖出去的,MongoDB 说自己是第一,MySQL 也只自认老二屈居人下。

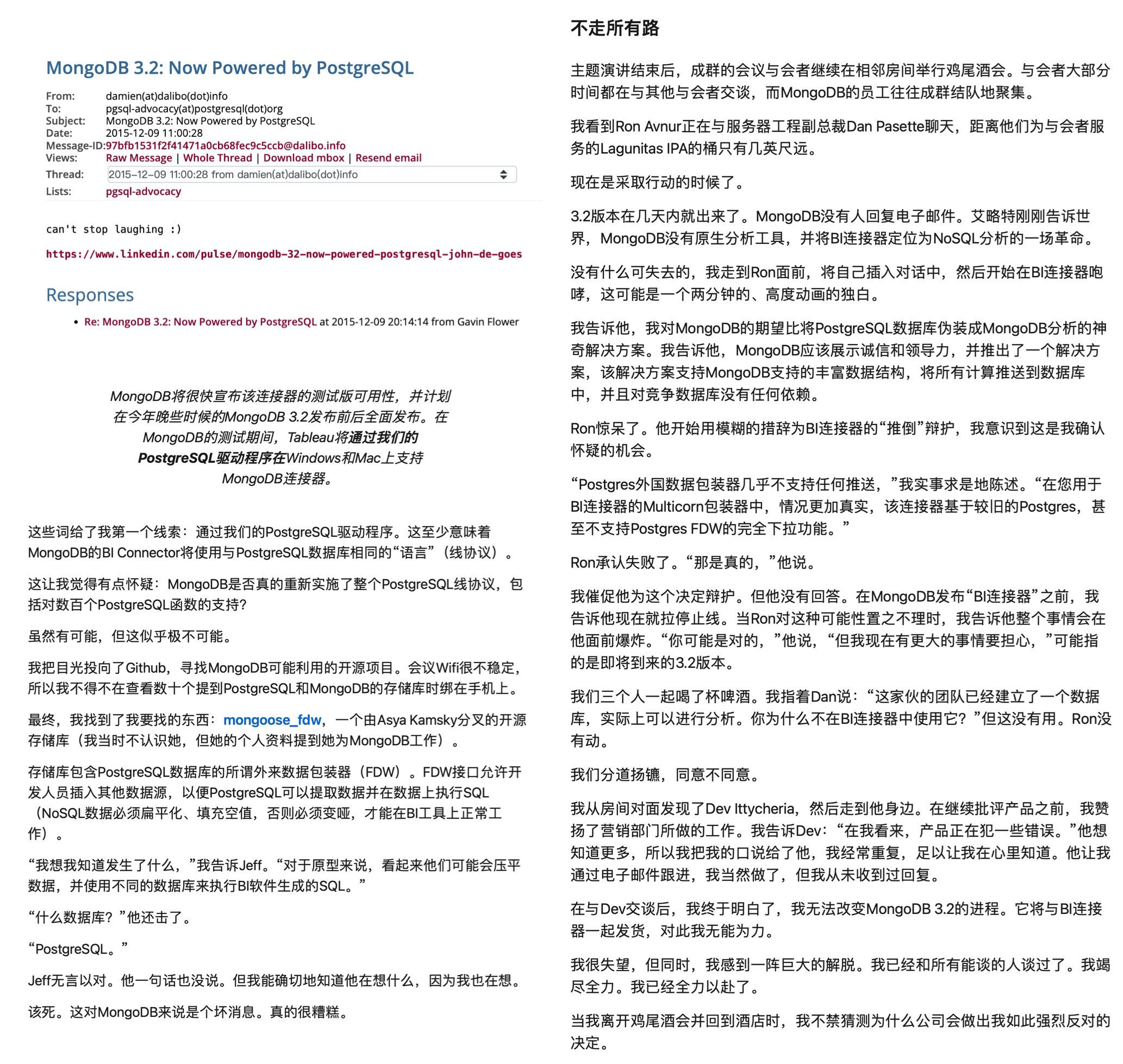

在所有关于 MongoDB 大忽悠的故事中,最让人印象深刻的是 LinkedIn 上的这篇《MongoDB 3.2 —— 现由 PostgreSQL 强力驱动》 。 这篇文章的精彩之处在于,它是由 MongoDB 合作伙伴发出的血泪控诉:MongoDB 无视了自己合作伙伴的忠言劝告,拿了一个 PostgreSQL 伪装成自己的分析引擎,并在发布会上忽悠用户。

作者作为 MongoDB 在分析领域的合作伙伴彻底灰心丧气,公开撰文发起控诉 —— “MongoDB 的分析引擎是一个 PostgreSQL ,那你们真还不如直接去用 PostgreSQL”。

像这样刻意造假忽悠的案例绝非个例,MongoDB 还在贬低同业产品自抬身价上有诸多记录。例如在官网文章《从PostgreSQL迁移到MongoDB》中,MongoDB 宣称自己是 “可扩展灵活的新一代现代通用数据库”, 而 PostgreSQL 是 “复杂且容易出错的老旧单片关系数据库”。完全无视了其实自己在整体的性能,功能,正确性,甚至自己标榜的应对大数据量的吞吐与可伸缩性上完全被 PostgreSQL 吊打的事实。

功能被PGSQL覆盖

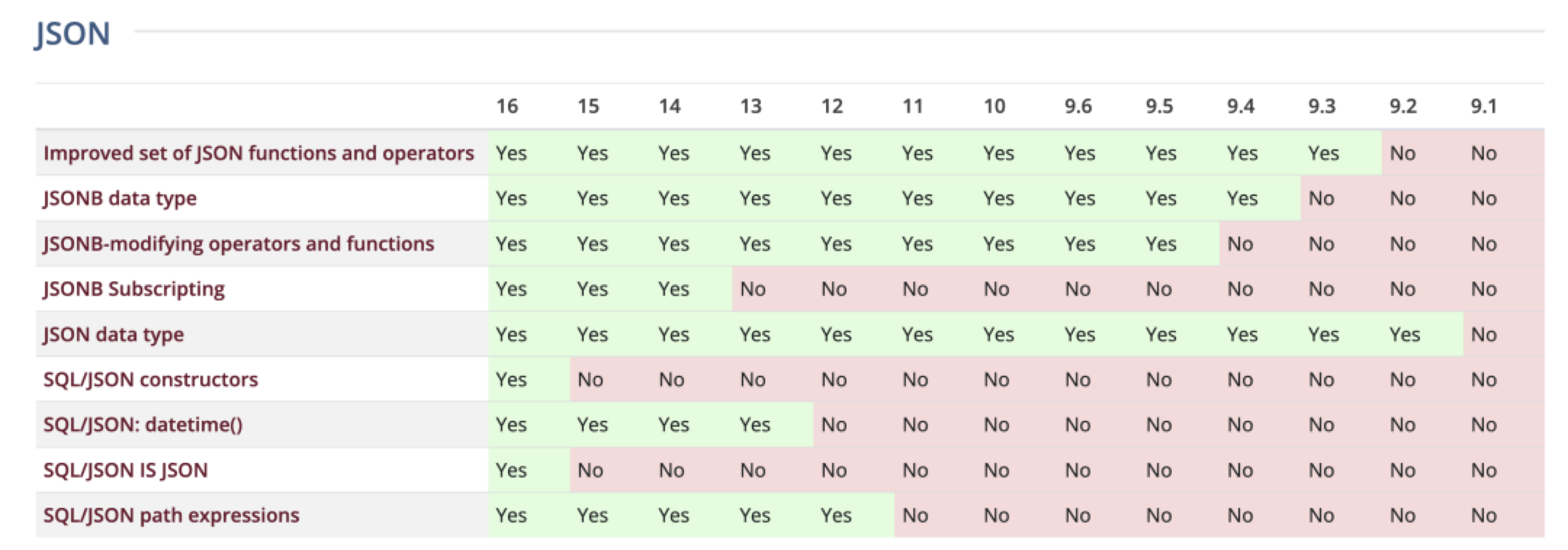

JSON 文档确实是一个很受互联网应用开发者喜爱的特性。然而提供这一能力的数据库并非只有 MongoDB 。PostgreSQL 在十年前就已经提供了 SOTA 水平的 JSON 支持,并且仍然在不断演进改善。

PostgreSQL 的 JSON 支持是所有关系型数据库中最成熟与最早的(2012-2014),早于 SQL/JSON 标准或者说直接影响了 SQL/JSON 标准建立(2016)。 更重要的是,它的文档特性实现质量很高。相比之下 —— 同样在营销上号称支持 JSON 的MySQL,实际上是个简陋的 BLOB 换皮,跟 9.0 向量类型有一拼)。

数据库祖师爷 Stonebraker 表示过,带有可扩展类型的关系模型早已覆盖了数据库世界的各个角落,而 NoSQL 运动是数据库发展历史上的一段弯路:关系模型是向下兼容文档模型的。 文档模型跟几十年前范式化 vs 反范式化的大讨论实质是一样的 —— 1.只有有任何非一对多的关系,就会出现数据重复;2. 用预计算的JOIN未必比现场JOIN更快;3 数据没有独立性。 用户可以假设自己的应用场景是独立 KV 式缓存访问,但哪怕只要添加一个稍微复杂一点的功能,开发者就会面临几十年前就讨论过的数据重复困境。

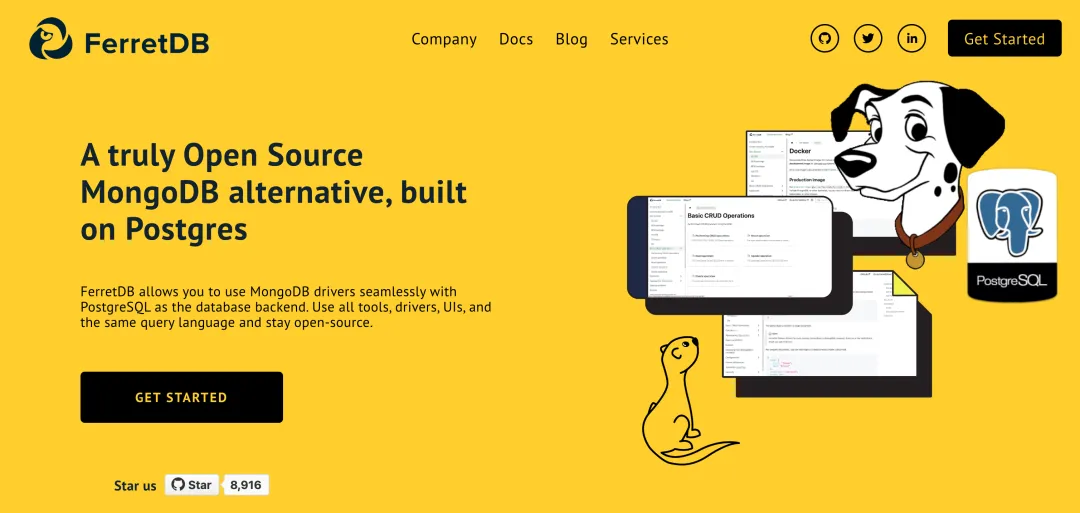

PostgreSQL 在功能上是 MongoDB 的上位替代,所以可以对 MongoDB 的用例做到向下兼容 —— PostgreSQL 能做的MongoDB 做不了;而 MongoDB 能做的 PostgreSQL 也能做:你可以在PG中创建一个只有 data JSONB 列的表,然后使用各种 JSON 查询与索引来处理这里的数据;如果你确实觉得花几秒钟建表仍然是一个额外负担,那么在生态中还有各种各样基于 PostgreSQL 提供 MongoDB API,甚至 MongoDB 线缆协议的解决方案。

例如,FerretDB 项目通过中间件的方式在 PostgreSQL 集群上实现了 MongoDB 线缆协议兼容性 —— MongoDB 应用甚至都不需要更换客户端驱动,修改业务代码就能迁移到 PostgreSQL 上。

(另一被原位兼容的是 SQL Server ); PongoDB 则是直接在 NodeJS 客户端驱动侧将 PG 仿真成一个 MongoDB。

此外还有 mongo_fdw,可以让 PG 从 MongoDB 中用 SQL 读取数据,wal2mongo 将 PG 变更抽取为 BSON。

例如 FerretDB 项目通过中间件的方式在 PostgreSQL 集群上实现了 MongoDB 线缆协议兼容性 —— MongoDB 应用甚至都不需要更换客户端驱动,修改业务代码就能迁移到 PostgreSQL 上。(另一被原位线缆兼容的是 SQL Server );PongoDB 则是直接在 NodeJS 客户端驱动侧将 PG 仿真成一个 MongoDB。此外还有 mongo_fdw,可以让 PG 从 MongoDB 中用 SQL 读取数据,wal2mongo 将 PG 变更抽取为 BSON。

在易用性上,各家云厂商都推出了开箱即用的 PG RDS 服务,想要开源自建也有 Pigsty 这样开箱即用的解决方案,还有 Serverless 的 Neon 更是让PG上手门槛低到一行命令就能直接用起来。

此外,相比于 MongoDB 使用的 SSPL 协议(已经不再是一个开源协议了),PostgreSQL 使用的类 BSD 开源协议显然要友善的多,PG可以在不需要软件授权费的情况下,提供更好的上位功能替代 —— Do more pay less! 不赢都难。

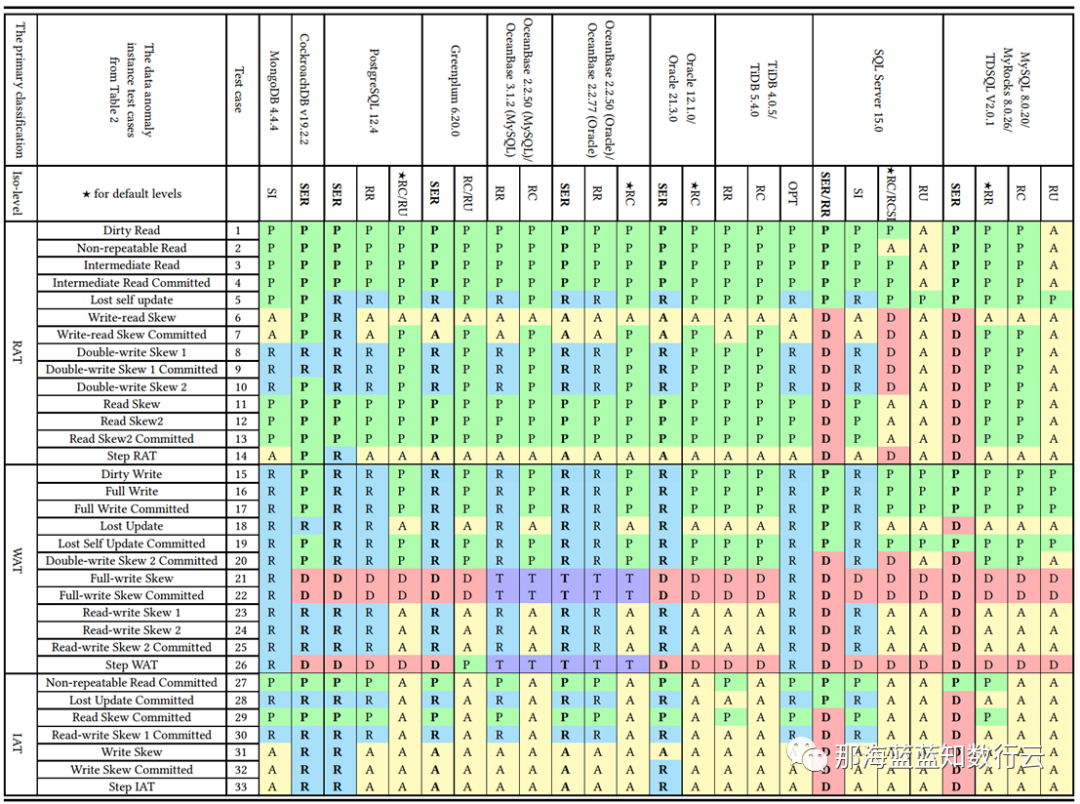

正确性与性能被吊打

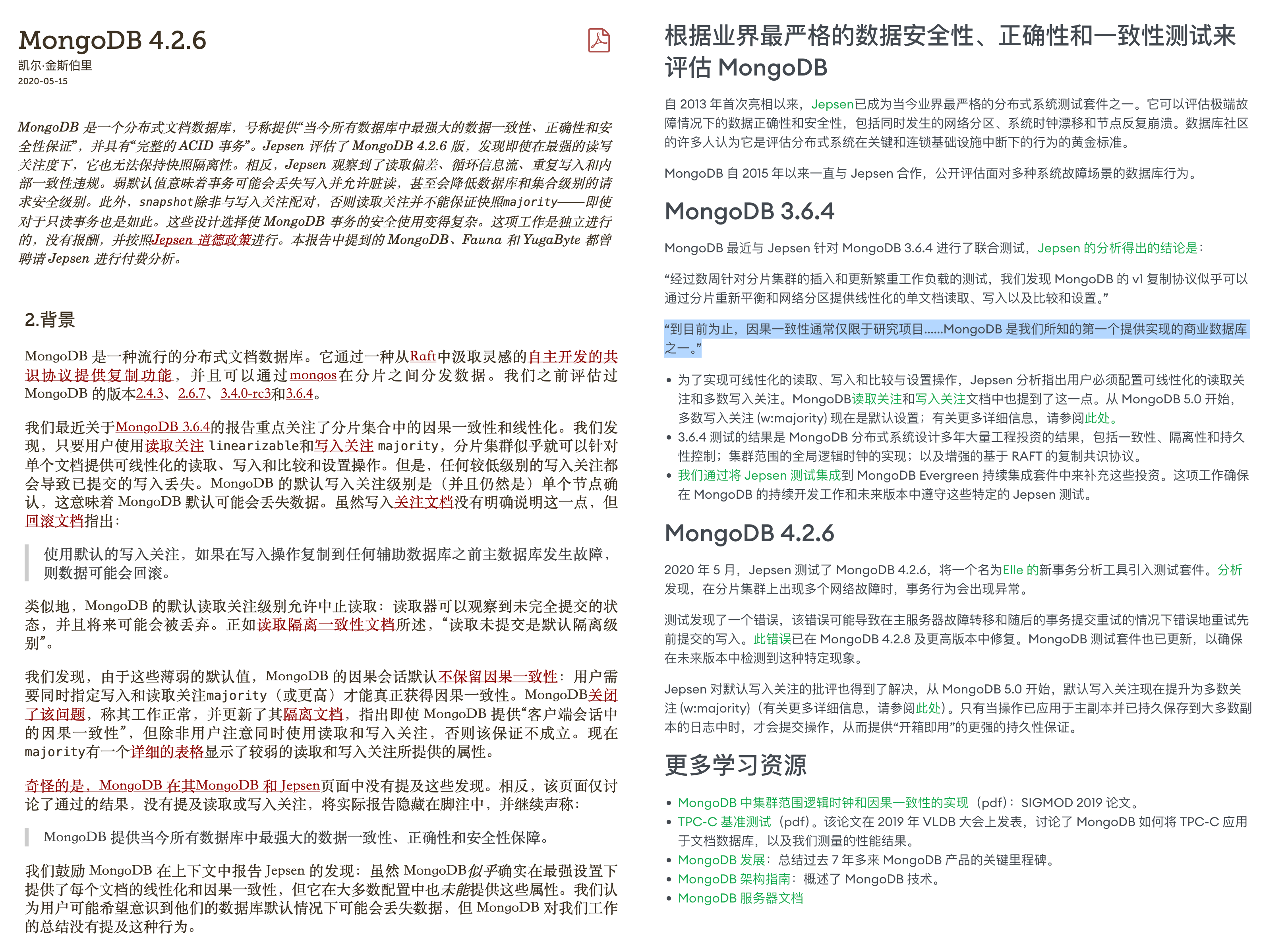

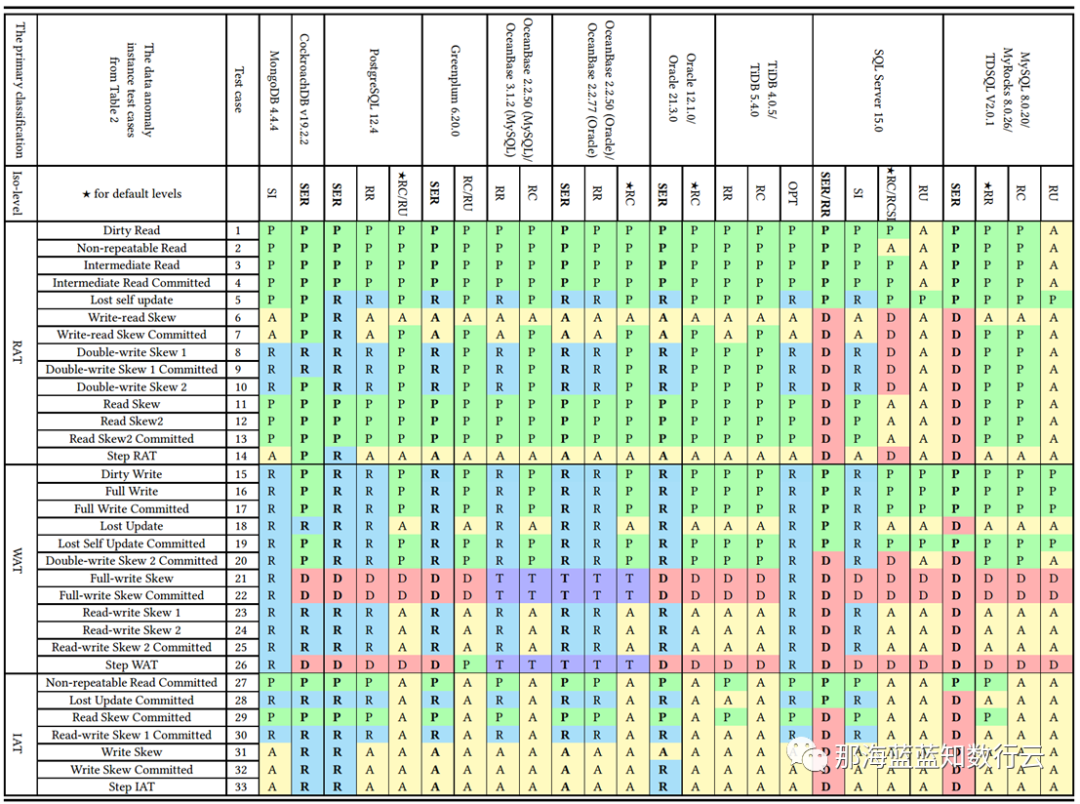

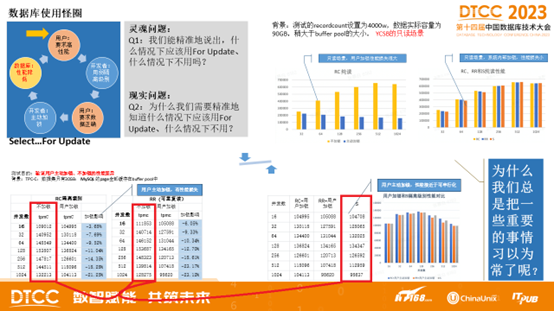

对于数据库来说,正确性至关重要 —— 中立的分布式事务测试框架 JEPSEN 对 MongoDB 的正确性做过评测:结果可以用 “一塌糊涂”形容(BTW:另一个难兄难弟是 MySQL)。

当然,MongoDB 的强项就是面不改色心不跳的 “忽悠“,尽管 JEPSEN 提了这么多的问题,在 MongoDB 官网上,关于 Jespen 的评测是这么介绍的:”到目前为止,因果一致性通常仅限于研究项目……MongoDB 是我们所知的第一个提供实现的商业数据库之一“

这个例子再次体现了 MongoDB 在营销上的脸皮 —— 用一种极其精致的语言艺术,从一大坨 Bullshit 中精心挑选出了一颗未消化的花生米,而一笔带过在正确性/一致性上的各种致命硬伤。

另一个有趣的点是性能。作为一个专用的文档数据库,性能 应当是其相对于通用数据库的杀手级特性。

先前有一篇《《从 MongoDB 到 PostgreSQL 的大迁移》引发了 MongoDB 用户的关注,我的用户群里有位朋友 @flyingcrp 问了这样一个问题 —— 为什么PG上的一个插件或者功能点就能顶得上别人一个完整的产品?

当然也不乏持相反观点的朋友 —— PG的 JSON 性能肯定比不过细分领域的专业产品 —— 一个专用数据库如果连性能都干不过通用数据库,那还活个什么劲儿?

这个讨论引起了我的兴趣,这些命题成立吗?于是,我做了一些简单的检索与研究,结果发现了一些非常有趣且震惊的结论:例如,在 MongoDB 的看家本领 —— JSON 存储与检索性能上,PostgreSQL 已经吊打 MongoDB 了。

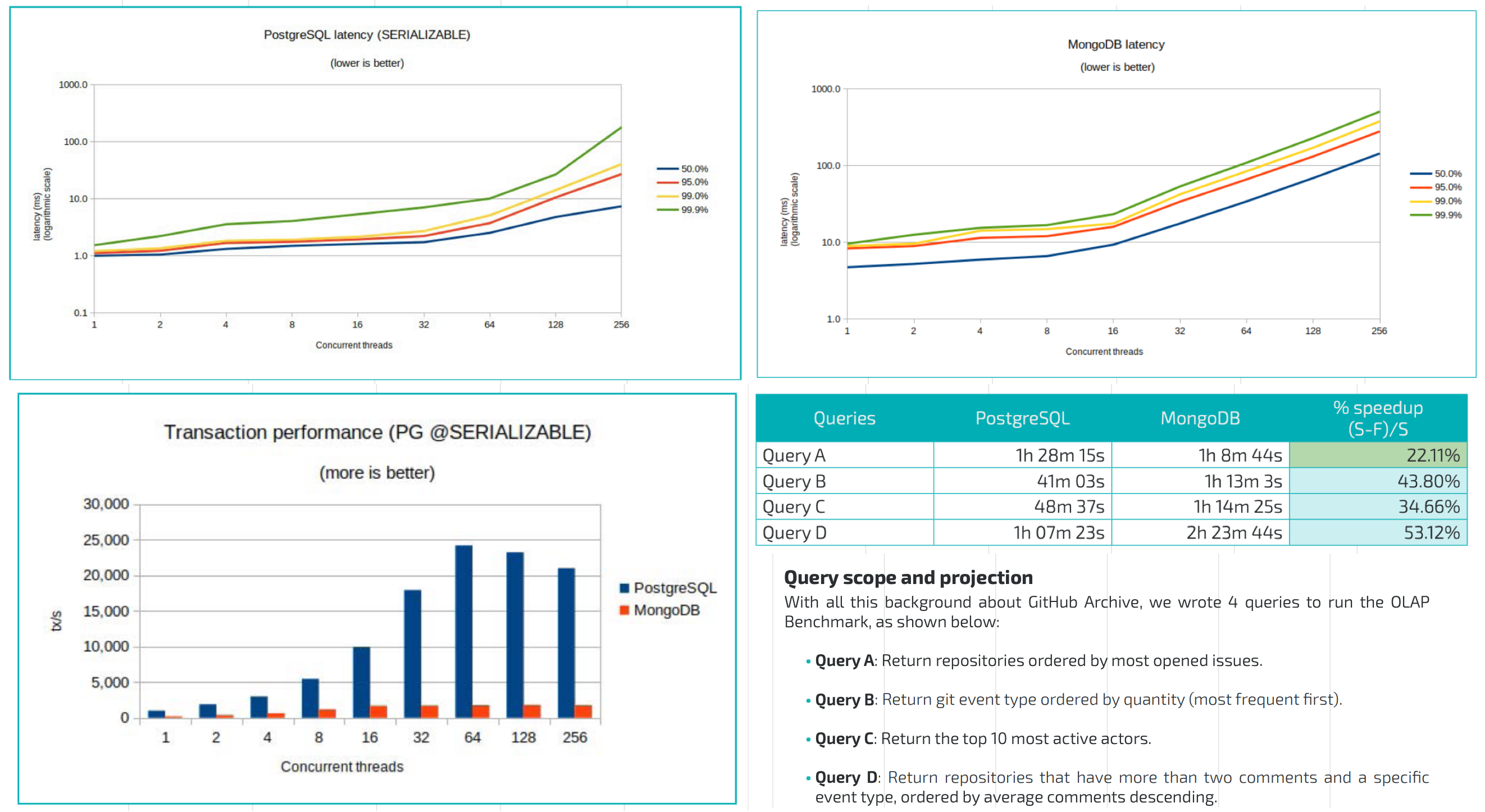

来自 ONGRES 与 EDB 的一份 PG vs Mongo 性能对比评测报告 详细对比了两者在 OLTP / OLAP 上的性能,结果一目了然。

另一份更近一点的性能对比 着重测试了 JSONB / GIN 索引下的表现对比,得出的结论也是:PostgreSQL JSONB 列是 MongoDB 的替代。

在当下,单机 PostgreSQL 性能 可以轻松 Scale 到几十TB ~ 几百TB数量级,支撑几十万的点写入 QPS 与几百万的点查询 QPS。只用 PostgreSQL 支撑业务到百万日活 / 百万美元营收甚至直接 IPO 都毫无问题。

老实说,MongoDB 的性能已经完全跟不上时代了,而它引以为傲的“内置分片”可伸缩性,在软件架构与性能突飞猛进,硬件遵循摩尔定律指数发展 的当下显得毫无意义。

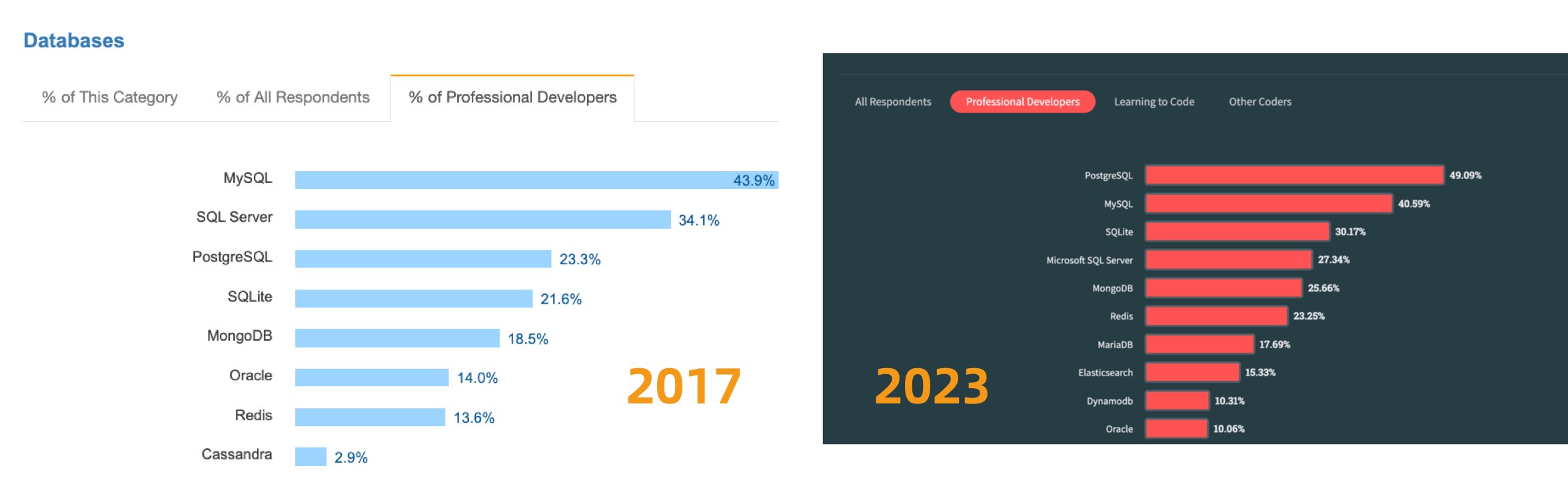

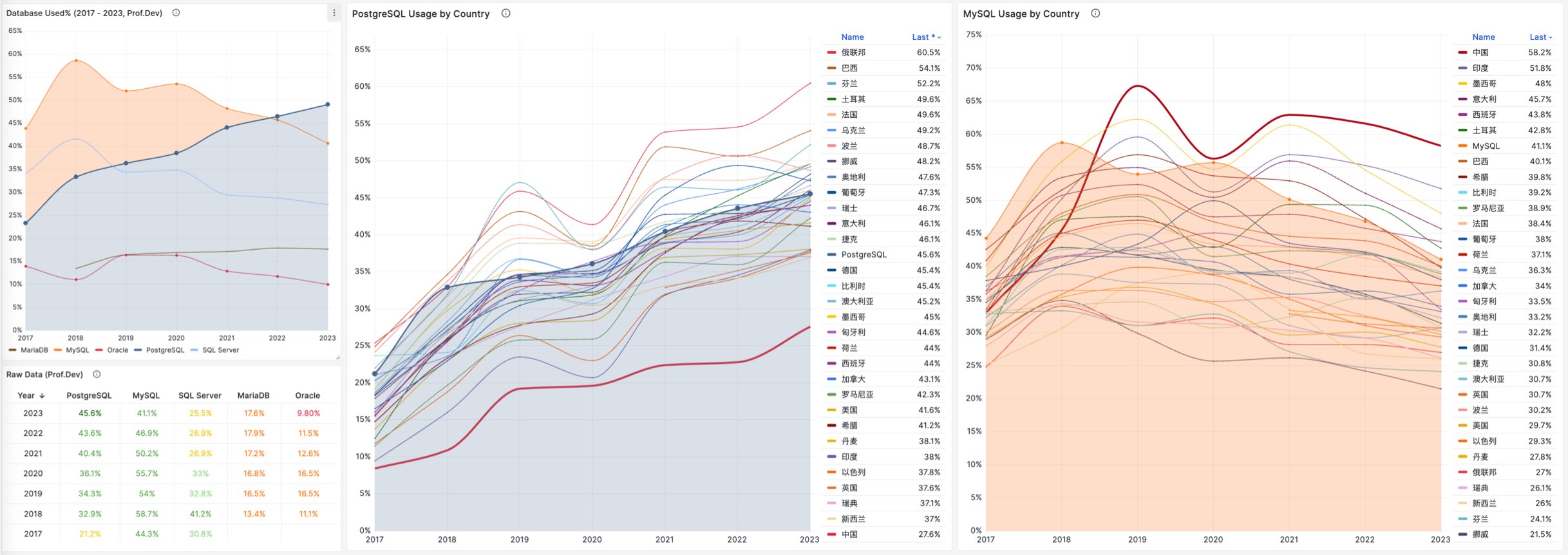

流行度热度在衰退

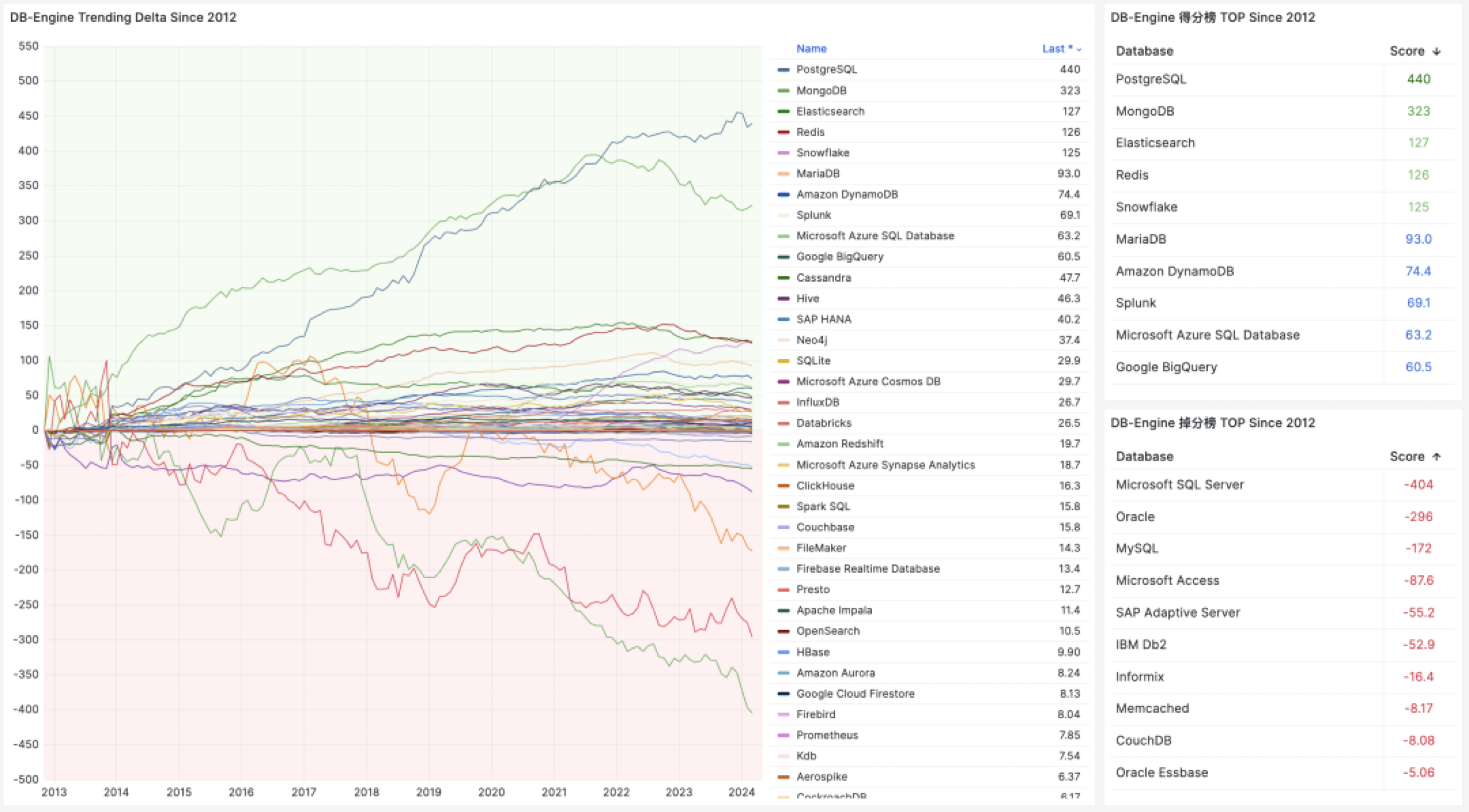

如果我们观察 DB-Engine 热度分数,不难看出过去十年中,拥有最大增长的两个数据库就是 PostgreSQL 与 MongoDB 。可以说这两者是移动互联网时代中数据领域的最大赢家。

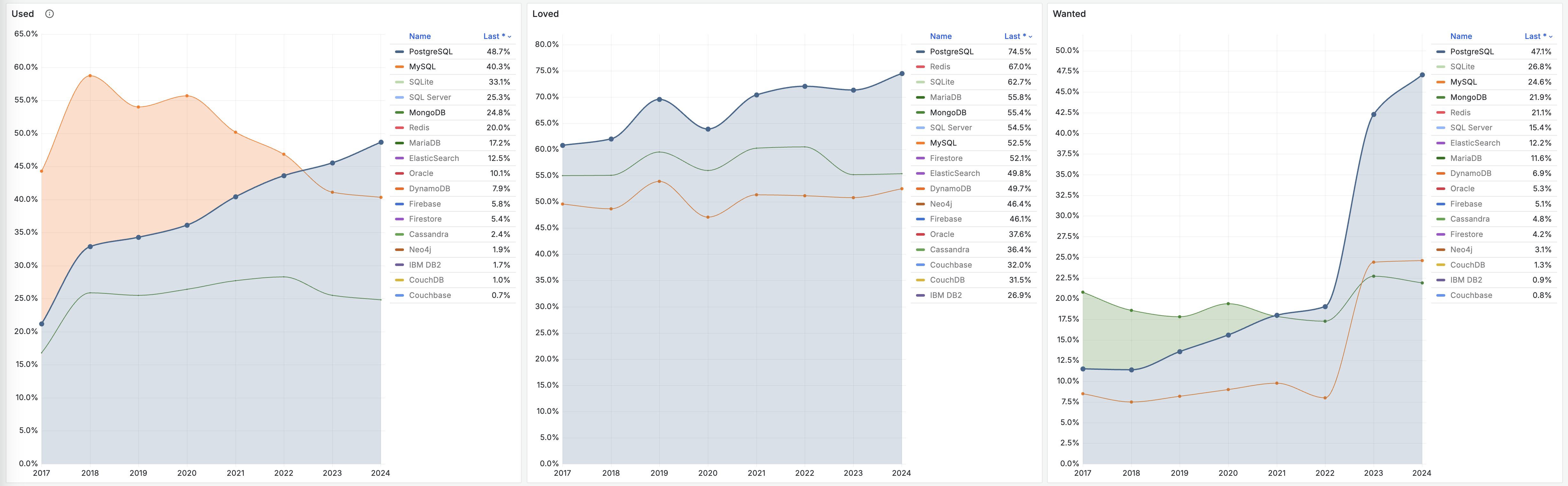

但它们的区别在于,PostgreSQL 仍然在继续增长,甚至已经在 StackOverflow 全球开发者调研中,连续三年成为 最流行的数据库 并势头不减赢麻了。而 MongoDB 在 2021 年开始就掉头向下开始过气。使用率,口碑,需求度都出现了停滞或扭头向下的发展趋势:

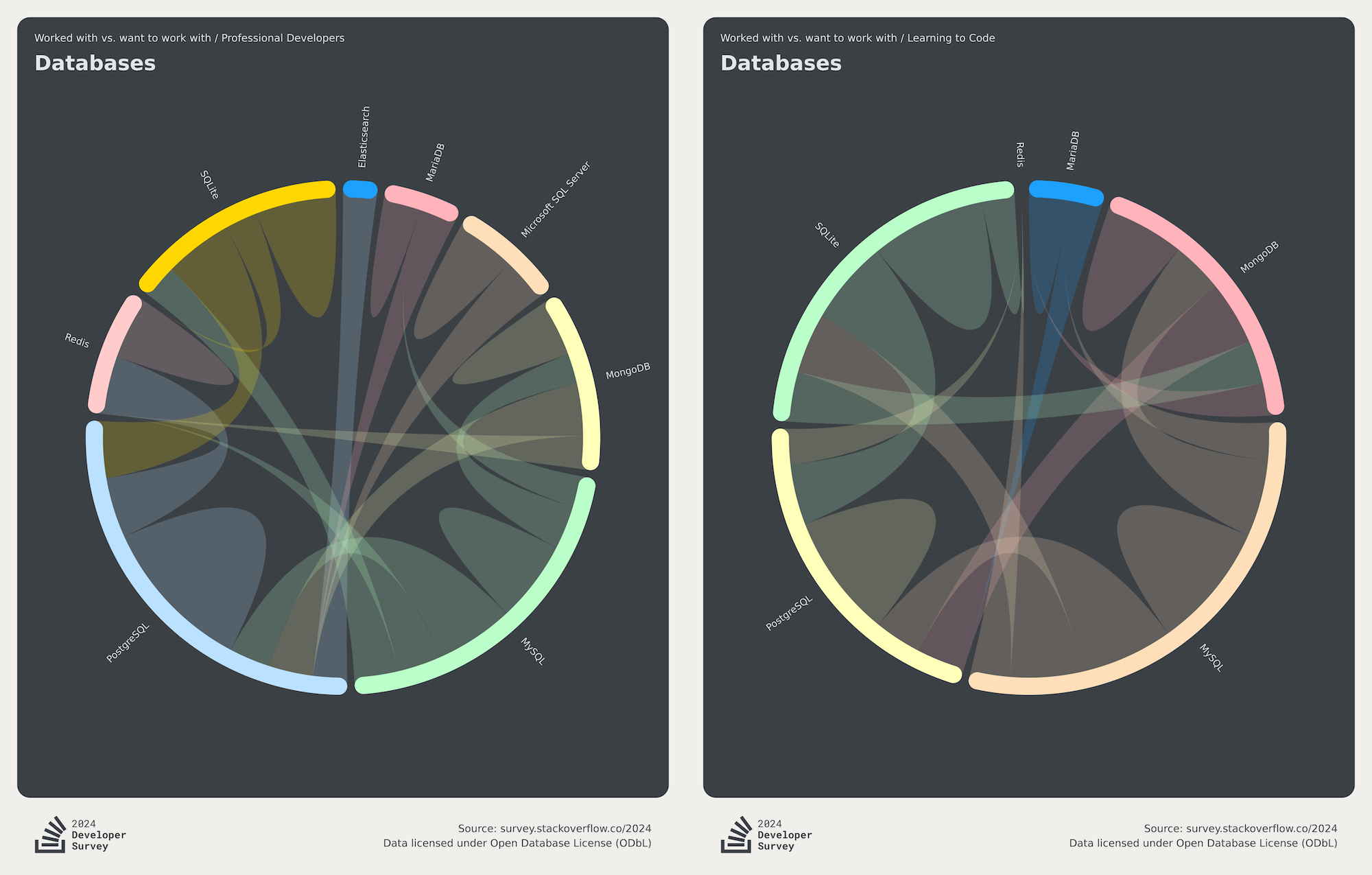

在 StackOverflow 年度全球开发者调研中,提供了主要的数据库用户的转移关系图。不难看出,MongoDB 用户的最大流出项就是 PostgreSQL。而会去使用 MongoDB 的往往是 MySQL 用户。

MongoDB 和 MySQL 属于那种典型的 “面向初学者” 的数据库,针对小白做了许多无底线讨好性的妥协设计 —— 从统计中不难看出它们在新手中的使用率比专业开发者中更高。 与之相反的则是 PostgreSQL,在专业开发者中的使用比例要比新手中高得多。

任何开发者都会经历初学者状态,我最初也是从 MySQL / Mongo 开始与数据库打交道的,但很多人就止步于此,而有追求的工程师则会不断学习进步,提升自己的品味与技术鉴别力,使用更好用、更强大的技术来更新自己的武器库。

而趋势是:越来越多的用户在提升的过程中,从 MongoDB 和 MySQL 迁移到了上位替代 PostgreSQL 中。从而成就了新一代世界上最流行的数据库 —— PostgreSQL。

风评已然臭不可闻

许多使用过 MongoDB 的开发者都对其留下了极其恶劣的印象,包括我自己。我上一次和 MongoDB 打交道是在 2016 年。我们部门先前用 MongoDB 搭建了一套实时统计平台,存放全网应用下载/安装/启动计数器,几 TB 规模的数据。我负责把这套在线业务的 MongoDB 迁移到 PostgreSQL。